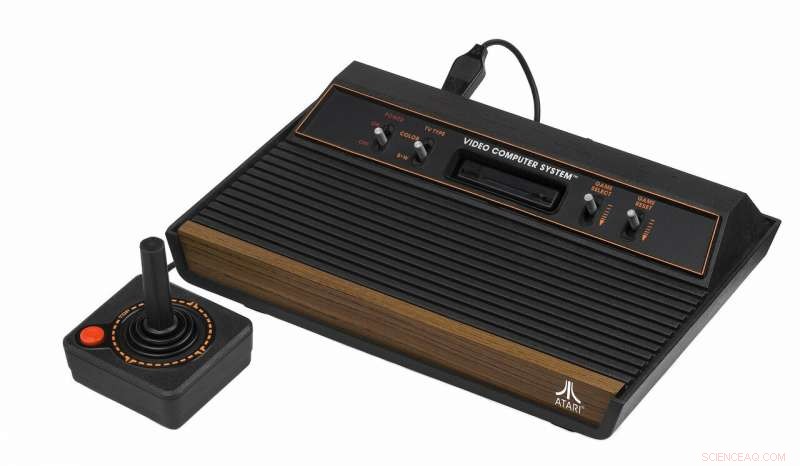

Crédito:CC0 Public Domain

Una nueva generación de algoritmos ha dominado los videojuegos de Atari 10 veces más rápido que la IA de última generación, con un enfoque innovador para la resolución de problemas.

Diseñar IA que pueda negociar problemas de planificación, especialmente aquellos donde las recompensas no son inmediatamente obvias, es uno de los desafíos de investigación más importantes para hacer avanzar el campo.

Un famoso estudio de 2015 mostró que Google DeepMind AI aprendió a jugar videojuegos de Atari como Video Pinball a nivel humano, pero notoriamente falló en aprender un camino hacia la primera clave en el videojuego Montezuma's Revenge de la década de 1980 debido a la complejidad del juego.

En el nuevo método desarrollado en RMIT University en Melbourne, Australia, Las computadoras configuradas para jugar de forma autónoma Montezuma's Revenge aprendieron de los errores e identificaron subobjetivos 10 veces más rápido que Google DeepMind para terminar el juego.

El profesor asociado Fabio Zambetta de la Universidad RMIT presenta el nuevo enfoque este viernes en la 33a Conferencia AAAI sobre Inteligencia Artificial en los Estados Unidos.

El método, desarrollado en colaboración con el profesor John Thangarajah y Michael Dann de RMIT, combina el aprendizaje por refuerzo de "palo y zanahoria" con un enfoque de motivación intrínseca que recompensa a la IA por ser curiosa y explorar su entorno.

"La IA verdaderamente inteligente debe poder aprender a completar tareas de forma autónoma en entornos ambiguos, "Dice Zambetta.

"Hemos demostrado que el tipo correcto de algoritmos puede mejorar los resultados utilizando un enfoque más inteligente en lugar de forzar un problema de un extremo a otro en computadoras muy potentes.

"Nuestros resultados muestran cuánto nos estamos acercando a la IA autónoma y podrían ser una línea de investigación clave si queremos seguir haciendo un progreso sustancial en este campo".

El método de Zambetta recompensa al sistema por explorar de manera autónoma subobjetivos útiles como 'subir esa escalera' o 'saltar ese hoyo', que puede no ser obvio para una computadora, dentro del contexto de completar una misión más grande.

Otros sistemas de vanguardia han requerido la participación humana para identificar estos subobjetivos o han decidido qué hacer a continuación al azar.

"Nuestros algoritmos no solo identificaron de manera autónoma las tareas relevantes aproximadamente 10 veces más rápido que Google DeepMind mientras jugaban a Montezuma's Revenge, también exhibieron un comportamiento relativamente similar al humano mientras lo hacían, "Dice Zambetta.

"Por ejemplo, antes de que puedas acceder a la segunda pantalla del juego, debes identificar las subtareas, como subir escaleras, saltando sobre un enemigo y finalmente recogiendo una llave, aproximadamente en ese orden.

"Esto eventualmente sucedería al azar después de una gran cantidad de tiempo, pero que suceda de manera tan natural en nuestras pruebas muestra algún tipo de intención.

"Esto convierte al nuestro en el primer agente totalmente autónomo orientado a subobjetivos en ser verdaderamente competitivo con agentes de última generación en estos juegos".

Zambetta dijo que el sistema funcionaría fuera de los videojuegos en una amplia gama de tareas, cuando se suministra con entradas visuales sin procesar.

"Crear un algoritmo que pueda completar los videojuegos puede parecer trivial, pero el hecho de que hayamos diseñado uno que pueda hacer frente a la ambigüedad al elegir entre un número arbitrario de posibles acciones es un avance crítico.

"Esto significa que, con tiempo, esta tecnología será valiosa para lograr objetivos en el mundo real, ya sea en vehículos autónomos o como útiles asistentes robóticos con reconocimiento de lenguaje natural, " él dice.

Derivar subobjetivos de forma autónoma para acelerar el aprendizaje en dominios de recompensas dispersas (adjunto) se presentará en la 33a Conferencia AAAI sobre Inteligencia Artificial en Honolulu, Hawaii el 1 de febrero de 2019.