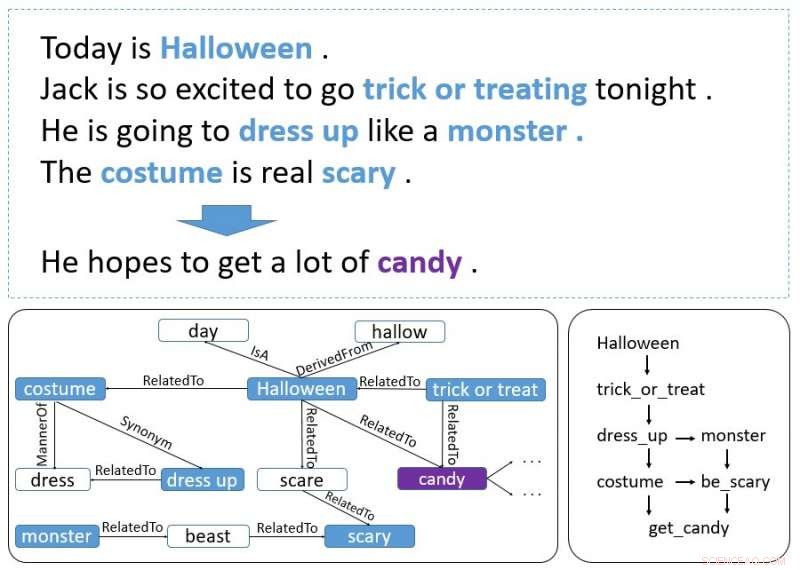

Un ejemplo de historia. Las palabras en negrita son eventos y entidades. El gráfico de la parte inferior izquierda se recupera de ConceptNet y el gráfico de la parte inferior derecha representa cómo los eventos y las entidades forman la pista del contexto. Crédito:Guan, Wang y Huang

Investigadores del Laboratorio de Inteligencia Artificial de la Universidad de Tsinghua han desarrollado recientemente un modelo incremental basado en codificador que puede generar finales de historias. Un codificador incremental es un tipo de algoritmo de compresión de codificación que se utiliza a menudo para comprimir datos ordenados, como listas de palabras u oraciones.

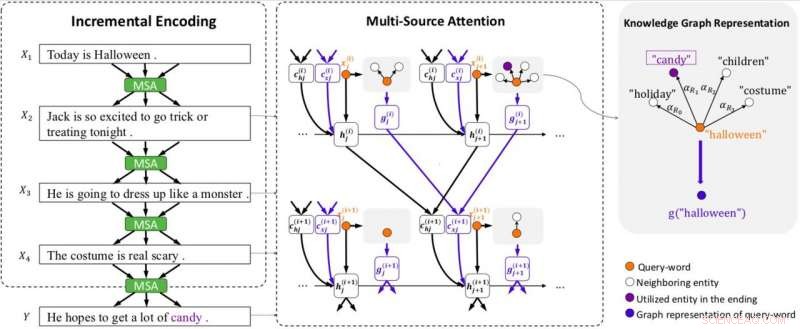

El nuevo modelo, descrito en un artículo publicado previamente en arXiv, Emplea un esquema de codificación incremental con atención de múltiples fuentes para procesar pistas de contexto que se extienden a lo largo de una historia, generando un final adecuado.

Inicialmente, los investigadores estaban interesados en el Story Cloze Test (SCT), en el que un sistema elige un final correcto para una historia entre dos posibilidades disponibles. La investigación anterior se centró en esta prueba en particular para desarrollar herramientas de generación de final de historia, pero el estudio reciente lleva esta idea un paso más allá.

"Pensamos, ¿Por qué no desarrollar un modelo que pueda generar un final por sí solo? Entonces se nos ocurrió la tarea de generación del final de la historia, "Yansen Wang, uno de los investigadores que llevó a cabo el estudio le dijo a TechXplore. "Sin embargo, pronto, Descubrimos que generar un final de historia razonable es una tarea mucho más desafiante que la original porque requiere capturar información lógica y de causalidad que puede abarcar varias oraciones del contexto de una historia. El uso del sentido común también es necesario en esta tarea, lo cual no es tan importante si se dan dos posibles finales ".

Descripción general del modelo. El modelo está equipado con codificación incremental (IE) y atención de múltiples fuentes (MSA) (incluida la atención de gráficos para representar gráficos de conocimiento). MSA produce vectores de contexto de estado (c (i) hj) atendiendo a los estados ocultos (h (i) j), y vectores de contexto de conocimiento (c (i) xj) atendiendo a los vectores gráficos (g (i) j) de la oración anterior. IE utiliza los vectores de contexto de estado y conocimiento para construir codificaciones de contexto de forma incremental. Cada gráfico está representado por un vector (g (i) j) usando la atención del gráfico. x (i) j denota la j-ésima palabra en la oración i. Crédito:Guan, Wang y Huang

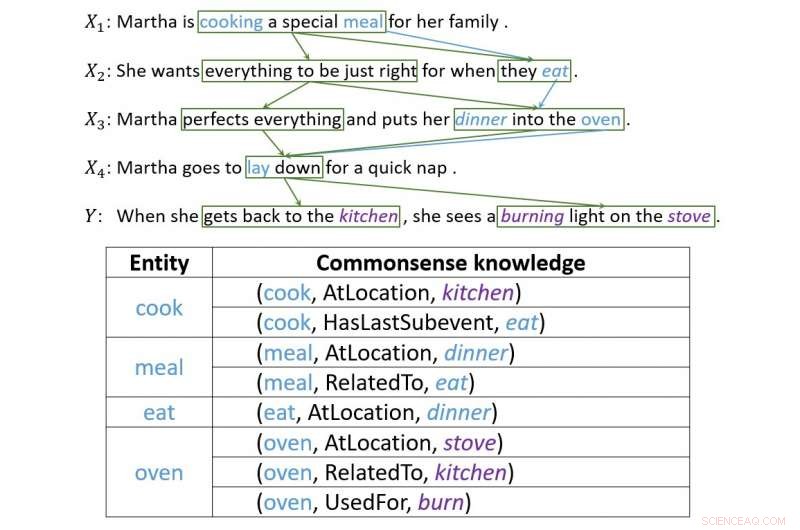

Para abordar estos dos desafíos, los investigadores desarrollaron un esquema de codificación incremental con un mecanismo de atención de múltiples fuentes que puede generar finales de historia efectivos. Este sistema funciona codificando el contexto de una historia de forma incremental, con su mecanismo de atención de fuentes múltiples que utiliza tanto pistas contextuales como conocimientos de sentido común.

"El esquema de codificación incremental que desarrollamos puede codificar los estados anteriores que contienen información y relaciones entre palabras de forma incremental, "Dijo Wang." El mecanismo de atención de fuentes múltiples encontrará y capturará el orden cronológico o la relación causal entre entidades o eventos en oraciones adyacentes. Para utilizar el conocimiento del sentido común, un jefe de la atención de fuentes múltiples señalará una representación lógica de palabras, que contiene conocimientos de sentido común obtenidos de ConceptNet ".

Diseñar este modelo resultó ser una tarea difícil y compleja, ya que hubo que superar varios desafíos para garantizar que el sistema produjera finales sensibles. De hecho, un final de historia eficaz debe considerar varios aspectos de la historia, encajan bien con su contexto y también tienen un sentido razonable.

"La generación del final de la historia requiere capturar la lógica y la causalidad de la información, "Explicó Wang." Este tipo de información no es solo punto a punto. En la mayoría de los casos, forma una estructura más compleja, lo que la gente llama "pista de contexto". Pasamos mucho tiempo diseñando nuestro modelo, luego surgió el esquema de codificación incremental. La atención entre oraciones forma naturalmente una estructura similar a una red, y la información lógica transmitida por la atención es justo lo que queríamos ".

Un ejemplo que ilustra cómo la codificación incremental crea conexiones entre pistas de contexto. Crédito:Guan, Wang y Huang

Los investigadores evaluaron su modelo y lo compararon con otros sistemas de generación de final de historia. Descubrieron que podría generar finales de historia mucho más apropiados y razonables que las líneas de base de última generación.

"Al probar el modelo, logramos resultados encantadores, "Dijo Wang." En los siguientes experimentos, también descubrimos que este esquema podría pasar más información, incluido el conocimiento del sentido común, sólo si podemos representar este tipo de información correctamente. Esto demuestra la flexibilidad de nuestro esquema ".

El modelo diseñado por Wang y sus colegas demuestra hasta dónde puede llegar la última tecnología, incluso en tareas que hasta ahora han sido realizadas principalmente por humanos. Si bien ha logrado resultados muy prometedores, los investigadores creen que todavía hay un gran margen de mejora.

"Ahora estamos tratando de aplicar este marco en un corpus de historias más largo, dado que la extensión de las historias en SCT no es demasiado larga, "dijo Wang." Además, Dado que el marco de codificación incremental puede transportar diferentes tipos de información, estamos tratando de aplicarlo a otros tipos de tareas que implican el paso de información a largo plazo, como la generación de conversaciones de varios turnos ".

© 2018 Tech Xplore