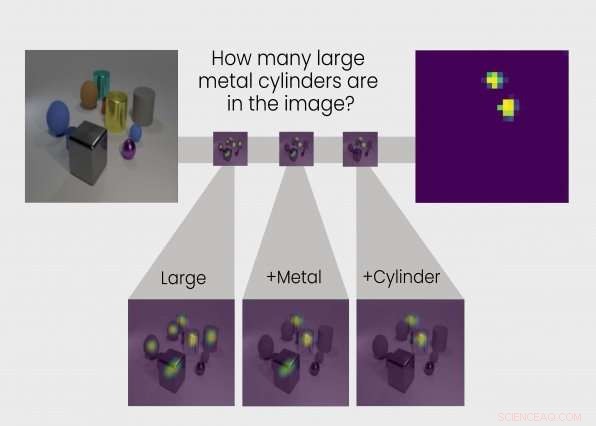

TbD-net resuelve el problema de razonamiento visual dividiéndolo en una cadena de subtareas. La respuesta a cada subtarea se muestra en mapas de calor que destacan los objetos de interés, permitiendo a los analistas ver el proceso de pensamiento de la red. Crédito:Grupo de Tecnologías de Inteligencia y Decisión

Aprendemos a través de la razón cómo interpretar el mundo. Entonces, también, hacer redes neuronales. Ahora, un equipo de investigadores del Grupo de Tecnologías de Decisión e Inteligencia del Laboratorio Lincoln del MIT ha desarrollado una red neuronal que realiza pasos de razonamiento similares a los humanos para responder preguntas sobre el contenido de las imágenes. Nombrada Red de Transparencia por Diseño (TbD-net), el modelo representa visualmente su proceso de pensamiento a medida que resuelve problemas, permitiendo a los analistas humanos interpretar su proceso de toma de decisiones. El modelo funciona mejor que las mejores redes neuronales de razonamiento visual de la actualidad.

Comprender cómo una red neuronal toma sus decisiones ha sido un desafío de larga data para los investigadores de inteligencia artificial (IA). Como sugiere la parte neuronal de su nombre, Las redes neuronales son sistemas de inteligencia artificial inspirados en el cerebro destinados a replicar la forma en que los humanos aprenden. Consisten en capas de entrada y salida, y capas intermedias que transforman la entrada en la salida correcta. Algunas redes neuronales profundas se han vuelto tan complejas que es prácticamente imposible seguir este proceso de transformación. Por eso se denominan sistemas de "caja negra", con su interior exacto opaco incluso para los ingenieros que los construyen.

Con TbD-net, los desarrolladores tienen como objetivo hacer que estos funcionamientos internos sean transparentes. La transparencia es importante porque permite a los humanos interpretar los resultados de una IA.

Es importante saber por ejemplo, qué es exactamente lo que una red neuronal utilizada en los vehículos autónomos cree que es la diferencia entre una señal para peatones y una señal de alto, y en qué punto de su cadena de razonamiento ve esa diferencia. Estos conocimientos permiten a los investigadores enseñar a la red neuronal a corregir cualquier suposición incorrecta. Pero los desarrolladores de TbD-net dicen que las mejores redes neuronales actuales carecen de un mecanismo eficaz para permitir que los humanos comprendan su proceso de razonamiento.

"El progreso en la mejora del rendimiento en el razonamiento visual se ha producido a costa de la interpretabilidad, "dice Ryan Soklaski, que construyó TbD-net con sus colegas investigadores Arjun Majumdar, David Mascharka, y Philip Tran.

El grupo del Laboratorio Lincoln pudo cerrar la brecha entre el rendimiento y la interpretabilidad con TbD-net. Una clave de su sistema es una colección de "módulos, "Pequeñas redes neuronales que están especializadas para realizar subtareas específicas. Cuando a TbD-net se le hace una pregunta de razonamiento visual sobre una imagen, desglosa la pregunta en subtareas y asigna el módulo apropiado para cumplir con su parte. Como trabajadores en una línea de montaje cada módulo se basa en lo que el módulo antes de haber descubierto para eventualmente producir el final, respuesta correcta. Como un todo, TbD-net utiliza una técnica de inteligencia artificial que interpreta preguntas del lenguaje humano y divide esas oraciones en subtareas, seguido de múltiples técnicas de inteligencia artificial de visión por computadora que interpretan las imágenes.

Majumdar dice:"Rompiendo una compleja cadena de razonamiento en una serie de subproblemas más pequeños, cada uno de los cuales se puede resolver de forma independiente y compuesta, es un medio poderoso e intuitivo para razonar ".

La salida de cada módulo se representa visualmente en lo que el grupo llama una "máscara de atención". La máscara de atención muestra manchas de mapa de calor sobre objetos en la imagen que el módulo identifica como su respuesta. Estas visualizaciones permiten al analista humano ver cómo un módulo está interpretando la imagen.

Llevar, por ejemplo, la siguiente pregunta planteada a TbD-net:"En esta imagen, ¿de qué color es el cubo de metal grande? "Para responder a la pregunta, el primer módulo localiza solo objetos grandes, produciendo una máscara de atención con esos grandes objetos resaltados. El siguiente módulo toma esta salida y encuentra cuáles de los objetos identificados como grandes por el módulo anterior también son de metal. La salida de ese módulo se envía al siguiente módulo, que identifica cuál de los grandes, Los objetos metálicos también son un cubo. Al final, esta salida se envía a un módulo que puede determinar el color de los objetos. El resultado final de TbD-net es "rojo, "la respuesta correcta a la pregunta.

Cuando se prueba, TbD-net logró resultados que superan los modelos de razonamiento visual de mejor rendimiento. Los investigadores evaluaron el modelo utilizando un conjunto de datos visuales de respuesta a preguntas que constaba de 70, 000 imágenes de entrenamiento y 700, 000 preguntas, junto con conjuntos de prueba y validación de 15, 000 imágenes y 150, 000 preguntas. El modelo inicial logró una precisión de prueba del 98,7 por ciento en el conjunto de datos, cuales, según los investigadores, supera con creces a otros enfoques basados en redes de módulos neuronales.

En tono rimbombante, los investigadores pudieron luego mejorar estos resultados debido a la ventaja clave de su modelo:la transparencia. Al observar las máscaras de atención producidas por los módulos, podían ver dónde iban las cosas y perfeccionar el modelo. El resultado final fue un rendimiento de vanguardia con una precisión del 99,1 por ciento.

"Nuestro modelo proporciona salidas interpretables en cada etapa del proceso de razonamiento visual, "Dice Mascharka.

La interpretabilidad es especialmente valiosa si los algoritmos de aprendizaje profundo se van a implementar junto con los humanos para ayudar a abordar tareas complejas del mundo real. Para generar confianza en estos sistemas, los usuarios necesitarán la capacidad de inspeccionar el proceso de razonamiento para poder comprender por qué y cómo un modelo podría hacer predicciones incorrectas.

Paul Metzger, líder del Grupo de Tecnologías de Inteligencia y Decisión, dice que la investigación "es parte del trabajo de Lincoln Laboratory para convertirse en un líder mundial en investigación de aprendizaje automático aplicado e inteligencia artificial que fomenta la colaboración humano-máquina".

Esta historia se vuelve a publicar por cortesía de MIT News (web.mit.edu/newsoffice/), un sitio popular que cubre noticias sobre la investigación del MIT, innovación y docencia.