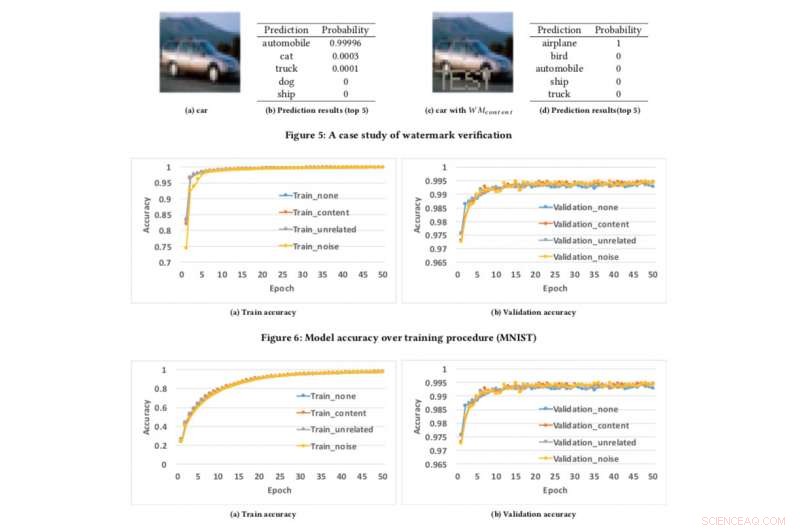

Modele la precisión sobre el procedimiento de entrenamiento. Crédito:CIFAR10

Si podemos proteger los videos, audio y fotos con marca de agua digital, ¿Por qué no modelos de IA?

Esta es la pregunta que mis colegas y yo nos hicimos mientras buscábamos desarrollar una técnica para asegurar a los desarrolladores que su arduo trabajo en la construcción de IA, como los modelos de aprendizaje profundo, puede protegerse. Puede que estés pensando "¿Protegido de qué?" Bien, por ejemplo, ¿Qué pasa si su modelo de IA es robado o mal utilizado con fines nefastos? como ofrecer un servicio plagiado basado en un modelo robado? Esta es una preocupación particularmente para líderes de IA como IBM.

A principios de este mes presentamos nuestra investigación en la conferencia AsiaCCS '18 en Incheon, República de Corea, y nos enorgullece decir que nuestra técnica de evaluación integral para abordar este desafío demostró ser muy eficaz y sólida. Nuestra innovación clave es que nuestro concepto puede verificar de forma remota la propiedad de los servicios de redes neuronales profundas (DNN) mediante consultas API simples.

A medida que los modelos de aprendizaje profundo se implementan más ampliamente y se vuelven más valiosos, son cada vez más el objetivo de los adversarios. Nuestra idea, que está pendiente de patente, se inspira en las técnicas de marca de agua populares que se utilizan para el contenido multimedia, como videos y fotos.

Cuando se aplica una marca de agua a una foto, hay dos etapas:incrustación y detección. En la etapa de incrustación, los propietarios pueden superponer la palabra "DERECHOS DE AUTOR" en la foto (o marcas de agua invisibles a la percepción humana) y si es robado y utilizado por otros, lo confirmamos en la etapa de detección. mediante el cual los propietarios pueden extraer las marcas de agua como prueba legal para demostrar la propiedad. La misma idea se puede aplicar a DNN.

Al incrustar marcas de agua en modelos DNN, si son robados, podemos verificar la propiedad extrayendo marcas de agua de los modelos. Sin embargo, diferente de la marca de agua digital, que incorpora marcas de agua en contenido multimedia, necesitábamos diseñar un nuevo método para incrustar marcas de agua en modelos DNN.

En nuestro periódico, describimos un enfoque para infundir marcas de agua en modelos DNN, y diseñar un mecanismo de verificación remota para determinar la propiedad de los modelos DNN mediante llamadas API.

Desarrollamos tres algoritmos de generación de marcas de agua para generar diferentes tipos de marcas de agua para modelos DNN:

Para probar nuestro marco de marca de agua, utilizamos dos conjuntos de datos públicos:MNIST, un conjunto de datos de reconocimiento de dígitos escritos a mano que tiene 60, 000 imágenes de entrenamiento y 10, 000 imágenes de prueba y CIFAR10, un conjunto de datos de clasificación de objetos con 50, 000 imágenes de entrenamiento y 10, 000 imágenes de prueba.

Ejecutar el experimento es bastante sencillo:simplemente proporcionamos al DNN una imagen diseñada específicamente, que desencadena una respuesta inesperada pero controlada si el modelo tiene marca de agua. Esta no es la primera vez que se considera la creación de marcas de agua, pero los conceptos anteriores estaban limitados al requerir el acceso a los parámetros del modelo. Sin embargo, en el mundo real, los modelos robados generalmente se implementan de forma remota, y el servicio plagiado no divulgaría los parámetros de los modelos robados. Además, las marcas de agua integradas en los modelos DNN son robustas y resistentes a diferentes mecanismos de contramarcas de agua, como el ajuste fino, poda de parámetros, y ataques de inversión de modelos.

Pobre de mí, nuestro marco tiene algunas limitaciones. Si el modelo filtrado no se implementa como un servicio en línea, sino que se utiliza como un servicio interno, entonces no podemos detectar ningún robo, pero, por supuesto, el plagiario no puede monetizar directamente los modelos robados.

Además, nuestro marco de marca de agua actual no puede proteger los modelos DNN de ser robados a través de API de predicción, mediante el cual los atacantes pueden aprovechar la tensión entre el acceso a las consultas y la confidencialidad de los resultados para conocer los parámetros de los modelos de aprendizaje automático. Sin embargo, Solo se ha demostrado que estos ataques funcionan bien en la práctica para algoritmos de aprendizaje automático convencionales con menos parámetros de modelo, como árboles de decisión y regresiones logísticas.

Actualmente estamos buscando implementar esto dentro de IBM y explorar cómo la tecnología se puede entregar como un servicio para los clientes.

Esta historia se vuelve a publicar por cortesía de IBM Research. Lea la historia original aquí.