Un detector de muones en forma de rueda es parte de una actualización del detector de partículas ATLAS en el CERN. Un nuevo estudio aplica "desdoblamiento, "o técnicas de corrección de errores utilizadas para detectores de partículas, a los problemas con el ruido en la computación cuántica. Crédito:Julien Marius Ordan / CERN

Tomando prestada una página de libros de texto de física y astronomía de alta energía, Un equipo de físicos e informáticos del Laboratorio Nacional Lawrence Berkeley (Berkeley Lab) del Departamento de Energía de EE. UU. ha adaptado y aplicado con éxito una técnica común de reducción de errores al campo de la computación cuántica.

En el mundo de las partículas subatómicas y los detectores de partículas gigantes, y galaxias distantes y telescopios gigantes, los científicos han aprendido a vivir, y trabajar, con incertidumbre. A menudo están tratando de desentrañar interacciones de partículas ultra raras a partir de una maraña masiva de interacciones de otras partículas y "ruido" de fondo que puede complicar su búsqueda. o tratando de filtrar los efectos de las distorsiones atmosféricas y el polvo interestelar para mejorar la resolución de las imágenes astronómicas.

También, problemas inherentes a los detectores, como con su capacidad para registrar todas las interacciones de las partículas o para medir exactamente las energías de las partículas, puede resultar en que los datos sean mal leídos por la electrónica a la que están conectados, por lo que los científicos deben diseñar filtros complejos, en forma de algoritmos informáticos, para reducir el margen de error y devolver los resultados más precisos.

Los problemas de ruido y defectos físicos, y la necesidad de algoritmos de corrección y mitigación de errores, que reducen la frecuencia y la gravedad de los errores, también son comunes en el campo incipiente de la computación cuántica, y un estudio publicado en la revista npj Información cuántica encontró que parece haber algunas soluciones comunes, también.

Ben Nachman, un físico de Berkeley Lab que participa en experimentos de física de partículas en el CERN como miembro del grupo ATLAS de Berkeley Lab, vio la conexión de la computación cuántica mientras trabajaba en un cálculo de física de partículas con Christian Bauer, un físico teórico de Berkeley Lab que es coautor del estudio. ATLAS es uno de los cuatro detectores de partículas gigantes del Gran Colisionador de Hadrones del CERN, el colisionador de partículas más grande y poderoso del mundo.

"En ATLAS, a menudo tenemos que 'desplegarnos, 'o corregir los efectos del detector, "dijo Nachman, el autor principal del estudio. "La gente ha estado desarrollando esta técnica durante años".

En experimentos en el LHC, las partículas llamadas protones chocan a una velocidad de aproximadamente mil millones de veces por segundo. Para hacer frente a este increíblemente ocupado, entorno "ruidoso" y problemas intrínsecos relacionados con la resolución energética y otros factores asociados con los detectores, Los físicos utilizan técnicas de corrección de errores de "despliegue" y otros filtros para reducir este revoltijo de partículas a lo más útil, datos precisos.

"Nos dimos cuenta de que las computadoras cuánticas actuales son muy ruidosas, también, "Nachman dijo, por lo que encontrar una manera de reducir este ruido y minimizar los errores (mitigación de errores) es clave para avanzar en la computación cuántica. "Un tipo de error está relacionado con las operaciones reales que realiza, y uno se relaciona con la lectura del estado de la computadora cuántica, ", señaló, ese primer tipo se conoce como error de puerta, y este último se denomina error de lectura.

El último estudio se centra en una técnica para reducir los errores de lectura, llamado "despliegue bayesiano iterativo" (IBU), que es familiar para la comunidad de físicos de alta energía. El estudio compara la efectividad de este enfoque con otras técnicas de corrección y mitigación de errores. El método IBU se basa en el teorema de Bayes, que proporciona una forma matemática de encontrar la probabilidad de que ocurra un evento cuando existen otras condiciones relacionadas con este evento que ya se conocen.

Nachman señaló que esta técnica se puede aplicar al análogo cuántico de las computadoras clásicas, conocidas como computadoras cuánticas basadas en puertas universales.

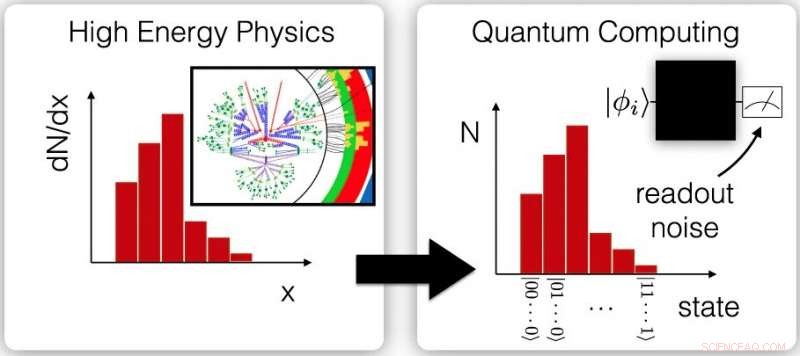

Estos gráficos muestran la conexión entre las mediciones físicas de alta energía clasificadas relacionadas con la dispersión de partículas, llamadas mediciones diferenciales de sección transversal (izquierda), y las mediciones repetidas de salidas de computadoras cuánticas (derecha). Estas similitudes brindan la oportunidad de aplicar técnicas de mitigación de errores similares a los datos de ambos campos. Crédito:Berkeley Lab; npj Quantum Inf 6, 84 (2020), DOE:10.1038 / s41534-020-00309-7

En computación cuántica, que se basa en bits cuánticos, o qubits, para llevar información, el estado frágil conocido como superposición cuántica es difícil de mantener y puede deteriorarse con el tiempo, hacer que un qubit muestre un cero en lugar de uno; este es un ejemplo común de un error de lectura.

La superposición establece que un bit cuántico puede representar un cero, uno, o ambas cantidades al mismo tiempo. Esto permite capacidades informáticas únicas que no son posibles en la informática convencional, que se basan en bits que representan un uno o un cero, pero no ambos a la vez. Otra fuente de error de lectura en las computadoras cuánticas es simplemente una medición defectuosa del estado de un qubit debido a la arquitectura de la computadora.

En el estudio, Los investigadores simularon una computadora cuántica para comparar el rendimiento de tres técnicas diferentes de corrección de errores (o mitigación de errores o despliegue). Descubrieron que el método IBU es más robusto en un entorno muy ruidoso, entorno propenso a errores, y superó ligeramente a los otros dos en presencia de patrones de ruido más comunes. Su rendimiento se comparó con un método de corrección de errores llamado Ignis que es parte de una colección de herramientas de desarrollo de software de computación cuántica de código abierto desarrolladas para las computadoras cuánticas de IBM. y una forma muy básica de desplegamiento conocida como método de inversión de matriz.

Los investigadores utilizaron el entorno de computación cuántica simulada para producir más de 1, 000 pseudo-experimentos, y encontraron que los resultados del método IBU eran los más cercanos a las predicciones. Los modelos de ruido utilizados para este análisis se midieron en una computadora cuántica de 20 qubits llamada IBM Q Johannesburg.

"Tomamos una técnica muy común de la física de altas energías, y lo aplicó a la computación cuántica, y funcionó muy bien, como debería, ", Dijo Nachman. Hubo una curva de aprendizaje pronunciada." Tuve que aprender todo tipo de cosas sobre la computación cuántica para estar seguro de que sabía cómo traducir esto e implementarlo en una computadora cuántica ".

Dijo que también fue muy afortunado de encontrar colaboradores para el estudio con experiencia en computación cuántica en Berkeley Lab. incluido Bert de Jong, quien dirige un equipo de algoritmos cuánticos de la Oficina de Investigación en Computación Científica Avanzada del DOE y un proyecto de Investigación Acelerada para Computación Cuántica en la División de Investigación Computacional de Berkeley Lab.

"Es emocionante ver cómo la plétora de conocimientos que la comunidad de la física de alta energía ha desarrollado para aprovechar al máximo los experimentos ruidosos se puede utilizar para sacar más provecho de las ruidosas computadoras cuánticas". ", dijo de Jong.

Las computadoras cuánticas simuladas y reales utilizadas en el estudio variaron de cinco qubits a 20 qubits, y la técnica debe ser escalable a sistemas más grandes, Dijo Nachman. Pero las técnicas de corrección y mitigación de errores que los investigadores probaron requerirán más recursos informáticos a medida que aumente el tamaño de las computadoras cuánticas. por lo que Nachman dijo que el equipo está enfocado en cómo hacer que los métodos sean más manejables para computadoras cuánticas con matrices de qubit más grandes.

Najman, Bauer, y de Jong también participaron en un estudio anterior que propone una forma de reducir los errores de puerta, que es la otra fuente importante de errores de computación cuántica. Creen que la corrección de errores y la mitigación de errores en la computación cuántica pueden, en última instancia, requerir un enfoque de combinación y combinación, utilizando una combinación de varias técnicas.

"Es un momento emocionante, "Nachman dijo, dado que el campo de la computación cuántica es todavía joven y hay mucho espacio para la innovación. "La gente al menos ha captado el mensaje sobre este tipo de enfoques, y todavía hay espacio para el progreso ". Señaló que la computación cuántica proporcionó un" impulso para pensar en los problemas de una manera nueva, "agregando, "Ha abierto un nuevo potencial científico".