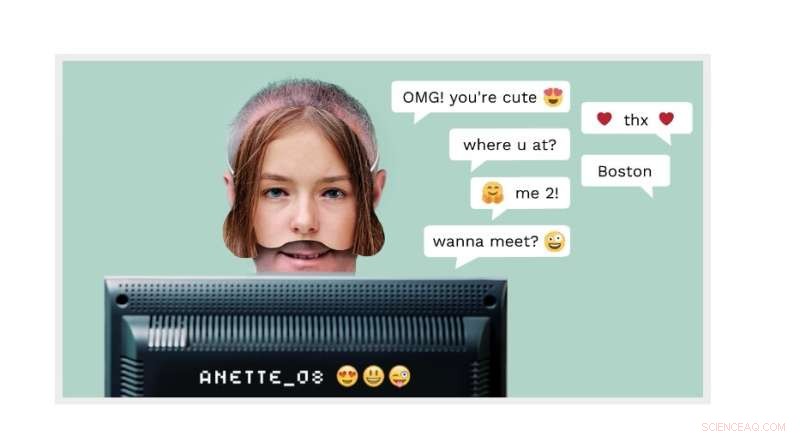

Acicalamiento cibernético:un hombre adulto puede pretender ser un niño de 14 años en línea. Ahora, la tecnología de detección de NTNU en uso en un spin-off comercial llamado AiBA puede detectar al perpetrador. Crédito:página de inicio de AiBA

Millones de niños inician sesión en salas de chat todos los días para hablar con otros niños. Uno de estos "niños" bien podría ser un hombre que finge ser una niña de 12 años con intenciones mucho más siniestras que tener una charla sobre los episodios de "My Little Pony".

El inventor y profesor de NTNU Patrick Bours en AiBA está trabajando para prevenir este tipo de comportamiento depredador. AiBA, un moderador digital de IA que Bours ayudó a fundar, puede ofrecer una herramienta basada en biometría de comportamiento y algoritmos que detectan a los abusadores sexuales en chats en línea con niños.

Y ahora, como informó recientemente Dagens Næringsliv, un periódico financiero nacional, la empresa ha recaudado un capital de NOK 7,5. millones, con inversores como Firda y Wiski Capital, dos empresas con sede en Noruega.

En sus esfuerzos más recientes, la compañía está trabajando con 50 millones de líneas de chat para desarrollar una herramienta que encuentre conversaciones de alto riesgo donde los abusadores intentan entrar en contacto con niños. El objetivo es identificar características distintivas en lo que los abusadores dejan en las plataformas de juegos y en las redes sociales.

"Nos dirigimos a los principales productores de juegos y esperamos tener unos cientos de juegos en la plataforma", dijo Hege Tokerud, cofundador y gerente general, a Dagens Næringsliv.

La preparación cibernética es un problema creciente

El acicalamiento cibernético es cuando los adultos se hacen amigos de los niños en línea, a menudo usando un perfil falso.

Sin embargo, "algunos depredadores sexuales simplemente salen y preguntan si el niño está interesado en conversar con una persona mayor, por lo que no hay necesidad de una identidad falsa", dijo Bours.

El propósito del perpetrador es a menudo atraer a los niños a un canal privado para que los niños puedan enviar fotos de ellos mismos, con y sin ropa, y tal vez eventualmente hacer arreglos para encontrarse con el joven.

A los perpetradores no les importa tanto enviar fotos de ellos mismos, dijo Bours. "El exhibicionismo es solo una pequeña parte de su motivación", dijo. "Obtener imágenes es mucho más interesante para ellos, y no solo imágenes fijas, sino imágenes en vivo a través de una cámara web".

"Supervisar todas estas conversaciones para evitar que ocurran abusos es imposible para los moderadores que monitorean el sistema manualmente. Lo que se necesita es una automatización que notifique a los moderadores sobre la conversación en curso", dice Bours.

AiBA ha desarrollado un sistema que utiliza varios algoritmos que ofrece a las grandes empresas de chat una herramienta que puede discernir si los adultos o los niños están chateando. Aquí es donde entra en juego la biometría del comportamiento.

Un hombre adulto puede hacerse pasar por un niño de 14 años en línea. Pero la forma en que escribe, como su ritmo de escritura o su elección de palabras, puede revelar que es un hombre adulto.

Clave de aprendizaje automático

La herramienta AiBA utiliza métodos de aprendizaje automático para analizar todos los chats y evaluar el riesgo en función de ciertos criterios. El nivel de riesgo puede subir y bajar un poco durante la conversación a medida que el sistema evalúa cada mensaje. El símbolo de advertencia rojo ilumina el chat si el nivel de riesgo es demasiado alto, lo que notifica al moderador, quien puede ver la conversación y evaluarla más a fondo.

De esta manera, los algoritmos pueden detectar conversaciones que deben verificarse mientras están en curso, en lugar de después, cuando el daño o el abuso ya podrían haber ocurrido. Por lo tanto, los algoritmos sirven como una señal de advertencia.

Frío y cínico

Bours analizó un montón de conversaciones de chat de registros antiguos para desarrollar el algoritmo.

"Al analizar estas conversaciones, aprendemos cómo estos hombres 'preparan' a los destinatarios con cumplidos, obsequios y otros halagos, para que revelen más y más. Es frío, cínico y cuidadosamente planeado", dice. "Revisar los chats también es parte del proceso de aprendizaje, de modo que podamos mejorar la IA y hacer que reaccione mejor en el futuro".

“El peligro de que este tipo de contacto termine en una agresión es alto, especialmente si el abusador envía al destinatario a otras plataformas con video, por ejemplo. En una situación en vivo, el algoritmo marcaría este chat como uno que necesita ser monitoreado. ."

Análisis en tiempo real

"El objetivo es exponer a un abusador lo más rápido posible", dice Bours.

"Si esperamos a que termine toda la conversación y los chaters ya han llegado a acuerdos, podría ser demasiado tarde. El monitor también puede decirle al niño en el chat que está hablando con un adulto y no con otro niño".

AiBA ha estado colaborando con empresas de juegos para instalar el algoritmo y está trabajando con una plataforma danesa de juegos y chat llamada MoviestarPlanet, que está dirigida a niños y tiene 100 millones de jugadores.

Al desarrollar los algoritmos, el investigador descubrió que los usuarios escriben de manera diferente en diferentes plataformas, como Snapchat y TikTok.

"Tenemos que tener en cuenta estas distinciones cuando entrenamos el algoritmo. Lo mismo ocurre con el lenguaje. El servicio debe desarrollarse para todos los tipos de lenguaje", dice Bours.

Consultar patrones de chat

Más recientemente, Bours y sus colegas han estado analizando patrones de chat para ver qué patrones se desvían de lo que se consideraría normal.

"Hemos analizado los patrones de chat, en lugar de los mensajes de texto, de 2,5 millones de chats, y hemos podido encontrar múltiples casos de manipulación que de otro modo no se habrían detectado", dijo Bours.

"Esta investigación inicial analizó los datos en retrospectiva, pero actualmente estamos investigando cómo podemos usar esto en un sistema que sigue dichos patrones de chat directamente y puede tomar decisiones inmediatas para informar a un usuario a un moderador", dijo. Microsoft busca detectar depredadores sexuales en chats de videojuegos