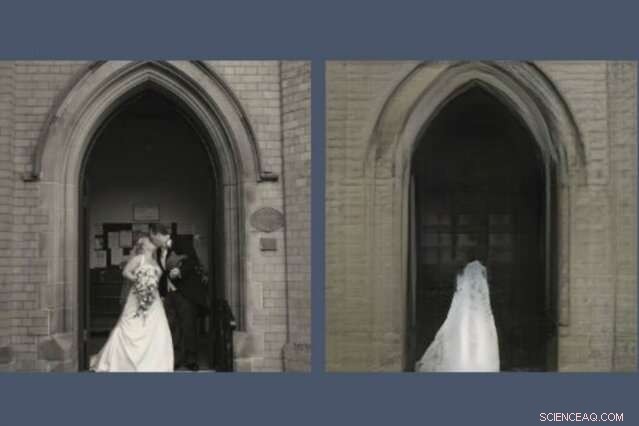

Una nueva herramienta revela lo que los modelos de IA dejan fuera al recrear una escena. Aquí, una GAN, o red generativa de adversarios, ha eliminado a la pareja de recién casados de su reconstrucción (derecha) de la foto que se le pidió que dibujara (izquierda). Crédito:Instituto de Tecnología de Massachusetts

Cualquiera que haya pasado tiempo en las redes sociales probablemente haya notado que las GAN, o redes generativas de confrontación, se han vuelto notablemente buenos dibujando caras. Pueden predecir cómo te verás cuando seas mayor y cómo te verás como una celebridad. Pero pídele a un GAN que dibuje escenas del mundo más amplio y las cosas se ponen raras.

Una nueva demostración del MIT-IBM Watson AI Lab revela lo que un modelo entrenado en escenas de iglesias y monumentos decide dejar de lado cuando dibuja su propia versión de, decir, el Panteón de París, o la Piazza di Spagna en Roma. El estudio más grande, Viendo lo que un GAN no puede generar, fue presentado en la Conferencia Internacional sobre Visión por Computador la semana pasada.

"Los investigadores suelen centrarse en caracterizar y mejorar lo que puede hacer un sistema de aprendizaje automático:a qué presta atención, y cómo los insumos particulares conducen a resultados particulares, "dice David Bau, un estudiante de posgrado en el Departamento de Ingeniería Eléctrica y Ciencias de la Computación del MIT y el Laboratorio de Ciencias de la Computación y Ciencias Artificiales (CSAIL). "Con este trabajo, esperamos que los investigadores presten tanta atención a la caracterización de los datos que estos sistemas ignoran ".

En un GAN, un par de redes neuronales trabajan juntas para crear imágenes hiperrealistas siguiendo el patrón de los ejemplos que se les han dado. Bau se interesó en las GAN como una forma de mirar dentro de las redes neuronales de caja negra para comprender el razonamiento detrás de sus decisiones. Una herramienta anterior desarrollada con su asesor, Profesor del MIT Antonio Torralba, y el investigador de IBM Hendrik Strobelt, hizo posible identificar los grupos de neuronas artificiales responsables de organizar la imagen en categorías del mundo real como puertas, árboles, y nubes. Una herramienta relacionada, GANPaint, permite que los artistas aficionados agreguen y eliminen esas características de sus propias fotografías.

Un día, mientras ayuda a un artista a utilizar GANPaint, Bau dio con un problema. "Como siempre, estábamos persiguiendo los números, tratando de optimizar la pérdida de reconstrucción numérica para reconstruir la foto, ", dice." Pero mi asesor siempre nos ha animado a mirar más allá de los números y escudriñar las imágenes reales. Cuando miramos el fenómeno saltó de inmediato:la gente estaba siendo abandonada de forma selectiva ".

Así como las GAN y otras redes neuronales encuentran patrones en montones de datos, ignoran patrones, también. Bau y sus colegas entrenaron diferentes tipos de GAN en escenas interiores y exteriores. Pero no importa dónde se tomaron las fotos, las GAN omitieron sistemáticamente detalles importantes como las personas, carros, señales, fuentes y muebles, incluso cuando esos objetos aparecían de forma destacada en la imagen. En una reconstrucción de GAN, una pareja de recién casados que se besan en las escaleras de una iglesia se apagan como un fantasma, dejando una espeluznante textura de vestido de novia en la puerta de la catedral.

"Cuando los GAN encuentran objetos que no pueden generar, parecen imaginarse cómo sería la escena sin ellos, ", dice Strobelt." A veces las personas se convierten en arbustos o desaparecen por completo en el edificio detrás de ellos ".

Los investigadores sospechan que la culpa puede ser la pereza de las máquinas; aunque un GAN está capacitado para crear imágenes convincentes, Puede que aprenda que es más fácil concentrarse en edificios y paisajes y omitir personas y automóviles más difíciles de representar. Los investigadores saben desde hace mucho tiempo que las GAN tienden a pasar por alto algunos detalles estadísticamente significativos. Pero este puede ser el primer estudio que muestra que las GAN de última generación pueden omitir sistemáticamente clases enteras de objetos dentro de una imagen.

Una IA que deja caer algunos objetos de sus representaciones puede lograr sus objetivos numéricos sin tener en cuenta los detalles más importantes para nosotros, los humanos. dice Bau. A medida que los ingenieros recurren a las GAN para generar imágenes sintéticas para entrenar sistemas automatizados como automóviles autónomos, existe el peligro de que la gente, señales, y otra información crítica podría descartarse sin que los humanos se dieran cuenta. Muestra por qué el rendimiento del modelo no debe medirse solo por la precisión, dice Bau. "Necesitamos entender qué están haciendo y qué no están haciendo las redes para asegurarnos de que están tomando las decisiones que queremos que tomen".

Esta historia se vuelve a publicar por cortesía de MIT News (web.mit.edu/newsoffice/), un sitio popular que cubre noticias sobre la investigación del MIT, innovación y docencia.