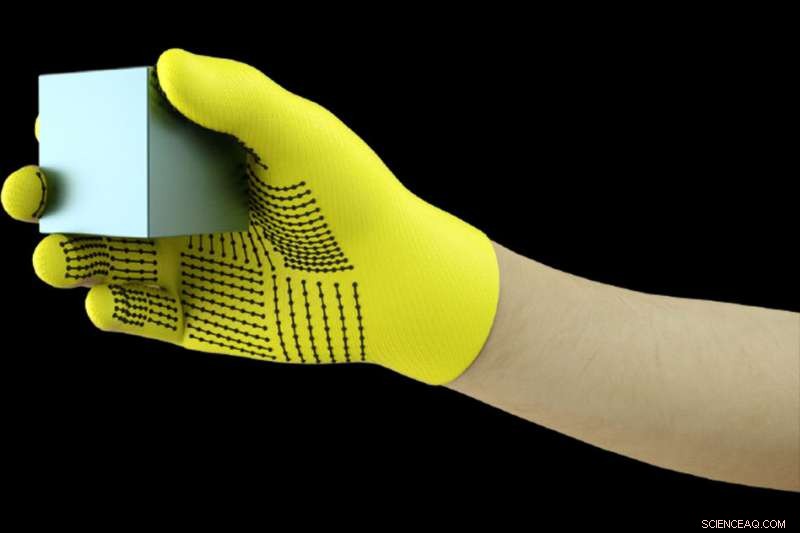

Los investigadores del MIT han desarrollado un Guante con sensor que captura las señales de presión cuando los humanos interactúan con los objetos. El guante se puede utilizar para crear conjuntos de datos táctiles de alta resolución que los robots pueden aprovechar para identificar mejor, pesar, y manipular objetos. Crédito:Instituto de Tecnología de Massachusetts

Usar un guante con sensor mientras maneja una variedad de objetos, Los investigadores del MIT han compilado un conjunto de datos masivo que permite que un sistema de inteligencia artificial reconozca objetos solo a través del tacto. La información podría aprovecharse para ayudar a los robots a identificar y manipular objetos, y puede ayudar en el diseño de prótesis.

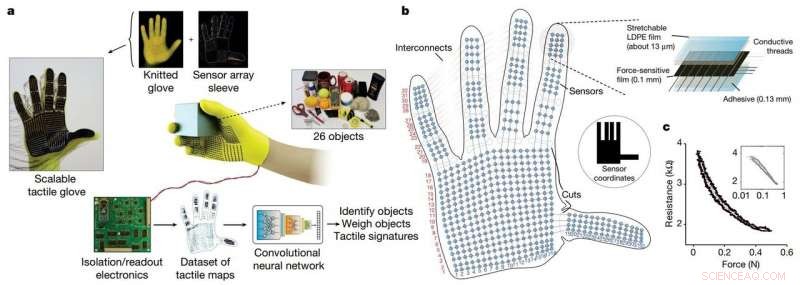

Los investigadores desarrollaron un guante tejido de bajo costo, llamado "guante táctil escalable" (STAG), equipado con alrededor de 550 pequeños sensores en casi toda la mano. Cada sensor captura señales de presión cuando los humanos interactúan con los objetos de varias formas. Una red neuronal procesa las señales para "aprender" un conjunto de datos de patrones de señales de presión relacionados con objetos específicos. Luego, el sistema usa ese conjunto de datos para clasificar los objetos y predecir sus pesos sintiéndose solo, sin necesidad de información visual.

En un artículo publicado en Naturaleza , los investigadores describen un conjunto de datos que compilaron usando STAG para 26 objetos comunes, incluida una lata de refresco, tijeras, Pelota de tenis, cuchara, lápiz, y taza. Usando el conjunto de datos, el sistema predijo las identidades de los objetos con una precisión de hasta el 76 por ciento. El sistema también puede predecir el peso correcto de la mayoría de los objetos dentro de unos 60 gramos.

Los guantes basados en sensores similares que se utilizan hoy en día cuestan miles de dólares y, a menudo, contienen solo alrededor de 50 sensores que capturan menos información. Aunque STAG produce datos de muy alta resolución, está hecho de materiales disponibles comercialmente por un total de alrededor de $ 10.

El sistema de detección táctil podría usarse en combinación con la visión por computadora tradicional y los conjuntos de datos basados en imágenes para brindar a los robots una comprensión más humana de la interacción con los objetos.

"Los seres humanos pueden identificar y manejar bien los objetos porque tenemos retroalimentación táctil. Cuando tocamos objetos, palpamos a nuestro alrededor y nos damos cuenta de lo que son. Los robots no tienen una retroalimentación tan rica "dice Subramanian Sundaram Ph.D. '18, ex estudiante de posgrado en el Laboratorio de Ciencias de la Computación e Inteligencia Artificial (CSAIL). "Siempre hemos querido que los robots hagan lo que los humanos pueden hacer, como lavar los platos u otras tareas del hogar. Si desea que los robots hagan estas cosas, deben ser capaces de manipular objetos realmente bien ".

Los investigadores también utilizaron el conjunto de datos para medir la cooperación entre las regiones de la mano durante las interacciones de los objetos. Por ejemplo, cuando alguien usa la articulación media de su dedo índice, rara vez usan el pulgar. Pero las puntas de los dedos índice y medio siempre corresponden al uso del pulgar. "Mostramos de forma cuantificable, por primera vez, ese, si estoy usando una parte de mi mano, qué tan probable es que use otra parte de mi mano, " él dice.

Los fabricantes de prótesis pueden potencialmente utilizar la información para, decir, Elija lugares óptimos para colocar sensores de presión y ayude a personalizar las prótesis para las tareas y objetos con los que las personas interactúan habitualmente.

Junto a Sundaram en el periódico están:los postdoctorados de CSAIL Petr Kellnhofer y Jun-Yan Zhu; Yunzhu Li, estudiante de posgrado de CSAIL; Antonio Torralba, profesor de EECS y director del MIT-IBM Watson AI Lab; y Wojciech Matusik, profesor asociado de ingeniería eléctrica e informática y director del grupo de Fabricación Computacional.

El STAG como plataforma para aprender del entendimiento humano. Crédito: Naturaleza (2019). DOI:10.1038 / s41586-019-1234-z

STAG está laminado con un polímero conductor de electricidad que cambia la resistencia a la presión aplicada. Los investigadores cosieron hilos conductores a través de agujeros en la película de polímero conductor, desde las yemas de los dedos hasta la base de la palma. Los hilos se superponen de una manera que los convierte en sensores de presión. Cuando alguien que lleva el guante siente ascensores, sostiene, y deja caer un objeto, los sensores registran la presión en cada punto.

Los hilos se conectan desde el guante a un circuito externo que traduce los datos de presión en "mapas táctiles, "que son esencialmente videos breves de puntos que crecen y se encogen en el gráfico de una mano. Los puntos representan la ubicación de los puntos de presión, y su tamaño representa la fuerza:cuanto más grande es el punto, cuanto mayor sea la presión.

De esos mapas, los investigadores compilaron un conjunto de datos de aproximadamente 135, 000 fotogramas de vídeo de interacciones con 26 objetos. Esos marcos pueden ser utilizados por una red neuronal para predecir la identidad y el peso de los objetos, y proporcionar información sobre la comprensión humana.

Para identificar objetos, los investigadores diseñaron una red neuronal convolucional (CNN), que se suele utilizar para clasificar imágenes, para asociar patrones de presión específicos con objetos específicos. Pero el truco consistía en elegir marcos de diferentes tipos de agarres para obtener una imagen completa del objeto.

La idea era imitar la forma en que los humanos pueden sostener un objeto de diferentes maneras para reconocerlo. sin usar la vista. Similar, La CNN de los investigadores elige hasta ocho fotogramas semialeatorios del video que representan las capturas más diferentes, por ejemplo, sosteniendo una taza del fondo, cima, y manejar.

Pero la CNN no puede simplemente elegir fotogramas aleatorios de los miles de cada video, o probablemente no elija agarres distintos. En lugar de, agrupa marcos similares juntos, resultando en grupos distintos que corresponden a prensas únicas. Luego, extrae un fotograma de cada uno de esos grupos, asegurándose de que tenga una muestra representativa. Luego, la CNN usa los patrones de contacto que aprendió en el entrenamiento para predecir una clasificación de objetos a partir de los marcos elegidos.

"Queremos maximizar la variación entre las tramas para ofrecer la mejor entrada posible a nuestra red, "Dice Kellnhofer." Todos los fotogramas dentro de un solo grupo deben tener una firma similar que represente las formas similares de agarrar el objeto. El muestreo de varios grupos simula a un ser humano que intenta de forma interactiva encontrar diferentes agarres mientras explora un objeto ".

Para la estimación de peso, los investigadores construyeron un conjunto de datos separado de alrededor de 11, 600 fotogramas de mapas táctiles de objetos que se recogen con el dedo y el pulgar, retenida, y se dejó caer. Notablemente, la CNN no se entrenó en ningún marco en el que se probó, lo que significa que no podía aprender a asociar el peso con un objeto. En prueba, se ingresó un solo cuadro en la CNN. Esencialmente, la CNN detecta la presión alrededor de la mano causada por el peso del objeto, e ignora la presión causada por otros factores, como el posicionamiento de las manos para evitar que el objeto se resbale. Luego calcula el peso en función de las presiones adecuadas.

El sistema podría combinarse con los sensores que ya están en las articulaciones del robot que miden el par y la fuerza para ayudarlos a predecir mejor el peso del objeto. "Las articulaciones son importantes para predecir el peso, pero también hay componentes importantes del peso de las yemas de los dedos y la palma que capturamos, "Dice Sundaram.

Esta historia se vuelve a publicar por cortesía de MIT News (web.mit.edu/newsoffice/), un sitio popular que cubre noticias sobre la investigación del MIT, innovación y docencia.