Cynthia Rudin. Crédito:Universidad de Duke

A medida que las palabras de moda "aprendizaje automático" siguen ganando popularidad, más industrias están recurriendo a algoritmos informáticos para responder preguntas importantes, incluyendo campos de alto riesgo como la salud, finanzas y justicia penal. Si bien esta tendencia puede conducir a importantes mejoras en estos ámbitos, también puede dar lugar a problemas importantes cuando el algoritmo de aprendizaje automático es una llamada "caja negra".

Una caja negra es un programa de aprendizaje automático que no explica cómo llega a sus conclusiones, ya sea porque es demasiado complicado de entender para un ser humano o porque su funcionamiento interno es propietario. En respuesta a las preocupaciones de que este tipo de modelos pueden incluir mecanismos internos injustos, como el racismo, otra tendencia creciente es crear modelos adicionales para "explicar" estas cajas negras.

En un nuevo editorial publicado en Inteligencia de la máquina de la naturaleza , Cynthia Rudin, profesor asociado de informática, ingeniería Eléctrica y Computación, matemáticas, y ciencia estadística en la Universidad de Duke, sostiene que los modelos de caja negra deben abandonarse para tomar decisiones de alto riesgo. Incluso cuando se crean los llamados modelos de explicación, ella dice, los responsables de la toma de decisiones deberían optar por modelos interpretables, que son completamente transparentes y fáciles de entender por sus usuarios.

Los modelos explicables están equivocados

Los modelos de aprendizaje automático "explicables" se crean en un intento de comprender lo que sucede dentro de una caja negra. Si puede producir los mismos resultados, la gente asume que es una representación precisa.

Pero no lo es.

Los algoritmos explicables proporcionan explicaciones que son inexactas por definición; de lo contrario, el complejo funcionamiento interno de la caja negra sería innecesario. Si bien un modelo de explicación puede producir resultados similares o incluso exactos al algoritmo original de caja negra, no hay forma de saber si está usando los mismos parámetros o no.

"Si una décima parte de las explicaciones son incorrectas, no puedes confiar en las explicaciones, y por lo tanto no puedes confiar en la caja negra original, "dice Rudin." Si no podemos saber con certeza si nuestra explicación es correcta, no podemos saber si confiar en la explicación o en el modelo original ".

Más no es igual a mejor

La gente suele asumir que solo porque un algoritmo de aprendizaje automático es complicado, que es más preciso que uno simple. Pero esta creencia es infundada.

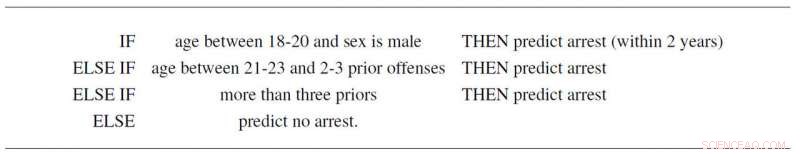

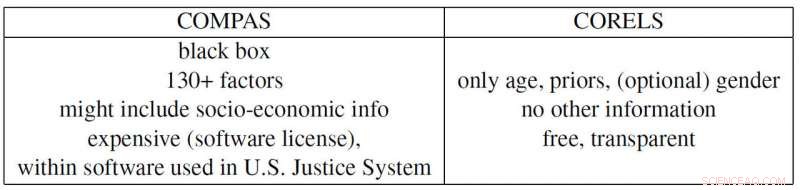

Por ejemplo, Rudin y colaboradores Elaine Angelino, Margo Seltzer, Nicholas Larus-Stone y Daniel Alabi han creado un modelo interpretable simple para la reincidencia criminal basado solo en la edad, sexo y antecedentes. No solo sigue tres reglas simples que cualquiera puede entender, predice la probabilidad de arrestos futuros tan bien como el controvertido programa "COMPAS", que se emplea ampliamente en el sistema de justicia de EE. UU. Y además de ser una caja negra que muchos sospechan que emplea prejuicios racistas, COMPAS utiliza más de 130 piezas de información para hacer sus predicciones, que es un problema importante por sí solo.

"Si las personas que ingresan estos datos cometen un error tipográfico solo el uno por ciento de las veces, entonces, en promedio, más de 1 de cada 2 encuestas tendrá al menos un error, "dice Rudin." Además, un modelo de caja negra demasiado complicado puede tener fallas sin que nadie se dé cuenta, porque es difícil de solucionar ".

El ejemplo de Propublica

ProPublica acusó recientemente al algoritmo de caja negra de reincidencia de COMPAS de tener un sesgo racial porque creó un modelo explicable basado en la raza que reproduce los resultados de COMPAS. Pero debido a que las presiones sociales han creado un sistema de justicia penal en el que los antecedentes penales y la edad se correlacionan con la raza en todos los conjuntos de datos, la caja negra de COMPAS real podría depender sólo de las dos primeras variables. Pero entonces de nuevo, también podría estar usando la raza como un factor, tal como afirma ProPublica. El problema es que es imposible saberlo porque COMPAS es una caja negra patentada (cara) en la que nadie más que sus propietarios puede mirar.

Rudin también señala varios otros ejemplos problemáticos contemporáneos. La caja negra patentada BreezoMeter les dijo a los usuarios en California que la calidad del aire estaba perfectamente bien cuando la calidad del aire era peligrosamente mala según muchos otros modelos. Un modelo de aprendizaje automático diseñado para leer rayos X estaba captando la palabra "portátil" en una imagen de rayos X, que representa el tipo de equipo de rayos X en lugar del contenido médico de la imagen, y así reportar malas conclusiones.

"Existe un conflicto de responsabilidad en el uso de modelos de caja negra para decisiones de alto riesgo. Las empresas que se benefician de estos modelos no son necesariamente responsables de la calidad de las predicciones individuales, "dice Rudin." Un preso que cumple una condena excesivamente larga debido a un error ingresado en una puntuación de riesgo demasiado complicada podría sufrir durante años, mientras que la empresa que construyó este modelo se beneficia de su complejidad y propiedad. En ese sentido, los diseñadores del modelo no están incentivados a ser cuidadosos en su diseño, rendimiento y facilidad de uso. Estos son algunos de los mismos tipos de problemas que afectan a las agencias de calificación crediticia que fijaron el precio de las hipotecas en 2008 ".

"Espero que las personas se den cuenta de los riesgos de los modelos explicables y que en realidad no necesiten cajas negras en absoluto. Pueden usar modelos que sean completamente interpretables, ", dice Rudin." Me gustaría ver un sistema en el que no se utilice un algoritmo de caja negra para una decisión de alto riesgo, a menos que no haya un modelo interpretable igualmente preciso. He trabajado en muchas aplicaciones diferentes:atención médica, energía, riesgo crediticio, reincidencia criminal, visión por computadora, y nunca he encontrado una aplicación en la que realmente se necesite una caja negra ".