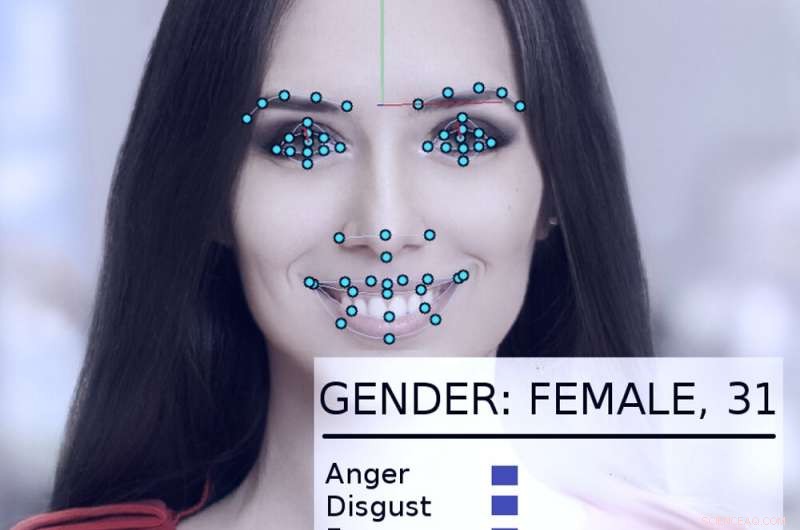

Un sistema de análisis y seguimiento facial examina el rostro de una mujer. Crédito:Abyssus / Wikimedia Commons, CC BY-SA

Los sistemas de inteligencia artificial pueden, si se utilizan correctamente, ayudar a que el gobierno sea más eficaz y receptivo, mejorar la vida de los ciudadanos. Usado incorrectamente, sin embargo, las visiones distópicas de "1984" de George Orwell se vuelven más realistas.

Por su cuenta e instados por una nueva orden ejecutiva presidencial, gobiernos de EE. UU., incluyendo agencias estatales y federales, están explorando formas de utilizar tecnologías de IA.

Como investigador de IA durante más de 40 años, que ha sido consultor o participante en muchos proyectos gubernamentales, Creo que vale la pena señalar que a veces lo han hecho bien y otras no tan bien. Los daños y beneficios potenciales son significativos.

Un éxito temprano

En 2015, el Departamento de Seguridad Nacional de EE. UU. desarrolló un sistema de inteligencia artificial llamado "Emma, "un chatbot que puede responder a las preguntas que se le plantean en inglés normal, sin necesidad de saber lo que "su" sitio web introductorio llama "lenguaje del gobierno":todos los términos y acrónimos oficiales utilizados en los documentos de la agencia.

A finales de 2016, DHS informó que Emma ya estaba ayudando a responder casi medio millón de preguntas por mes, permitir que el DHS maneje muchas más consultas de las que tenía anteriormente, y permitir que los empleados humanos dediquen más tiempo a ayudar a las personas con consultas más complicadas que están más allá de las capacidades de Emma. Este tipo de inteligencia artificial que automatiza las conversaciones ahora ha sido utilizada por otras agencias gubernamentales, en ciudades y países de todo el mundo.

Agua de pedernal

Un ejemplo más complicado de cómo los gobiernos podrían aplicar adecuadamente la IA se puede ver en Flint, Michigan. Mientras los gobiernos locales y estatales luchaban por combatir la contaminación por plomo en el agua potable de la ciudad, quedó claro que tendrían que reemplazar las tuberías de agua de plomo restantes de la ciudad. Sin embargo, los registros de la ciudad estaban incompletos, e iba a ser extremadamente caro excavar todas las tuberías de la ciudad para ver si eran de plomo o de cobre.

En lugar de, científicos informáticos y empleados del gobierno colaboraron para analizar una amplia gama de datos sobre cada uno de los 55, 000 propiedades en la ciudad, incluyendo la antigüedad de la casa, para calcular la probabilidad de que fuera servido por tuberías de plomo. Antes de que se utilizara el sistema, El 80% de las tuberías excavadas tuvieron que ser reemplazadas. lo que significó el 20% del tiempo, se desperdiciaba dinero y esfuerzo en tuberías que no necesitaban ser reemplazadas.

El sistema de inteligencia artificial ayudó a los ingenieros a concentrarse en propiedades de alto riesgo, identificar un conjunto de propiedades que probablemente necesiten reemplazos de tuberías. Cuando los inspectores de la ciudad visitaron para verificar la situación, el algoritmo acertó el 70% del tiempo. Eso prometía ahorrar enormes cantidades de dinero y acelerar el proceso de reemplazo de tuberías.

Sin embargo, la política local se interpuso en el camino. Muchos miembros del público no entendieron por qué el sistema estaba identificando las casas que lo hizo, y objetado, diciendo que el método de la IA ignoraba injustamente sus hogares. Después de que los funcionarios de la ciudad dejaron de usar el algoritmo, sólo el 15% de las tuberías excavadas eran de plomo. Eso hizo que el proyecto de reemplazo fuera más lento y costoso.

Ejemplos angustiosos

El problema en Flint era que la gente no entendía que la tecnología de IA se estaba utilizando bien, y que la gente verificaba sus hallazgos con inspecciones independientes. En parte, esto se debía a que no confiaban en la IA y, en algunos casos, hay una buena razón para ello.

En 2017, Yo formaba parte de un grupo de más de cuatro docenas de investigadores de inteligencia artificial que enviaron una carta al secretario en funciones del Departamento de Seguridad Nacional de EE. UU. Expresamos nuestra preocupación por una propuesta para utilizar sistemas automatizados para determinar si una persona que busca asilo en los EE. UU. Se convertiría en un "miembro de la sociedad que contribuya positivamente" o si es más probable que sea una amenaza terrorista.

"Simplemente pon, "nuestra carta decía, "Ningún método computacional puede proporcionar evaluaciones confiables u objetivas de los rasgos que [DHS] busca medir". Explicamos que el aprendizaje automático es susceptible a un problema llamado "desviación de datos, "en el que la capacidad del sistema para predecir una característica depende en parte de qué tan común es esa característica en los datos utilizados para entrenar el sistema.

Entonces, en una base de datos de 300 millones de estadounidenses, si una de cada 100 personas lo es, decir, de ascendencia india, el sistema será bastante preciso para identificarlos. Pero si observamos una característica compartida por solo uno de cada millón de estadounidenses, realmente no hay suficientes datos para que el algoritmo haga un buen análisis.

Como explicaba la carta, "en la escala de la población estadounidense y las tasas de inmigración, los actos delictivos son relativamente raros, y los actos terroristas son extremadamente raros ". Es muy poco probable que el análisis algorítmico identifique a posibles terroristas. Afortunadamente, nuestros argumentos resultaron convincentes. En mayo de 2018, DHS anunció que no usaría un algoritmo de aprendizaje automático de esta manera.

Otros esfuerzos preocupantes

Se están cuestionando otros usos gubernamentales de la IA, también, como los intentos de "vigilancia predictiva, "fijar el monto de la fianza y las condenas penales y la contratación de trabajadores del gobierno. Se ha demostrado que todo esto es susceptible a problemas técnicos y limitaciones de datos que pueden sesgar sus decisiones basadas en la raza, género o antecedentes culturales.

Otras tecnologías de IA como el reconocimiento facial, la vigilancia automatizada y la recopilación masiva de datos están generando preocupaciones reales sobre la seguridad, intimidad, equidad y precisión en una sociedad democrática.

Como demuestra la orden ejecutiva de Trump, Existe un gran interés en aprovechar la IA en su máximo potencial positivo. Pero los importantes peligros del abuso, el uso indebido y el sesgo, ya sea intencional o no, tienen el potencial de actuar en contra de los mismos principios sobre los que se han construido las democracias internacionales.

A medida que crece el uso de tecnologías de IA, ya sea originalmente bien intencionado o deliberadamente autoritario, el potencial de abuso también aumenta. Sin una supervisión gubernamental actualmente existente en los EE. UU., la mejor manera de evitar estos abusos es enseñar al público sobre los usos apropiados de la IA mediante conversaciones entre científicos, ciudadanos y administradores públicos preocupados para ayudar a determinar cuándo y dónde es inapropiado implementar estas nuevas y poderosas herramientas.

Este artículo se ha vuelto a publicar de The Conversation con una licencia de Creative Commons. Lea el artículo original.