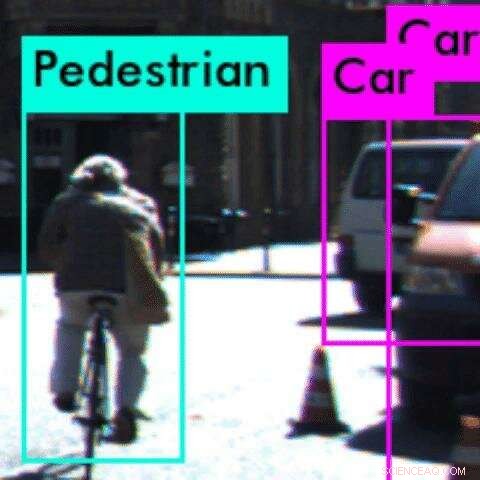

En este ejemplo, un algoritmo de percepción clasifica erróneamente al ciclista como peatón Crédito:Anand Balakrishnan

Es una gran pregunta para muchas personas en ciudades con mucho tráfico como Los Ángeles:¿Cuándo llegarán los autos autónomos? Pero luego de una serie de accidentes de alto perfil en los Estados Unidos, Los problemas de seguridad podrían detener el sueño autónomo.

En USC, Los investigadores han publicado un nuevo estudio que aborda un problema de larga data para los desarrolladores de vehículos autónomos:probar los algoritmos de percepción del sistema, que permiten que el coche "comprenda" lo que "ve".

Trabajando con investigadores de la Universidad Estatal de Arizona, El nuevo método matemático del equipo es capaz de identificar anomalías o errores en el sistema antes de que el automóvil salga a la carretera.

Los algoritmos de percepción se basan en redes neuronales convolucionales, impulsado por aprendizaje automático, un tipo de aprendizaje profundo. Estos algoritmos son muy difíciles de probar, ya que no entendemos completamente cómo hacen sus predicciones. Esto puede tener consecuencias devastadoras en sistemas críticos para la seguridad, como los vehículos autónomos.

"Hacer que los algoritmos de percepción sean robustos es uno de los principales desafíos para los sistemas autónomos, "dijo el autor principal del estudio, Anand Balakrishnan, un doctorado en ciencias de la computación de la USC estudiante.

"Con este método, los desarrolladores pueden reducir los errores en los algoritmos de percepción mucho más rápido y usar esta información para entrenar aún más el sistema. De la misma manera que los automóviles deben pasar por pruebas de choque para garantizar la seguridad, este método ofrece una prueba preventiva para detectar errores en sistemas autónomos ".

El papel, titulado Especificación y evaluación de métricas de calidad para sistemas de percepción basados en la visión, fue presentado en el Design, Conferencia sobre automatización y pruebas en Europa en Italia, 28 de marzo.

Aprendiendo sobre el mundo

Por lo general, los vehículos autónomos "aprenden" sobre el mundo a través de sistemas de aprendizaje automático, que se alimentan de enormes conjuntos de datos de imágenes de carreteras antes de que puedan identificar objetos por sí mismos.

Pero el sistema puede fallar. En el caso de un accidente fatal entre un automóvil autónomo y un peatón en Arizona en marzo pasado, el software clasificó al peatón como un "falso positivo" y decidió que no necesitaba detenerse.

"Pensamos, Claramente, hay algún problema con la forma en que se ha entrenado este algoritmo de percepción, "dijo el coautor del estudio, Jyo Deshmukh, profesor de informática de la USC y ex ingeniero de investigación y desarrollo de Toyota, especializada en seguridad de vehículos autónomos.

"Cuando un ser humano percibe un video, Hay ciertas suposiciones sobre la persistencia que usamos implícitamente:si vemos un automóvil dentro de un cuadro de video, esperamos ver un automóvil en una ubicación cercana en el siguiente cuadro de video. Esta es una de las varias 'condiciones de cordura' que queremos que satisfaga el algoritmo de percepción antes de la implementación ".

Por ejemplo, un objeto no puede aparecer y desaparecer de un fotograma al siguiente. Si lo hace, viola una "condición de cordura, "o ley básica de la física, lo que sugiere que hay un error en el sistema de percepción.

Deshmukh y su Ph.D. estudiante Balakrishnan, junto con USC Ph.D. el estudiante Xin Qin y el estudiante de maestría Aniruddh Puranic, se asoció con tres investigadores de la Universidad Estatal de Arizona para investigar el problema.

No hay lugar para el error

El equipo formuló una nueva lógica matemática, llamada Lógica temporal de calidad temporizada, y lo usó para probar dos herramientas populares de aprendizaje automático, Squeeze Det y YOLO, utilizando conjuntos de datos de video sin procesar de escenas de conducción.

La lógica se perfeccionó con éxito en los casos en que las herramientas de aprendizaje automático violaban las "condiciones de cordura" en varios fotogramas del video. Más comúnmente, los sistemas de aprendizaje automático no pudieron detectar un objeto o clasificaron erróneamente un objeto.

Por ejemplo, en un ejemplo, el sistema no reconoció a un ciclista desde atrás, cuando el neumático de la bicicleta parecía una delgada línea vertical. En lugar de, clasificó erróneamente al ciclista como peatón. En este caso, el sistema puede no anticipar correctamente el próximo movimiento del ciclista, lo que podría provocar un accidente.

Los objetos fantasmas, donde el sistema percibe un objeto cuando no hay ninguno, también eran comunes. Esto podría hacer que el automóvil golpeara por error los frenos, otro movimiento potencialmente peligroso.

El método del equipo podría usarse para identificar anomalías o errores en el algoritmo de percepción antes de la implementación en la carretera y permite al desarrollador identificar problemas específicos.

La idea es detectar problemas con el algoritmo de percepción en pruebas virtuales, haciendo que los algoritmos sean más seguros y fiables. Crucialmente, porque el método se basa en una biblioteca de "condiciones de cordura, "No es necesario que los humanos etiqueten los objetos en el conjunto de datos de prueba, un proceso que requiere mucho tiempo y que a menudo presenta fallas".

En el futuro, el equipo espera incorporar la lógica para volver a entrenar los algoritmos de percepción cuando encuentra un error. También podría extenderse al uso en tiempo real, mientras el auto está conduciendo, como monitor de seguridad en tiempo real.