Crédito:CC0 Public Domain

Una nueva investigación de SFI desafía una concepción popular de cómo los algoritmos de aprendizaje automático "piensan" sobre ciertas tareas.

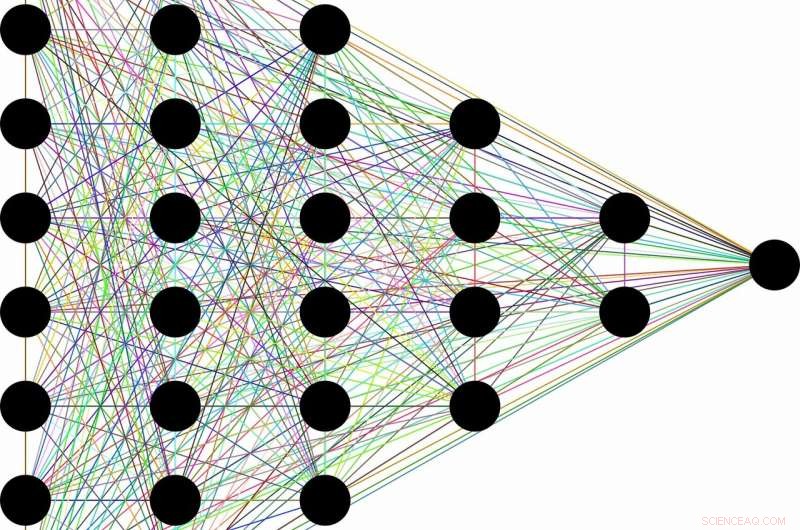

La concepción es algo así:debido a su capacidad para descartar información inútil, una clase de algoritmos de aprendizaje automático llamados redes neuronales profundas puede aprender conceptos generales a partir de datos sin procesar, como identificar gatos en general después de encontrar decenas de miles de imágenes de diferentes gatos en diferentes situaciones. Se dice que esta capacidad aparentemente humana surge como un subproducto de la arquitectura en capas de las redes. Las primeras capas codifican la etiqueta "gato" junto con toda la información en bruto necesaria para la predicción. Las capas subsiguientes luego comprimen la información, como a través de un cuello de botella. Datos irrelevantes, como el color del pelaje del gato, o el platillo de leche a su lado, está olvidado, dejando atrás solo las características generales. La teoría de la información proporciona límites sobre cuán óptima es cada capa, en términos de qué tan bien puede equilibrar las demandas competitivas de compresión y predicción.

"Muchas veces, cuando tienes una red neuronal y aprende a asignar caras a nombres, o imágenes a dígitos numéricos, o cosas asombrosas como texto en francés a texto en inglés, tiene muchas capas intermedias ocultas por las que fluye la información, "dice Artemy Kolchinsky, un becario postdoctoral de SFI y autor principal del estudio. "Así que existe esta idea de larga data de que a medida que los insumos sin procesar se transforman en estas representaciones intermedias, el sistema intercambia predicción por compresión, y la construcción de conceptos de nivel superior a través de este cuello de botella de información ".

Sin embargo, Kolchinsky y sus colaboradores Brendan Tracey (SFI, MIT) y Steven Van Kuyk (Universidad de Wellington) descubrieron una debilidad sorprendente cuando aplicaron esta explicación a problemas de clasificación comunes, donde cada entrada tiene una salida correcta (por ejemplo, en el que cada imagen puede ser de un gato o de un perro). En esos casos, encontraron que los clasificadores con muchas capas generalmente no renuncian a alguna predicción para mejorar la compresión. También encontraron que hay muchas representaciones "triviales" de las entradas que son, desde el punto de vista de la teoría de la información, óptimo en términos de su equilibrio entre predicción y compresión.

"Descubrimos que esta medida de cuello de botella de información no ve la compresión de la misma manera que usted o yo lo haríamos. Dada la opción, es igual de feliz agregar 'copas de martini' con 'Labradores', como es amontonarlos con 'copas de champán, '", Explica Tracey." Esto significa que debemos seguir buscando medidas de compresión que se ajusten mejor a nuestras nociones de compresión ".

Si bien la idea de comprimir las entradas aún puede desempeñar un papel útil en el aprendizaje automático, esta investigación sugiere que no es suficiente para evaluar las representaciones internas utilizadas por diferentes algoritmos de aprendizaje automático.

Al mismo tiempo, Kolchinsky dice que el concepto de compensación entre compresión y predicción seguirá siendo válido para tareas menos deterministas, como predecir el clima a partir de un conjunto de datos ruidoso. "No estamos diciendo que el cuello de botella de la información sea inútil para el aprendizaje [automático] supervisado, "Kolchinsky enfatiza." Lo que estamos mostrando aquí es que se comporta de manera contraintuitiva en muchos problemas comunes de aprendizaje automático, y eso es algo que la gente de la comunidad de aprendizaje automático debería conocer ".