Crédito:Tautkutè &Trzcinski

Investigadores de la Academia Polaco-Japonesa de Tecnología de la Información y la Universidad Tecnológica de Varsovia han desarrollado un modelo de red de alineación profunda (DAN) para clasificar y visualizar las emociones. Se descubrió que su método supera a los métodos de clasificación de emociones de última generación en dos conjuntos de datos de referencia.

Desarrollar modelos que puedan reconocer y clasificar las emociones humanas es un desafío clave en el campo del aprendizaje automático y la visión por computadora. La mayoría de las herramientas de reconocimiento de emociones existentes utilizan redes convolucionales de varias capas, que no infieren explícitamente rasgos faciales en la fase de clasificación.

Ivona Tautkute y Tomasz Trzcinski, los investigadores que llevaron a cabo el estudio reciente, inicialmente estaban trabajando en un sistema para una startup con sede en California que podría integrarse en automóviles autónomos. Este sistema pudo contar pasajeros basándose en datos extraídos de una sola cámara de video montada dentro del automóvil.

En una etapa posterior, los dos investigadores comenzaron a explorar modelos que podrían hacer más que esto, crear estadísticas más amplias sobre los pasajeros mediante la estimación de su edad y sexo. Una extensión obvia de este sistema era que detectaba expresiones faciales y emociones, así como.

"Como el sistema se iba a utilizar con pasajeros de edad avanzada, era importante capturar las emociones negativas y positivas asociadas con la desconexión del conductor, ", Explicó Tautkute." Los enfoques existentes para el reconocimiento de emociones están lejos de ser perfectos, así que empezamos a buscar nuevas formas interesantes de mejorar. Se nos ocurrió una idea después de una discusión con un compañero investigador de visión por computadora, Marek Kowalski, que estaba trabajando en la alineación facial con la red de alineación profunda (DAN). La ubicación de los puntos de referencia faciales está directamente relacionada con la emoción expresada, así que teníamos curiosidad por saber si podíamos construir un sistema que combinara esas dos tareas ".

EmotionalDAN, el modelo ideado por Tautkute y Trzcinski, es una adaptación del modelo DAN de Kowalski, que incluye un término relacionado con los rasgos faciales. Gracias a esta modificación, su modelo aprende simultáneamente la ubicación de los puntos de referencia faciales y la emoción expresada.

Crédito:Tautkutè &Trzcinski

Crédito:Tautkutè &Trzcinski

Crédito:Tautkutè &Trzcinski

Crédito:Tautkutè &Trzcinski

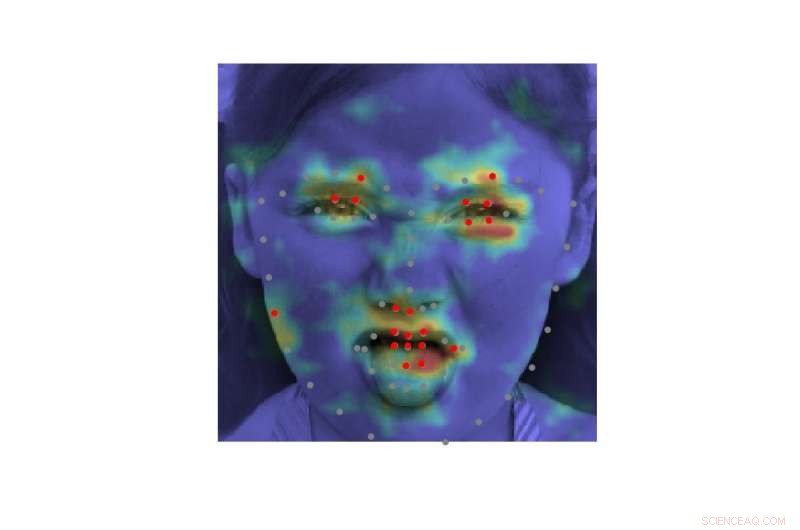

"Lo logramos ampliando la función de pérdida del DAN original con un término responsable de la clasificación de las emociones, "Dijo Tautkute." La red neuronal se entrena en etapas consecutivas que permiten el refinamiento de los puntos de referencia faciales y las emociones aprendidas. También hay una transferencia de información entre etapas, que realiza un seguimiento de la entrada normalizada de la cara, mapa de características y mapa de calor de puntos de referencia ".

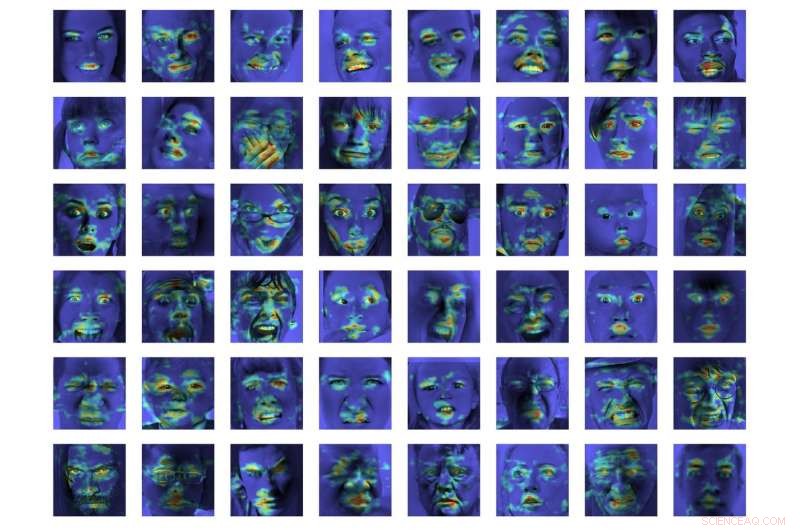

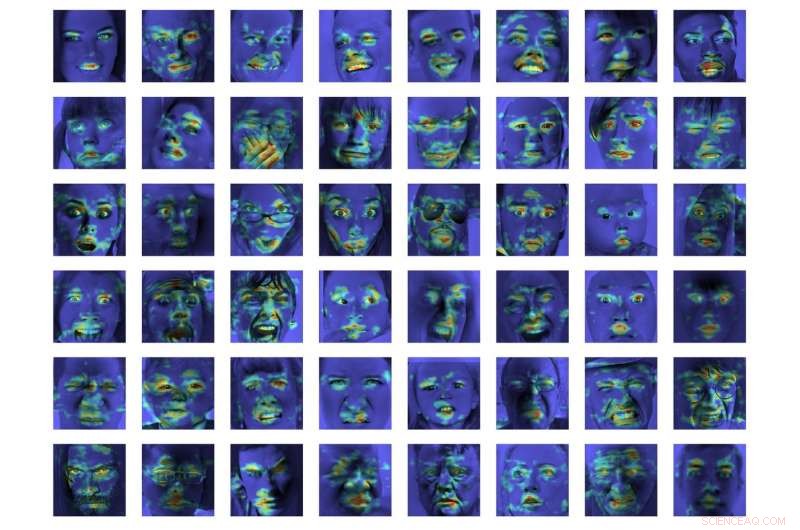

En una evaluación inicial, EmotionalDAN superó los métodos de clasificación de vanguardia en un 5 por ciento en dos conjuntos de datos de referencia, a saber, CK + e ISED. Los investigadores también pudieron visualizar regiones de imágenes analizadas por su modelo al tomar una decisión. Sus observaciones revelaron que EmotionalDAN podía identificar correctamente los puntos de referencia faciales asociados con la expresión de emociones en humanos.

"Lo realmente interesante de nuestro estudio es que, aunque no proporcionamos información espacial relacionada con las emociones a la red, el modelo es capaz de aprender por sí mismo qué regiones faciales deben observarse cuando se trata de comprender las expresiones faciales, "Dijo Tautkute." Los humanos miramos intuitivamente los ojos y la boca de una persona para notar sonrisas o tristeza, pero la red neuronal solo ve una matriz de píxeles. Verificar qué regiones de imagen se activan para una decisión de clasificación determinada nos acerca un paso más a comprender el modelo y cómo toma decisiones ".

Crédito:Tautkutè &Trzcinski.

A pesar de los resultados muy prometedores logrados por EmotionalDAN y otras herramientas de reconocimiento de emociones, comprender las emociones humanas sigue siendo una tarea muy compleja. Si bien los sistemas existentes han logrado resultados notables, principalmente han podido hacerlo cuando las emociones se expresan en un grado significativo.

En situaciones de la vida real, sin embargo, las señales emocionales expresadas por los humanos suelen ser mucho más sutiles. Por ejemplo, Es posible que la felicidad de una persona no siempre se transmita mostrando todos los dientes en una amplia sonrisa, pero podría implicar simplemente un ligero movimiento de las comisuras de los labios.

"Sería realmente interesante comprender los aspectos más subjetivos de la emoción y cómo su expresión difiere entre los individuos, "Tautkute dijo." Para ir más lejos, se podría intentar distinguir las emociones falsas de las genuinas. Por ejemplo, Los neurólogos afirman que diferentes músculos faciales están involucrados en sonrisas reales y falsas. En particular, los músculos oculares no se contraen en la expresión forzada. Sería interesante descubrir relaciones similares utilizando información extraída de los datos ".

© 2018 Science X Network