Crédito:Zimmer, Bonifacio y Dutech.

Investigadores de la Universidad de Lorena han ideado recientemente un nuevo tipo de aprendizaje de transferencia basado en el aprendizaje de refuerzo profundo sin modelos con ampliación continua del espacio sensoriomotor. Su enfoque presentado en un artículo publicado durante la octava Conferencia Internacional Conjunta del IEEE sobre Desarrollo y Aprendizaje y sobre Robótica Epigenética, y disponible gratuitamente en archivos-ouvertes de HAL, se inspira en el desarrollo infantil, particularmente por el crecimiento del espacio sensoriomotor que ocurre cuando un niño está adquiriendo nuevas y útiles estrategias.

"El marco formal del aprendizaje por refuerzo se puede utilizar para modelar una amplia gama de problemas, "dijo Matthieu Zimmer, uno de los investigadores que realizó el estudio. "En este marco, un agente usa un método de prueba y error para aprender lentamente qué secuencia de acciones es la más apropiada para alcanzar la meta deseada. Si se cumplen algunos requisitos, entonces la teoría nos dice que tenemos algoritmos que el agente puede usar para encontrar la solución óptima al problema, sin embargo, esto puede llevar mucho tiempo. Para acelerar este proceso, Exploramos formas para que un agente logre un buen desempeño en menos ensayos, incluso cuando casi no tiene conocimiento de la tarea que tendrá que resolver ".

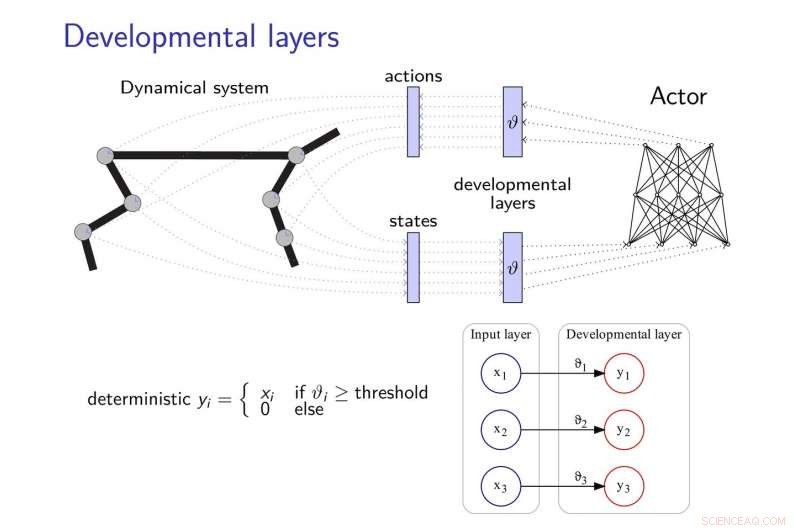

El método de aprendizaje por transferencia propuesto por Zimmer y sus colegas agrega capas de desarrollo a las redes neuronales, permitiéndoles desarrollar nuevas estrategias para completar tareas, especialmente cuando estas tareas están relacionadas de alguna manera. Estas capas de desarrollo descubren progresivamente algunas dimensiones del espacio sensoriomotor, siguiendo una motivación intrínseca heurística.

Para mitigar los efectos del "olvido catastrófico, "un problema común en el desarrollo de redes neuronales, los investigadores se inspiraron en la teoría de la consolidación del peso elástico, usándolo para regular el aprendizaje del controlador neuronal.

Crédito:Zimmer, Bonifacio y Dutech.

"La idea básica de nuestro trabajo es que el agente comience con una percepción y capacidades de acción muy limitadas y luego las desarrolle de manera evolutiva, inspirado en cómo aprende un niño, "dijo Alain Dutech, otro investigador que realizó el estudio. "Se reduce así el espacio en el que el agente busca una solución, y esta solución, aunque a un problema degradado, se puede encontrar más fácilmente. Luego aumentamos las capacidades del agente, aprovechando la solución anterior encontrada ".

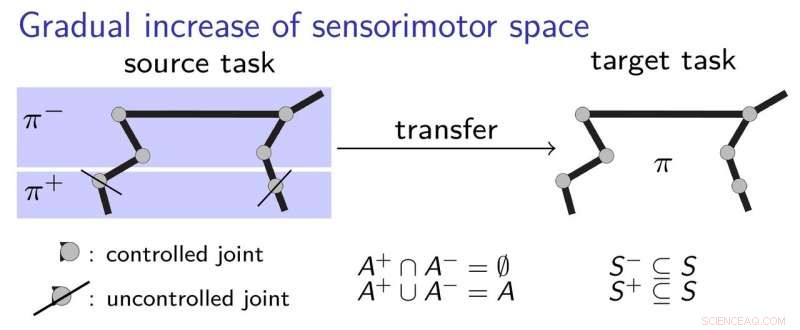

Para explicar mejor cómo funciona su enfoque de aprendizaje por transferencia, los investigadores utilizan el ejemplo de un niño que aprende a agarrar un bolígrafo. Inicialmente, el niño solo puede usar su codo y hombro, aprender a tocar el bolígrafo. Sucesivamente, ella podría decidir comenzar a usar la mano y los dedos, habiendo comprendido los conceptos básicos sobre la mejor forma de establecer un contacto inicial con la pluma. Esto implica un proceso de aprendizaje gradual, en el que el niño adquiere estrategias sensoriomotoras paso a paso, sin tener que aprender demasiadas cosas a la vez.

Los investigadores validaron su nuevo enfoque utilizando dos algoritmos de aprendizaje profundo de última generación, a saber, DDPG y NFAC, probado en Half-Cheetah y Humanoid, dos puntos de referencia de entornos de alta dimensión. Sus resultados sugieren que buscar una solución subóptima en un subconjunto del espacio de parámetros antes de considerar el espacio completo es una técnica útil para iniciar algoritmos de aprendizaje. lograr un mejor rendimiento con un entrenamiento más corto.

"En el campo muy activo y estimulante del aprendizaje de refuerzo profundo, hemos demostrado que los métodos de desarrollo como el nuestro, así como otros similares explorados por otros investigadores, podría combinarse con métodos de aprendizaje profundo para permitir el aprendizaje desde cero, con pocos conocimientos previos, "Dijo Zimmer.

A pesar de sus prometedores resultados, el estudio realizado por Zimmer y sus colegas también destacó la brecha que aún existe entre las habilidades de las redes neuronales profundas y los seres humanos. De hecho, incluso cuando se utiliza el aprendizaje por refuerzo del desarrollo, la mayoría de los agentes existentes son todavía mucho menos versátiles y eficientes que los humanos.

"Algunas veces, los humanos pueden aprender en una sola prueba, sin embargo, incluso el aprendizaje artificial más eficiente requerirá una combinación compleja de diferentes algoritmos para aprender, estimar, memorizar, comparar, y optimizar, "Dijo Zimmer." Además, algunos de estos algoritmos aún no están claramente definidos ".

Dutech y sus colegas ahora están explorando nuevos horizontes dentro del campo de la inteligencia artificial y el aprendizaje profundo. Por ejemplo, les gustaría desarrollar nuevas formas para que un agente de aprendizaje categorice adecuadamente los estímulos que percibe.

"El aprendizaje es mucho más eficiente cuando el agente puede interpretar lo que 've' o 'siente', ", Explicó Dutech." Hoy, la tendencia es utilizar redes neuronales y de aprendizaje profundo para hacer esto. Ahora estamos explorando otros métodos para extraer información pertinente y útil de la percepción bruta de los agentes artificiales, que dependen menos de tener un gran corpus de ejemplos; como el aprendizaje no supervisado y la autoorganización ".

© 2018 Tech Xplore