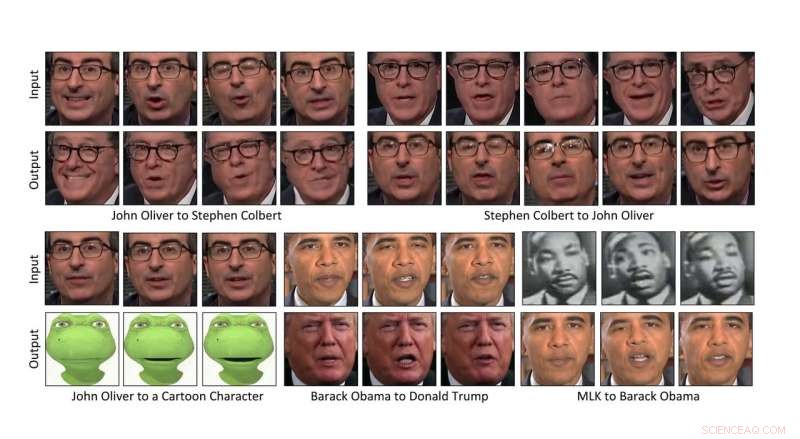

Investigadores de la Universidad Carnegie Mellon han ideado una forma de transformar automáticamente el contenido de un video al estilo de otro. haciendo posible transferir las expresiones faciales de una persona al video de otra persona, o incluso un personaje de dibujos animados. Crédito:Universidad Carnegie Mellon

Investigadores de la Universidad Carnegie Mellon han ideado una forma de transformar automáticamente el contenido de un video al estilo de otro. haciendo posible transferir las expresiones faciales del comediante John Oliver a las de un personaje de dibujos animados, o hacer florecer un narciso de la misma manera que lo haría un hibisco.

Dado que el método basado en datos no requiere intervención humana, puede transformar rápidamente grandes cantidades de video, convirtiéndolo en una bendición para la producción de películas. También se puede utilizar para convertir películas en blanco y negro a color y para crear contenido para experiencias de realidad virtual.

"Creo que hay muchas historias que contar, "dijo Aayush Bansal, un doctorado estudiante en el Instituto de Robótica de CMU. La producción cinematográfica fue su principal motivación para ayudar a idear el método, él explicó, permitiendo que las películas se produzcan de forma más rápida y económica. "Es una herramienta para el artista que les da un modelo inicial que luego pueden mejorar, "añadió.

La tecnología también tiene el potencial de utilizarse para las llamadas "falsificaciones profundas, "vídeos en los que se inserta la imagen de una persona sin permiso, hacer parecer que la persona ha hecho o dicho cosas que están fuera de lugar, Bansal reconoció.

"Fue una revelación para todos nosotros en el campo que tales falsificaciones se crearían y tendrían tal impacto, ", dijo." Encontrar formas de detectarlos será importante en el futuro ".

Bansal presentará el método hoy en ECCV 2018, la Conferencia Europea de Visión por Computador, en Munich. Sus coautores incluyen a Deva Ramanan, Profesor asociado de robótica CMU.

La transferencia de contenido de un video al estilo de otro se basa en la inteligencia artificial. En particular, una clase de algoritmos llamados redes generativas adversarias (GAN) han facilitado que las computadoras comprendan cómo aplicar el estilo de una imagen a otra, particularmente cuando no se han emparejado cuidadosamente.

En un GAN, se crean dos modelos:un discriminador que aprende a detectar lo que es consistente con el estilo de una imagen o video, y un generador que aprende a crear imágenes o videos que combinan con un estilo determinado. Cuando los dos trabajan de manera competitiva —el generador tratando de engañar al discriminador y el discriminador calificando la efectividad del generador— el sistema finalmente aprende cómo el contenido puede transformarse en un estilo determinado.

Una variante, llamado ciclo-GAN, completa el ciclo, muy parecido a traducir el habla del inglés al español y luego el español de nuevo al inglés y luego evaluar si el discurso traducido dos veces todavía tiene sentido. El uso de ciclo-GAN para analizar las características espaciales de las imágenes ha demostrado ser eficaz para transformar una imagen en el estilo de otra.

Ese método espacial todavía deja algo que desear para el video, con imperfecciones y artefactos no deseados que surgen en el ciclo completo de traducciones. Para mitigar el problema, los investigadores desarrollaron una técnica, llamado Recycle-GAN, que incorpora no solo espacial, sino información temporal. Esta información adicional, contabilizar los cambios a lo largo del tiempo, restringe aún más el proceso y produce mejores resultados.

Los investigadores demostraron que Recycle-GAN se puede usar para transformar un video de Oliver en lo que parece ser el también comediante Stephen Colbert y de nuevo en Oliver. O el video de la cara de John Oliver se puede transformar en un personaje de dibujos animados. Recycle-GAN permite no solo copiar las expresiones faciales, pero también los movimientos y la cadencia de la actuación.

Los efectos no se limitan a las caras, o incluso cuerpos. Los investigadores demostraron que el video de una flor en flor se puede utilizar para manipular la imagen de otros tipos de flores. O las nubes que cruzan el cielo rápidamente en un día ventoso pueden ralentizarse para dar la apariencia de un clima más tranquilo.

Estos efectos pueden resultar útiles para desarrollar vehículos autónomos que puedan circular de noche o con mal tiempo. Dijo Bansal. Obtener videos de escenas nocturnas o clima tormentoso en el que los objetos se puedan identificar y etiquetar puede ser difícil, él explicó. Reciclar-GAN, por otra parte, puede transformar escenas diurnas fácilmente obtenidas y etiquetadas en escenas nocturnas o tormentosas, proporcionando imágenes que se pueden utilizar para entrenar a los coches para que operen en esas condiciones.