Crédito:CC0 Public Domain

Las aplicaciones de software brindan a las personas muchos tipos de decisiones automatizadas, como identificar cuál es el riesgo crediticio de una persona, informar a un reclutador sobre qué candidato contratar, o determinar si alguien es una amenaza para el público. En años recientes, Los titulares de las noticias han advertido de un futuro en el que las máquinas operan en el contexto de la sociedad, decidir el curso de la vida humana utilizando una lógica poco confiable.

Parte de este miedo se deriva de la forma oscura en que operan muchos modelos de aprendizaje automático. Conocidos como modelos de caja negra, se definen como sistemas en los que el viaje desde la entrada hasta la salida es casi imposible de comprender incluso para sus desarrolladores.

"A medida que el aprendizaje automático se vuelve omnipresente y se utiliza para aplicaciones con consecuencias más graves, es necesario que las personas comprendan cómo está haciendo predicciones para que confíen en él cuando esté haciendo algo más que publicar un anuncio. "dice Jonathan Su, miembro del personal técnico del Grupo de Soporte de Informática y Decisiones del Laboratorio Lincoln del MIT.

En la actualidad, los investigadores utilizan técnicas post hoc o un modelo interpretable, como un árbol de decisiones, para explicar cómo un modelo de caja negra llega a su conclusión. Con técnicas post hoc, los investigadores observan las entradas y salidas de un algoritmo y luego intentan construir una explicación aproximada de lo que sucedió dentro de la caja negra. El problema con este método es que los investigadores solo pueden adivinar el funcionamiento interno, y las explicaciones a menudo pueden ser incorrectas. Árboles de decisión, qué mapas de opciones y sus posibles consecuencias en una construcción en forma de árbol, funcionan bien para datos categóricos cuyas características son significativas, pero estos árboles no son interpretables en dominios importantes, como la visión por computadora y otros problemas de datos complejos.

Su dirige un equipo en el laboratorio que colabora con la profesora Cynthia Rudin en la Universidad de Duke, junto con los estudiantes de Duke Chaofan Chen, Oscar Li, y Alina Barnett, a investigar métodos para reemplazar modelos de caja negra con métodos de predicción más transparentes. Su proyecto, llamado Aprendizaje automático interpretable adaptable (AIM), se centra en dos enfoques:redes neuronales interpretables y listas de reglas bayesianas (BRL) adaptables e interpretables.

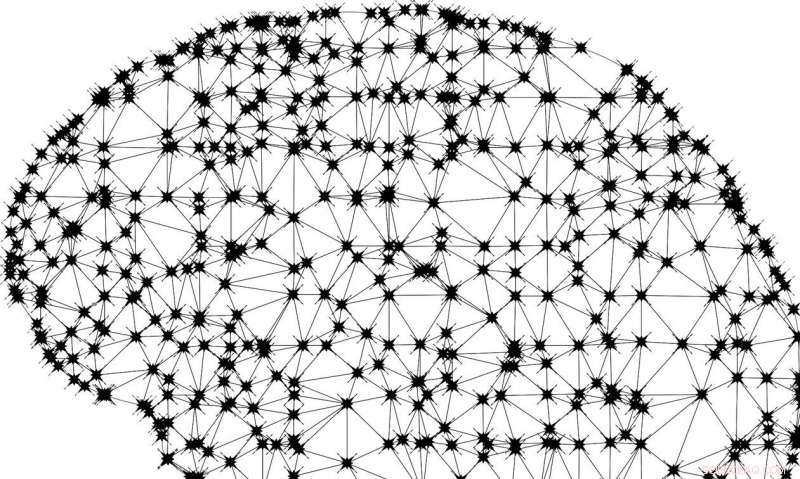

Una red neuronal es un sistema informático compuesto por muchos elementos de procesamiento interconectados. Estas redes se utilizan normalmente para el análisis de imágenes y el reconocimiento de objetos. Por ejemplo, se puede enseñar a un algoritmo a reconocer si una fotografía incluye a un perro mostrándole primero fotografías de perros. Los investigadores dicen que el problema con estas redes neuronales es que sus funciones no son lineales y recursivas, así como complicado y confuso para los humanos, y el resultado final es que es difícil precisar qué es exactamente lo que la red ha definido como "dogness" en las fotos y qué la llevó a esa conclusión.

Para abordar este problema, el equipo está desarrollando lo que llama "redes neuronales prototipo". Estas son diferentes de las redes neuronales tradicionales en que codifican naturalmente explicaciones para cada una de sus predicciones mediante la creación de prototipos, que son partes particularmente representativas de una imagen de entrada. Estas redes hacen sus predicciones basándose en la similitud de partes de la imagen de entrada con cada prototipo.

Como ejemplo, si una red tiene la tarea de identificar si una imagen es un perro, gato, o caballo, compararía partes de la imagen con prototipos de partes importantes de cada animal y usaría esta información para hacer una predicción. Un artículo sobre este trabajo:"Esto se ve así:aprendizaje profundo para el reconocimiento de imágenes interpretables, "apareció recientemente en un episodio del podcast" Data Science at Home ". Un artículo anterior, "Aprendizaje profundo para el razonamiento basado en casos a través de prototipos:una red neuronal que explica sus predicciones, "usó imágenes enteras como prototipos, en lugar de partes.

La otra área que está investigando el equipo de investigación son los BRL, que son menos complicados, Árboles de decisión unilaterales que son adecuados para datos tabulares y, a menudo, tan precisos como otros modelos. Los BRL están hechos de una secuencia de declaraciones condicionales que naturalmente forman un modelo interpretable. Por ejemplo, si la presión arterial es alta, entonces el riesgo de enfermedad cardíaca es alto. Su y sus colegas están utilizando propiedades de BRL para permitir a los usuarios indicar qué características son importantes para una predicción. También están desarrollando BRL interactivos, que se puede adaptar inmediatamente cuando llegan nuevos datos en lugar de volver a calibrar desde cero en un conjunto de datos en constante crecimiento.

Stephanie Carnell, estudiante de posgrado de la Universidad de Florida y pasante de verano en el Grupo de apoyo a la toma de decisiones e informática, está aplicando los BRL interactivos del programa AIM a un proyecto para ayudar a los estudiantes de medicina a mejorar sus entrevistas y diagnósticos de pacientes. En la actualidad, Los estudiantes de medicina practican estas habilidades entrevistando a pacientes virtuales y recibiendo una puntuación sobre la cantidad de información de diagnóstico importante que pudieron descubrir. Pero la partitura no incluye una explicación de qué, precisamente, en la entrevista que hicieron los estudiantes para lograr su puntaje. El proyecto AIM espera cambiar esto.

"Me imagino que la mayoría de los estudiantes de medicina se sienten bastante frustrados al recibir una predicción sobre el éxito sin una razón concreta por la que, "Dice Carnell." Las listas de reglas generadas por AIM deberían ser un método ideal para brindar a los estudiantes, retroalimentación comprensible ".

El programa AIM es parte de la investigación en curso en el laboratorio de ingeniería de sistemas humanos, o la práctica de diseñar sistemas que sean más compatibles con la forma en que las personas piensan y funcionan. como comprensible, en lugar de oscuro, algoritmos.

"El laboratorio tiene la oportunidad de ser un líder mundial en unir humanos y tecnología, "dice Hayley Reynolds, subdirector del Grupo de Apoyo a la Toma de Decisiones e Informática. "Estamos en la cúspide de grandes avances".

Melva James es otro miembro del personal técnico del Grupo de apoyo a la toma de decisiones e informática involucrado en el proyecto AIM. "En el laboratorio hemos desarrollado implementaciones de Python tanto de BRL como de BRL interactivos, "Ella dice." [Nosotros] simultáneamente estamos probando la salida de las implementaciones de BRL y BRL interactivas en diferentes sistemas operativos y plataformas de hardware para establecer la portabilidad y reproducibilidad. También estamos identificando aplicaciones prácticas adicionales de estos algoritmos ".

Su explica:"Esperamos desarrollar una nueva capacidad estratégica para el laboratorio:algoritmos de aprendizaje automático en los que la gente confía porque los comprende".

Esta historia se vuelve a publicar por cortesía de MIT News (web.mit.edu/newsoffice/), un sitio popular que cubre noticias sobre la investigación del MIT, innovación y docencia.