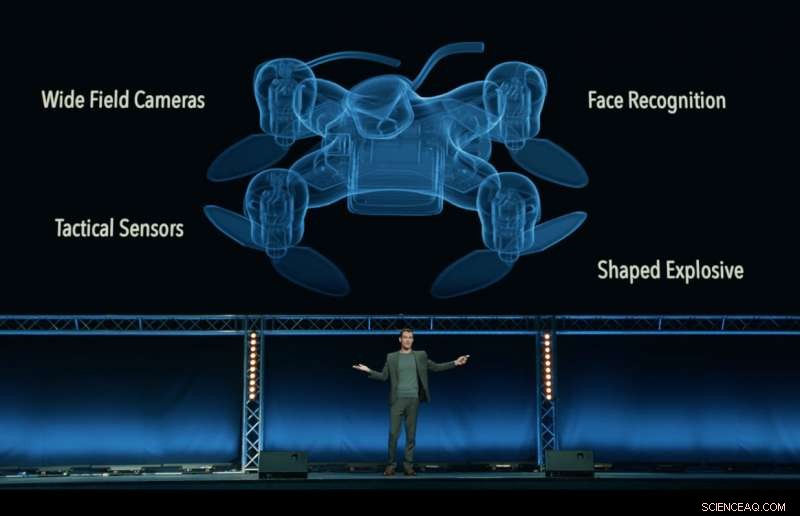

Fotograma del video 'Slaughterbots', producido por el Future of Life Institute, que muestra un futuro distópico ficticio de drones asesinos que pululan por el mundo. Crédito:Instituto del Futuro de la Vida

Un quién es quién de los directores ejecutivos, ingenieros y científicos de la industria de la tecnología, incluido Google DeepMind, la Fundación XPRIZE y Elon Musk, han firmado un compromiso de "no participar ni apoyar el desarrollo, fabricar, comercio, o uso de armas autónomas letales ".

Publicado en Estocolmo en la Conferencia Internacional Conjunta sobre Inteligencia Artificial (IJCAI) de 2018, la reunión de investigación de IA líder en el mundo con más de 5, 000 asistentes, el compromiso fue firmado por 150 empresas y más de 2, 400 personas de 90 países que trabajan en inteligencia artificial (IA) y robótica.

Los firmantes corporativos incluyen Google DeepMind, University College de Londres, la Fundación XPRIZE, ClearPath Robotics / OTTO Motors, la Asociación Europea de IA, y la Sociedad Sueca de IA. Entre las personas se incluyen el jefe de investigación de Google.ai Jeff Dean, Stuart Russell, pioneros de la IA, Yoshua Bengio, Anca Dragan y Toby Walsh, y el parlamentario laborista británico Alex Sobel.

La prenda, organizado por el Future of Life Institute, desafía a los gobiernos, la academia y la industria para seguir su ejemplo, diciendo:"Nosotros, el abajo firmante, hacer un llamado a los gobiernos y líderes gubernamentales para crear un futuro con normas internacionales sólidas, reglamentos y leyes contra las armas autónomas letales. ... Pedimos a las empresas y organizaciones de tecnología, así como líderes, Responsables políticos, y otras personas, únete a nosotros en este compromiso ".

Max Tegmark, profesor de física en el Instituto de Tecnología de Massachusetts y presidente del Instituto del Futuro de la Vida, anunció el compromiso.

"Estoy emocionado de ver a los líderes de IA pasar de la palabra a la acción, implementar una política que los políticos hasta ahora no han logrado poner en práctica, ", Dijo Tegmark." La IA tiene un enorme potencial para ayudar al mundo, si estigmatizamos y prevenimos su abuso. Las armas de IA que deciden de forma autónoma matar personas son tan repugnantes y desestabilizadoras como las armas biológicas, y debe tratarse de la misma manera ".

Los sistemas de armas autónomos letales (LAWS), también denominados 'robots asesinos', son armas que pueden identificar, objetivo, y matar a una persona, sin un humano 'in-the-loop'. Es decir, nadie toma la decisión final de autorizar la fuerza letal:la decisión y autorización sobre si alguien morirá o no se deja al sistema autónomo de armas. Esto no incluye los drones de hoy, que están bajo control humano; ni sistemas autónomos que se limiten a defenderse de otras armas.

El compromiso comienza con la declaración:"La inteligencia artificial está preparada para desempeñar un papel cada vez más importante en los sistemas militares. Existe una oportunidad y una necesidad urgente para los ciudadanos, Responsables políticos, y líderes para distinguir entre usos aceptables e inaceptables de la IA ".

Otro organizador clave del compromiso, Toby Walsh, profesor de inteligencia artificial en la Universidad Australiana de Nueva Gales del Sur en Sydney, señala las espinosas cuestiones éticas que rodean a las LEYES:"No podemos entregar la decisión de quién vive y quién muere a las máquinas. No tienen la ética para hacerlo. Los animo a ustedes y a sus organizaciones a comprometerse a garantizar que la guerra no volverse más terrible de esta manera ".

Ryan Gariepy, Fundador y CTO de Clearpath Robotics y OTTO Motors, un fuerte oponente de las armas autónomas letales, se hizo eco del llamado:"Clearpath sigue creyendo que la proliferación de sistemas de armas autónomas letales sigue siendo un peligro claro y presente para los ciudadanos de todos los países del mundo. Ninguna nación estará a salvo, no importa lo poderoso que sea.

"Las preocupaciones de Clearpath son compartidas por una amplia variedad de otras empresas y desarrolladores de sistemas autónomos clave, y esperamos que los gobiernos de todo el mundo decidan invertir su tiempo y esfuerzo en sistemas autónomos que mejoren la salud de sus poblaciones, más seguro y más productivos en lugar de sistemas cuyo único uso es el despliegue de fuerza letal, "añadió.

Toby Walsh, profesor de inteligencia artificial en la Universidad de Nueva Gales del Sur de Australia en Sydney, con un robot Baxter. Crédito:Grant Turner / UNSW

Además de las preocupantes cuestiones éticas que rodean a las armas autónomas letales, muchos defensores de una prohibición internacional de los LAWS están preocupados de que serán difíciles de controlar, más fáciles de piratear, más probabilidades de acabar en el mercado negro, y más fácil de obtener para los terroristas y déspotas, lo que podría resultar desestabilizador para todos los países. Tal escenario se desarrolla en el video Slaughterbots lanzado por FLI.

En diciembre de 2016, La Conferencia de Revisión de la Convención sobre Armas Convencionales (CCW) de las Naciones Unidas inició un debate formal sobre las LEYES. 26 países asistentes a la Conferencia han anunciado hasta ahora su apoyo a algún tipo de prohibición, incluida China.

Tal prohibición no carece de precedentes:también se prohibieron las armas biológicas y químicas, no solo por razones éticas y humanitarias, sino también por la amenaza desestabilizadora que representaban.

La próxima reunión de la ONU sobre LAWS se llevará a cabo en agosto de 2018, y los signatarios del compromiso esperan que su compromiso aliente a los legisladores a desarrollar un compromiso con un acuerdo internacional entre países.

Como dice el compromiso:"Nosotros, el abajo firmante, hacer un llamado a los gobiernos y líderes gubernamentales para crear un futuro con normas internacionales sólidas, reglamentos y leyes contra las armas autónomas letales. ... Pedimos a las empresas y organizaciones de tecnología, así como líderes, Responsables políticos, y otras personas, únete a nosotros en este compromiso ".

El texto completo del compromiso

La inteligencia artificial (IA) está preparada para desempeñar un papel cada vez más importante en los sistemas militares. Existe una oportunidad y una necesidad urgente para los ciudadanos, Responsables políticos, y líderes para distinguir entre usos aceptables e inaceptables de la IA.

En esta luz, los abajo firmantes estamos de acuerdo en que la decisión de quitar una vida humana nunca debe delegarse en una máquina. Hay un componente moral en esta posición, que no debemos permitir que las máquinas tomen decisiones que tomen vidas por las cuales otros —o nadie— serán culpables.

También hay un poderoso argumento pragmático:armas autónomas letales, seleccionar y comprometer objetivos sin intervención humana, sería peligrosamente desestabilizador para todos los países e individuos. Miles de investigadores de IA están de acuerdo en que al eliminar el riesgo, atribuibilidad, y dificultad de quitar vidas humanas, las armas autónomas letales podrían convertirse en poderosos instrumentos de violencia y opresión, especialmente cuando está vinculado a sistemas de datos y vigilancia.

Es más, Las armas autónomas letales tienen características bastante diferentes a las nucleares, armas químicas y biológicas, y las acciones unilaterales de un solo grupo podrían desencadenar con demasiada facilidad una carrera armamentista para la que la comunidad internacional carece de las herramientas técnicas y los sistemas de gobernanza global para gestionar. La estigmatización y la prevención de esa carrera de armamentos debe ser una de las principales prioridades para la seguridad nacional y mundial.

Nosotros, el abajo firmante, hacer un llamado a los gobiernos y líderes gubernamentales para crear un futuro con normas internacionales sólidas, reglamentos y leyes contra las armas autónomas letales. Estos actualmente ausentes, optamos por mantenernos a un alto nivel:no participaremos ni apoyaremos el desarrollo, fabricar, comercio, o uso de armas autónomas letales. Pedimos que las empresas y organizaciones de tecnología, así como líderes, Responsables políticos, y otras personas, únete a nosotros en este compromiso.