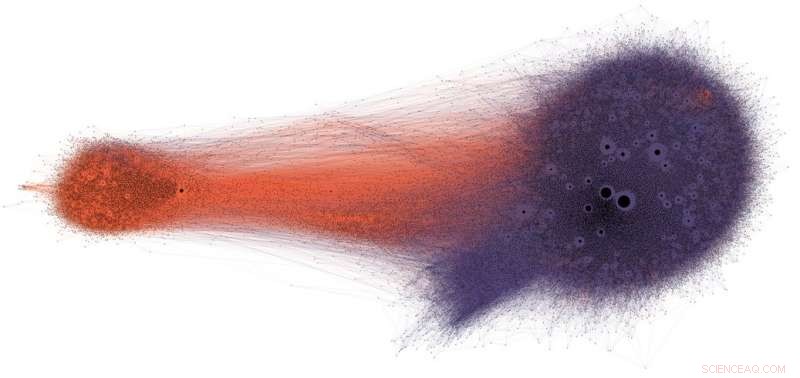

Las personas que comparten información errónea potencial en Twitter (en púrpura) rara vez ven correcciones o verificación de datos (en naranja). Crédito:Shao et al., CC BY-ND

Las redes sociales se encuentran entre las principales fuentes de noticias en los EE. UU. Y en todo el mundo. Sin embargo, los usuarios están expuestos a contenido de precisión cuestionable, incluidas las teorías de la conspiración, clickbait, contenido hiperpartidista, pseudociencia e incluso fabricaron informes de "noticias falsas".

No es sorprendente que se publique tanta desinformación:el spam y el fraude en línea son lucrativos para los delincuentes, y la propaganda política y gubernamental produce beneficios tanto partidistas como financieros. Pero el hecho de que el contenido de baja credibilidad se difunda tan rápida y fácilmente sugiere que las personas y los algoritmos detrás de las plataformas de redes sociales son vulnerables a la manipulación.

Nuestra investigación ha identificado tres tipos de sesgos que hacen que el ecosistema de las redes sociales sea vulnerable a la desinformación intencional y accidental. Es por eso que nuestro Observatorio de Redes Sociales en la Universidad de Indiana está creando herramientas para ayudar a las personas a tomar conciencia de estos prejuicios y protegerse de las influencias externas diseñadas para explotarlos.

Sesgo en el cerebro

Los sesgos cognitivos se originan en la forma en que el cerebro procesa la información que cada persona encuentra todos los días. El cerebro solo puede manejar una cantidad finita de información, y demasiados estímulos entrantes pueden causar una sobrecarga de información. Eso en sí mismo tiene serias implicaciones para la calidad de la información en las redes sociales. Hemos descubierto que la fuerte competencia por la atención limitada de los usuarios significa que algunas ideas se vuelven virales a pesar de su baja calidad, incluso cuando las personas prefieren compartir contenido de alta calidad.

Para evitar abrumarse, el cerebro utiliza una serie de trucos. Estos métodos suelen ser eficaces, pero también pueden convertirse en sesgos cuando se aplican en contextos incorrectos.

Un atajo cognitivo ocurre cuando una persona decide si desea compartir una historia que aparece en sus redes sociales. Las personas se ven muy afectadas por las connotaciones emocionales de un titular, aunque ese no es un buen indicador de la precisión de un artículo. Mucho más importante es quién escribió la pieza.

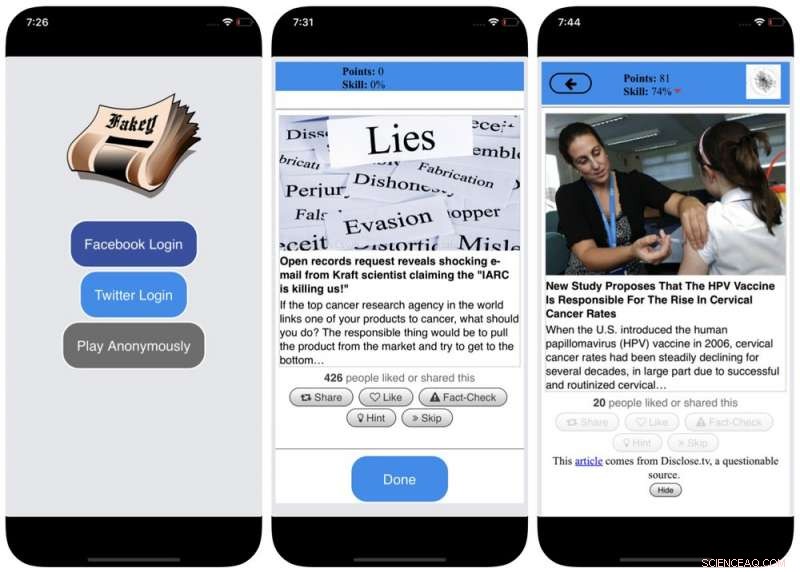

Para contrarrestar este sesgo, y ayudar a las personas a prestar más atención al origen de una reclamación antes de compartirla, desarrollamos Fakey, un juego de alfabetización de noticias para dispositivos móviles (gratuito en Android e iOS) que simula una fuente de noticias típica de las redes sociales, con una combinación de artículos de noticias de fuentes convencionales y de baja credibilidad. Los jugadores obtienen más puntos por compartir noticias de fuentes confiables y marcar contenido sospechoso para verificar los hechos. En el proceso, aprenden a reconocer las señales de la credibilidad de la fuente, como afirmaciones hiperpartidistas y titulares cargados de emociones.

Sesgo en la sociedad

Otra fuente de prejuicios proviene de la sociedad. Cuando las personas se conectan directamente con sus compañeros, los prejuicios sociales que guían su selección de amigos llegan a influir en la información que ven.

De hecho, En nuestra investigación hemos encontrado que es posible determinar las inclinaciones políticas de un usuario de Twitter simplemente mirando las preferencias partidistas de sus amigos. Nuestro análisis de la estructura de estas redes de comunicación partidistas encontró que las redes sociales son particularmente eficientes para difundir información, precisa o no, cuando están estrechamente vinculadas y desconectadas de otras partes de la sociedad.

La tendencia a evaluar la información de manera más favorable si proviene de sus propios círculos sociales crea "cámaras de eco" que están maduras para la manipulación. ya sea consciente o involuntariamente. Esto ayuda a explicar por qué tantas conversaciones en línea se convierten en confrontaciones de "nosotros contra ellos".

Capturas de pantalla del juego Fakey. Crédito:Mihai Avram y Filippo Menczer

Estudiar cómo la estructura de las redes sociales en línea hace que los usuarios sean vulnerables a la desinformación, construimos Hoaxy, un sistema que rastrea y visualiza la difusión de contenido de fuentes de baja credibilidad, y cómo compite con el contenido de verificación de hechos. Nuestro análisis de los datos recopilados por Hoaxy durante las elecciones presidenciales de EE. UU. De 2016 muestra que las cuentas de Twitter que compartían información errónea fueron casi completamente excluidas de las correcciones realizadas por los verificadores de hechos.

Cuando profundizamos en las cuentas que difunden información errónea, encontramos un grupo central muy denso de cuentas que se retuitean entre sí casi exclusivamente, incluidos varios bots. Las únicas ocasiones en que los usuarios del grupo desinformado citaron o mencionaron organizaciones de verificación de hechos fueron cuando cuestionaron su legitimidad o afirmaron lo contrario de lo que escribieron.

Sesgo en la máquina

El tercer grupo de sesgos surge directamente de los algoritmos utilizados para determinar lo que las personas ven en línea. Tanto las plataformas de redes sociales como los motores de búsqueda las emplean. Estas tecnologías de personalización están diseñadas para seleccionar solo el contenido más atractivo y relevante para cada usuario individual. Pero al hacerlo, puede acabar reforzando los sesgos cognitivos y sociales de los usuarios, haciéndolos aún más vulnerables a la manipulación.

Por ejemplo, Las herramientas publicitarias detalladas integradas en muchas plataformas de redes sociales permiten a los activistas de desinformación explotar el sesgo de confirmación adaptando los mensajes a las personas que ya están inclinadas a creer en ellos.

También, si un usuario hace clic a menudo en enlaces de Facebook de una fuente de noticias en particular, Facebook tenderá a mostrarle a esa persona más contenido de ese sitio. Este llamado efecto de "burbuja de filtro" puede aislar a las personas de diversas perspectivas, fortalecer el sesgo de confirmación.

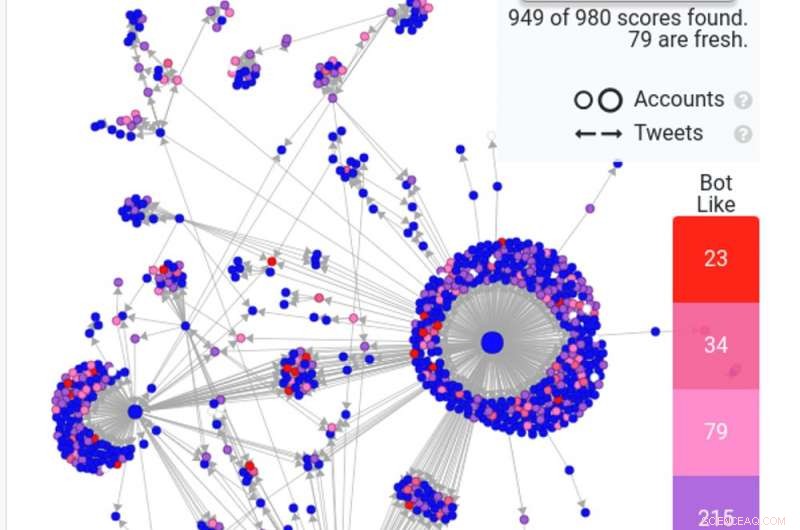

Una captura de pantalla de una búsqueda de Hoaxy muestra cómo los bots comunes, en rojo y rosa oscuro, están difundiendo una historia falsa en Twitter. Crédito:Hoaxy

Nuestra propia investigación muestra que las plataformas de redes sociales exponen a los usuarios a un conjunto de fuentes menos diverso que los sitios que no son redes sociales como Wikipedia. Dado que se trata de una plataforma completa, no de un solo usuario, a esto lo llamamos sesgo de homogeneidad.

Otro ingrediente importante de las redes sociales es la información que es tendencia en la plataforma, según lo que obtenga la mayor cantidad de clics. A esto lo llamamos sesgo de popularidad, porque hemos descubierto que un algoritmo diseñado para promover contenido popular puede afectar negativamente la calidad general de la información en la plataforma. Esto también alimenta el sesgo cognitivo existente, reforzando lo que parece ser popular independientemente de su calidad.

Todos estos sesgos algorítmicos pueden ser manipulados por bots sociales, programas de computadora que interactúan con humanos a través de cuentas de redes sociales. La mayoría de los bots sociales como el Big Ben de Twitter, son inofensivos. Sin embargo, algunos ocultan su naturaleza real y se utilizan con fines maliciosos, como impulsar la desinformación o crear falsamente la apariencia de un movimiento de base, también llamado "astroturfing". Encontramos evidencia de este tipo de manipulación en el período previo a las elecciones de mitad de período de 2010 en EE. UU.

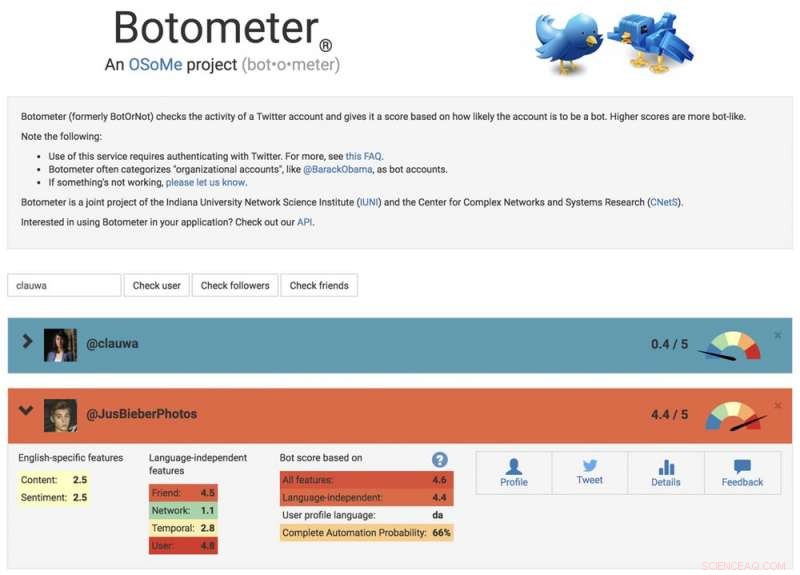

Para estudiar estas estrategias de manipulación, Desarrollamos una herramienta para detectar bots sociales llamada Botometer. Botometer utiliza el aprendizaje automático para detectar cuentas de bot, inspeccionando miles de funciones diferentes de las cuentas de Twitter, como los tiempos de sus publicaciones, con qué frecuencia tuitea, y las cuentas que sigue y retuitea. No es perfecto pero ha revelado que hasta el 15 por ciento de las cuentas de Twitter muestran signos de ser bots.

Usando Botometer junto con Hoaxy, Analizamos el núcleo de la red de desinformación durante la campaña presidencial estadounidense de 2016. Encontramos muchos bots que explotaban tanto el cognitivo como el los sesgos de confirmación y popularidad de sus víctimas y los sesgos algorítmicos de Twitter.

Estos bots pueden construir burbujas de filtro alrededor de usuarios vulnerables, alimentándolos con afirmaciones falsas y desinformación. Primero, pueden atraer la atención de usuarios humanos que apoyan a un candidato en particular al tuitear los hashtags de ese candidato o al mencionar y retuitear a la persona. Luego, los bots pueden amplificar las afirmaciones falsas que difaman a los oponentes retuiteando artículos de fuentes de baja credibilidad que coinciden con ciertas palabras clave. Esta actividad también hace que el algoritmo resalte para otros usuarios historias falsas que se están compartiendo ampliamente.

Una captura de pantalla del sitio web de Botometer, mostrando una cuenta de humano y una de bot. Crédito:Botometer

Comprender vulnerabilidades complejas

Incluso como nuestra investigación, y otros', muestra cómo los individuos, instituciones e incluso sociedades enteras pueden ser manipuladas en las redes sociales, quedan muchas preguntas por responder. Es especialmente importante descubrir cómo estos diferentes sesgos interactúan entre sí, potencialmente creando vulnerabilidades más complejas.

Herramientas como la nuestra ofrecen a los usuarios de Internet más información sobre desinformación, y por lo tanto cierto grado de protección contra sus daños. Es probable que las soluciones no sean solo tecnológicas, aunque probablemente habrá algunos aspectos técnicos en ellos. Pero deben tener en cuenta los aspectos cognitivos y sociales del problema.

Nota del editor:este artículo se actualizó el 10 de enero de 2019, para eliminar un enlace a un estudio que se ha retirado. El texto del artículo sigue siendo exacto, y permanece sin cambios.

Este artículo se publicó originalmente en The Conversation. Lea el artículo original.