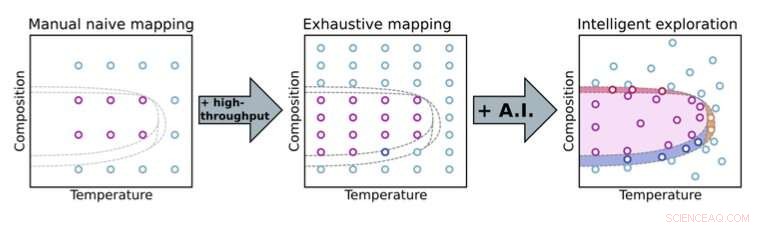

Pasar de un enfoque de experimentación manual a uno automatizado permite a los científicos explorar más a fondo los espacios de parámetros. Con métodos de toma de decisiones de inteligencia artificial (IA), los científicos pueden centrarse en partes clave del espacio de parámetros (aquí, composición y temperatura) para el descubrimiento acelerado de materiales. Crédito:Laboratorio Nacional Brookhaven

En la visión popular de la ciencia tradicional, los científicos están en el laboratorio sobre sus experimentos, microgestión de cada pequeño detalle. Por ejemplo, pueden probar iterativamente una amplia variedad de composiciones de materiales, protocolos de síntesis y procesamiento, y condiciones ambientales para ver cómo estos parámetros influyen en las propiedades del material. En cada iteración, analizan los datos recopilados, buscando patrones y confiando en su conocimiento científico e intuición para seleccionar mediciones de seguimiento útiles.

Este enfoque manual consume un tiempo de instrumentación limitado y la atención de expertos humanos que, de otro modo, podrían centrarse en el panorama general. Los experimentos manuales también pueden ser ineficaces, especialmente cuando hay un gran conjunto de parámetros para explorar, y están sujetos a prejuicios humanos, por ejemplo, para decidir cuándo se han recopilado suficientes datos y se puede detener un experimento. La forma convencional de hacer ciencia no puede escalar para manejar la enorme complejidad de los desafíos científicos futuros. Los avances en los instrumentos científicos y las capacidades de análisis de datos en las instalaciones experimentales continúan permitiendo mediciones más rápidas. Si bien estos avances pueden ayudar a los científicos a abordar problemas experimentales complejos, también exacerban el cuello de botella humano; ¡ningún ser humano puede seguir el ritmo de las modernas herramientas experimentales!

Visualizando la automatización

Una de esas instalaciones que gestiona este tipo de desafíos es la Fuente de luz sincrotrón nacional II (NSLS-II) en el Laboratorio nacional de Brookhaven del Departamento de Energía de EE. UU. (DOE). Dirigiendo haces de luz, que van desde infrarrojos hasta rayos X duros, hacia muestras en estaciones experimentales (líneas de luz), NSLS-II puede revelar la electrónica, químico, y estructuras atómicas de materiales. Cuando los científicos estaban diseñando estas líneas de luz hace una década, tuvieron la previsión de incorporar la automatización habilitada por el aprendizaje automático (ML) y la inteligencia artificial (IA), ahora un campo en expansión, como parte de su visión.

"Pensamos, ¿No sería genial si los científicos no solo pudieran realizar mediciones más rápido sino también realizar una exploración inteligente, es decir, explorar problemas científicos de forma más inteligente, formas más eficientes aprovechando los métodos modernos de informática, "dijo Kevin Yager, líder del Grupo de Nanomateriales Electrónicos del Centro de Nanomateriales Funcionales (CFN) en Brookhaven Lab. "De hecho, en el CFN, hemos definido uno de nuestros temas de investigación como el descubrimiento acelerado de nanomateriales ".

Esta idea de una línea de luz altamente automatizada que podría explorar de manera inteligente problemas científicos terminó convirtiéndose en un objetivo a largo plazo de la línea de luz de Dispersión de Materiales Complejos (CMS). desarrollado y operado por un equipo dirigido por Masafumi Fukuto.

"Comenzamos por desarrollar capacidades de alto rendimiento para mediciones rápidas, como un robot de intercambio de muestras y muchas herramientas in situ para explorar diferentes parámetros como la temperatura, presión de vapor, y humedad, "dijo Fukuto." Al mismo tiempo, comenzamos a pensar en automatizar no solo el hardware de la línea de luz para la recopilación de datos, sino también el análisis de datos en tiempo real y la toma de decisiones experimentales. La capacidad de tomar medidas muy rápidamente es útil y necesaria pero no suficiente para el descubrimiento de materiales revolucionarios porque los espacios de parámetros de materiales son muy grandes y multidimensionales ".

Por ejemplo, un experimento puede tener un espacio de parámetros con cinco dimensiones y más de 25, 000 puntos distintos dentro de ese espacio para explorar. Tanto el software de adquisición como de análisis de datos para hacer frente a estos grandes Los espacios de parámetros de alta dimensión se construyeron en casa en Brookhaven. Para la recopilación de datos, construyeron sobre el software Bluesky, que NSLS-II desarrolló. Para analizar los datos, Yager escribió código para un software de análisis de imágenes llamado SciAnalysis.

Cerrando el ciclo

En 2017, Fukuto y Yager comenzaron a colaborar con Marcus Noack, luego un postdoctorado y ahora un científico investigador en el Centro de Matemáticas Avanzadas para Aplicaciones de Investigación de Energía (CAMERA) en el Laboratorio Nacional Lawrence Berkeley del DOE. Durante su tiempo como postdoctorado, Noack tuvo la tarea de colaborar con el equipo de Brookhaven en su concepto de línea de luz autónoma. Específicamente, trabajaron juntos para desarrollar la última pieza para crear una configuración experimental totalmente automatizada:un algoritmo de toma de decisiones. El equipo de Brookhaven definió sus necesidades, mientras que Noack brindó su experiencia en matemáticas aplicadas y escribió el software para satisfacer estas necesidades.

Al aprovechar la inteligencia artificial y el aprendizaje automático, este algoritmo determina las mejores medidas siguientes para realizar mientras se realiza un experimento. (AI se refiere a una máquina que simula el comportamiento humano, mientras que ML es un subcampo de IA en el que una máquina aprende automáticamente de datos pasados). Para que el algoritmo comience a modelar un sistema, es tan simple como que un usuario defina las entradas y salidas:cuáles son las variables que puedo controlar en el experimento, y que voy a medir Pero cuanta más información proporcionen los humanos con anticipación, como la respuesta esperada del sistema o las restricciones conocidas basadas en el problema particular que se está estudiando, más robusto será el modelo. Entre bastidores, un proceso gaussiano está en funcionamiento modelando el comportamiento del sistema.

"Un proceso gaussiano es una forma matemáticamente rigurosa de estimar la incertidumbre, "explicó Yager." Esa es otra forma de decir conocimiento en mi mente. Y esa es otra forma de decir ciencia. Porque en la ciencia eso es lo que más nos interesa:¿Qué sé yo? y ¿qué tan bien lo conozco? "

"Esa es la parte de ML, "añadió Fukuto." El algoritmo va un paso más allá de eso. Automáticamente toma decisiones basadas en este conocimiento y las aportaciones humanas para seleccionar qué punto tendría sentido medir a continuación ".

En un caso simplista, esta próxima medición sería la ubicación en el espacio de parámetros donde se puede maximizar la ganancia de información (o reducir la incertidumbre). El equipo demostró por primera vez esta prueba de concepto en 2019 en la línea de luz NSLS-II CMS, Imágenes de una película de nanomateriales hecha específicamente para esta demostración.

Desde este éxito inicial, el equipo ha hecho que el algoritmo sea más sofisticado, aplicarlo para estudiar una amplia gama de problemas científicos reales (en lugar de artificiales) de varios grupos, y ampliarlo a técnicas e instalaciones más experimentales.

Si bien la versión predeterminada del algoritmo tiene como objetivo minimizar la incertidumbre o maximizar la ganancia de conocimiento de manera iterativa, hay otras formas de pensar dónde enfocar la atención experimental para obtener el mayor valor. Por ejemplo, para algunos científicos, el costo del experimento, ya sea su duración o la cantidad de materiales utilizados, es importante. En otras palabras, no es solo dónde tomas los datos pero como costoso es tomar esos datos. Otros pueden encontrar valor en concentrarse en características específicas, como los límites dentro de un espacio de parámetros o el tamaño de grano de un cristal. Cuanto más sofisticado, La versión flexible del algoritmo que desarrolló Noack puede programarse para tener una mayor sensibilidad a estas funciones.

"Puede ajustar cuáles son sus objetivos en el experimento, "explicó Yager." Entonces, puede ser ganancia de conocimiento, o ganancia de conocimiento regulada por el costo experimental o asociada con características específicas ".

Otras mejoras incluyen la capacidad del algoritmo para manejar la complejidad de los sistemas reales, como el hecho de que los materiales no son homogéneos, lo que significa que no son iguales en todos los puntos de una muestra. Una parte de una muestra puede tener una composición uniforme, mientras que otro puede tener una composición variable. Es más, el algoritmo ahora tiene en cuenta la anisotropía, o cómo los parámetros individuales pueden ser muy diferentes entre sí en términos de cómo afectan a un sistema. Por ejemplo, "x" e "y" son parámetros equivalentes (ambos son coordenadas posicionales) pero la temperatura y la presión no lo son.

"Los procesos gaussianos utilizan núcleos (funciones que describen cómo los puntos de datos dependen unos de otros en el espacio) para la interpolación, "dijo Noack." Los núcleos tienen todo tipo de propiedades matemáticas interesantes. Por ejemplo, pueden codificar diversos grados de falta de homogeneidad para una muestra ".

Aumentar la sofisticación del algoritmo es solo una parte del desafío. Luego, Fukuto y Yager tienen que integrar el algoritmo actualizado en el flujo de trabajo experimental automatizado de circuito cerrado y probarlo en diferentes experimentos, no solo los realizados internamente sino también los realizados por los usuarios.

Implementar el método en la comunidad científica en general

Recientemente, Fukuto, Yager, Noack, y sus colegas han implementado el método autónomo en varios experimentos reales en varias líneas de luz NSLS-II, incluyendo CMS y Soft Matter Interfaces (SMI). Noack y colaboradores también han implementado el método en Advanced Light Source (ALS) de LBNL y el Institut Laue-Langevin (ILL), una instalación de dispersión de neutrones en Francia. El equipo lanzó su software de toma de decisiones, gpCAM, a la comunidad científica en general para que cualquiera pueda establecer sus propios experimentos autónomos.

En un experimento, en colaboración con el Laboratorio de Investigación de la Fuerza Aérea de los Estados Unidos (AFRL), utilizaron el método en un experimento autónomo de dispersión de rayos X de sincrotrón en la línea de luz de CMS. En la dispersión de rayos X, los rayos X rebotan en una muestra en diferentes direcciones dependiendo de la estructura de la muestra. El primer objetivo del experimento fue explorar cómo la estructura ordenada de las películas compuestas de nanobarras y polímeros depende de dos parámetros de fabricación:la velocidad de recubrimiento de la película y el recubrimiento químico del sustrato. El segundo objetivo fue utilizar este conocimiento para ubicar y ubicar las regiones de las películas con el mayor grado de orden.

"Estos materiales son de interés para sensores y recubrimientos ópticos, ", explicó el científico de línea de luz de CMS, Ruipeng Li." Usamos un método de fabricación particular que imita los procesos industriales de rollo a rollo para encontrar la mejor manera de formar estas películas ordenadas utilizando procesos escalables industrialmente ".

En otro experimento de dispersión de rayos X, en la línea de luz de SMI, el algoritmo identificó con éxito regiones de ordenamiento inesperado en un espacio de parámetros relevante para el autoensamblaje de películas de copolímero de bloques. Los copolímeros de bloque son polímeros formados por dos o más "bloques" químicamente distintos unidos entre sí. Al identificar estas características, el experimento autónomo iluminó un problema con el método de fabricación.

"No era hipotético; hemos estado trabajando en este proyecto durante muchos años, ", dijo el científico de materiales CFN Gregory Doerk." Habíamos estado iterando a la antigua, haciendo algunos experimentos, tomar imágenes en lugares que elegimos arbitrariamente, mirando las imágenes, y estar desconcertado por lo que está pasando. Con el enfoque autónomo, en un día de experimentos en la línea de luz, pudimos encontrar los defectos y luego solucionarlos inmediatamente en la siguiente ronda. Esa es una aceleración dramática del ciclo normal de investigación en el que haces un estudio, descubrir que no funcionó, y vuelve a la mesa de dibujo ".

Noack y sus colaboradores también aplicaron el método a un tipo diferente de técnica de rayos X llamada mapeo infrarrojo sincrotrón autónomo. que puede proporcionar información química sobre una muestra. Y demostraron cómo el método podría aplicarse a una técnica de espectroscopia para descubrir de forma autónoma fases en las que los electrones se comportan de forma fuertemente correlacionada y a la dispersión de neutrones para medir de forma autónoma las correlaciones magnéticas.

Dar forma al futuro de la experimentación autónoma

Según Yager, su método se puede aplicar a cualquier técnica para la que la recopilación y el análisis de datos ya estén automatizados. Una de las ventajas del enfoque es que es "agnóstico a la física, "lo que significa que no está vinculado a ningún tipo de material en particular, problema físico, o técnica. Las cantidades físicamente significativas para la toma de decisiones se extraen mediante el análisis de los datos brutos.

"Queríamos que nuestro enfoque fuera muy general para que pudiera aplicarse a cualquier cosa y luego, en el futuro, adaptarse a problemas específicos". ", dijo Yager." Como una instalación de usuario, queremos capacitar al mayor número de personas para que hagan ciencia interesante ".

En el futuro, el equipo agregará funcionalidad para que los usuarios incorporen conciencia de la física, o conocimiento sobre los materiales o fenómenos que están estudiando, si lo desean. Pero el equipo lo hará de una manera que no destruya la flexibilidad de propósito general del enfoque; los usuarios podrán activar o desactivar este conocimiento adicional.

Otro aspecto del trabajo futuro es aplicar el método para controlar los procesos en tiempo real; en otras palabras, controlar un sistema que evoluciona dinámicamente en el tiempo a medida que avanza un experimento.

"Hasta este momento, nos hemos concentrado en tomar decisiones sobre cómo medir o caracterizar los sistemas de materiales preparados, ", dijo Fukuto." También queremos tomar decisiones sobre cómo cambiar los materiales o qué tipo de materiales queremos hacer. Comprender la ciencia fundamental detrás de los cambios materiales es importante para mejorar los procesos de fabricación ".

La realización de esta capacidad para explorar inteligentemente materiales que evolucionan en tiempo real requerirá superar desafíos algorítmicos y de instrumentación.

"La toma de decisiones tiene que ser muy rápida, y tiene que crear entornos de muestra para realizar síntesis de materiales en tiempo real mientras toma medidas con un haz de rayos X, "explicó Yager.

A pesar de estos desafíos, el equipo está entusiasmado con lo que depara el futuro de la experimentación autónoma.

"Comenzamos este esfuerzo a una escala muy pequeña, pero se convirtió en algo mucho más grande, "dijo Fukuto." Mucha gente está interesada en eso, no solo nosotros. La comunidad de usuarios se ha expandido, y con usuarios que estudian diferentes tipos de problemas, este enfoque podría tener un gran impacto en la aceleración de una serie de descubrimientos científicos ".

"Representa un gran cambio de pensamiento pasar de la antigua forma de microgestión de experimentos a esta nueva visión de sistemas automatizados que ejecutan experimentos con humanos orquestandolos a un nivel muy alto porque comprenden lo que se debe hacer y lo que significa la ciencia, ", dijo Yager." Esa es una visión muy emocionante para el futuro de la ciencia. Vamos a poder abordar problemas en el futuro que hace 10 años la gente hubiera dicho que son imposibles ".