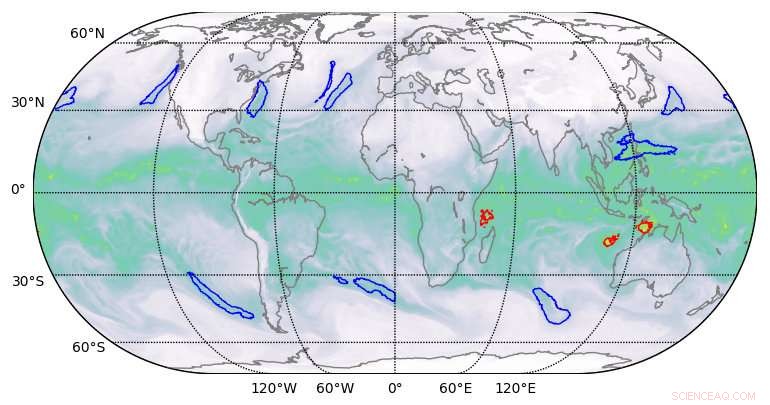

Resultados de segmentación de alta calidad producidos por aprendizaje profundo en conjuntos de datos climáticos. Crédito:Berkeley Lab

Un equipo de científicos computacionales del Laboratorio Nacional Lawrence Berkeley (Berkeley Lab) y del Laboratorio Nacional Oak Ridge (ORNL) e ingenieros de NVIDIA ha, por primera vez, demostró una aplicación de aprendizaje profundo de clase exaescala que ha roto la barrera exaop.

Usando un conjunto de datos climáticos de Berkeley Lab en el sistema Summit de ORNL en Oak Ridge Leadership Computing Facility (OLCF), entrenaron una red neuronal profunda para identificar patrones climáticos extremos a partir de simulaciones climáticas de alta resolución. Summit es una supercomputadora IBM Power Systems AC922 con más de 9 000 CPU IBM POWER9 y 27, 000 GPU NVIDIA Tesla V100 Tensor Core. Al aprovechar los núcleos tensoriales de NVIDIA especializados integrados en las GPU a escala, los investigadores lograron un rendimiento máximo de 1,13 exaops y un rendimiento sostenido de 0,999, el algoritmo de aprendizaje profundo más rápido informado hasta la fecha y un logro que les valió un lugar en la lista de finalistas de este año para el Premio Gordon Bell.

"Esta colaboración ha producido una serie de logros únicos, "dijo Prabhat, quien lidera el equipo de servicios de datos y análisis en el Centro Nacional de Computación Científica de Investigación Energética de Berkeley Lab y es coautor de la presentación de Gordon Bell. “Es el primer ejemplo de arquitectura de aprendizaje profundo que ha podido resolver problemas de segmentación en la ciencia del clima, y en el campo del aprendizaje profundo, es el primer ejemplo de una aplicación real que ha roto la barrera de la exaescala ".

Estos logros fueron posibles gracias a una combinación innovadora de capacidades de hardware y software. En el lado del hardware, Summit ha sido diseñado para ofrecer 200 petaflops de rendimiento informático de alta precisión y recientemente fue nombrada la computadora más rápida del mundo. capaz de realizar más de tres exaops (3 billones de billones de cálculos) por segundo. El sistema presenta una arquitectura híbrida; cada uno de sus 4, 608 nodos de cómputo contienen dos CPU IBM POWER9 y seis GPU NVIDIA Volta Tensor Core, todos conectados a través de la interconexión de alta velocidad NVIDIA NVLink.Las GPU NVIDIA son un factor clave en el rendimiento de Summit, permitiendo teraflops máximos hasta 12 veces más altos para el entrenamiento y teraflops máximos 6 veces más altos para la inferencia en aplicaciones de aprendizaje profundo en comparación con su predecesor, el Tesla P100.

"Nuestra asociación con Berkeley Lab y Oak Ridge National Laboratory demostró el verdadero potencial de las GPU NVIDIA Tensor Core para aplicaciones de IA y HPC, "dijo Michael Houston, Ingeniero senior distinguido de aprendizaje profundo en NVIDIA. "Para hacer realidad la exaescala, nuestro equipo aprovechó las capacidades de precisión múltiple incluidas en las miles de GPU NVIDIA Volta Tensor Core en Summit para lograr el máximo rendimiento en capacitación e inferencia en aplicaciones de aprendizaje profundo ".

Escalabilidad y comunicación mejoradas

En el lado del software, además de proporcionar el conjunto de datos climáticos, el equipo de Berkeley Lab desarrolló algoritmos de reconocimiento de patrones para entrenar la red neuronal DeepLabv3 + para extraer clasificaciones a nivel de píxeles de patrones climáticos extremos, lo que podría ayudar a predecir cómo están cambiando los fenómenos meteorológicos extremos a medida que el clima se calienta. Según Thorsten Kurth, un especialista en rendimiento de aplicaciones en NERSC que dirigió este proyecto, el equipo realizó modificaciones en DeepLabv3 + que mejoraron la escalabilidad de la red y las capacidades de comunicación e hicieron posible el logro exaops. Esto incluyó ajustar la red para entrenarla para extraer características a nivel de píxel y clasificación por píxel y mejorar la comunicación de nodo a nodo.

"Lo impresionante de este esfuerzo es que pudimos escalar un marco de alta productividad como TensorFlow, que está técnicamente diseñado para la creación rápida de prototipos en escalas pequeñas y medianas, para 4, 560 nodos en Summit, ", dijo." Con una serie de mejoras de rendimiento, pudimos hacer que el marco se ejecutara en casi toda la supercomputadora y lograr un rendimiento de nivel exacto, que hasta donde yo sé es el mejor logrado hasta ahora en una aplicación estrechamente acoplada ".

Otras innovaciones incluyeron la puesta en escena de datos paralelos de alta velocidad, una canalización de ingestión de datos optimizada y segmentación multicanal. Las tareas tradicionales de segmentación de imágenes funcionan con imágenes de tres canales rojo / azul / verde. Pero los conjuntos de datos científicos a menudo comprenden muchos canales; en el clima, por ejemplo, estos pueden incluir temperatura, velocidades del viento, valores de presión y humedad. Al ejecutar la red neuronal optimizada en Summit, las capacidades computacionales adicionales permitieron el uso de los 16 canales disponibles, lo que mejoró drásticamente la precisión de los modelos.

"Hemos demostrado que podemos aplicar métodos de aprendizaje profundo para la segmentación a nivel de píxeles en los datos climáticos, y potencialmente en otros dominios científicos, "dijo Prabhat." De manera más general, nuestro proyecto ha sentado las bases para el aprendizaje profundo de exaescala para la ciencia, así como aplicaciones comerciales ".