Un millón de procesos se asignan a los píxeles de un boceto en blanco y negro de 1000 × 1000 píxeles de Alan Turing. Los píxeles se encienden y apagan de acuerdo con los valores binarios instantáneos de los procesos. Crédito:Nature Communications

La "computación en memoria" o "memoria computacional" es un concepto emergente que utiliza las propiedades físicas de los dispositivos de memoria para almacenar y procesar información. Esto es contrario a los sistemas y dispositivos actuales de von Neumann, como computadoras de escritorio estándar, portátiles e incluso teléfonos móviles, que transportan datos de un lado a otro entre la memoria y la unidad de computación, haciéndolos más lentos y menos eficientes energéticamente.

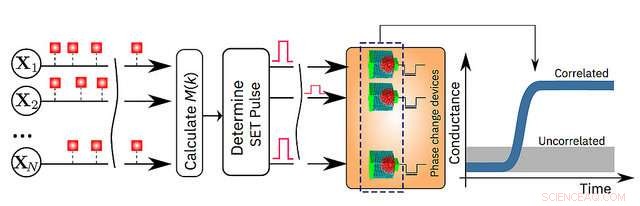

Hoy dia, IBM Research anuncia que sus científicos han demostrado que un algoritmo de aprendizaje automático no supervisado, funcionando en un millón de dispositivos de memoria de cambio de fase (PCM), encontró correlaciones temporales con éxito en flujos de datos desconocidos. En comparación con las computadoras clásicas de última generación, Se espera que este prototipo de tecnología produzca mejoras 200x en velocidad y eficiencia energética. lo que lo hace muy adecuado para permitir ultradenso, de baja potencia y sistemas de computación masivamente paralelos para aplicaciones en IA.

Los investigadores utilizaron dispositivos PCM hechos de una aleación de telururo de germanio y antimonio, que se apila y se intercala entre dos electrodos. Cuando los científicos aplican una pequeña corriente eléctrica al material, lo calientan, que altera su estado de amorfo (con una disposición atómica desordenada) a cristalino (con una configuración atómica ordenada). Los investigadores de IBM han utilizado la dinámica de cristalización para realizar cálculos en el lugar.

"Este es un importante paso adelante en nuestra investigación de la física de la IA, que explora nuevos materiales de hardware, dispositivos y arquitecturas, "dice el Dr. Evangelos Eleftheriou, miembro de IBM y coautor del artículo. "A medida que las leyes de escalamiento de CMOS se rompen debido a los límites tecnológicos, Se necesita una desviación radical de la dicotomía procesador-memoria para sortear las limitaciones de las computadoras actuales. Dada la sencillez, alta velocidad y baja energía de nuestro enfoque de computación en memoria, es notable que nuestros resultados sean tan similares a nuestro enfoque clásico de referencia ejecutado en una computadora von Neumann ".

Los detalles se explican en su artículo que aparece hoy en la revista de revisión por pares. Comunicaciones de la naturaleza . Para demostrar la tecnología, los autores eligieron dos ejemplos basados en el tiempo y compararon sus resultados con los métodos tradicionales de aprendizaje automático, como la agrupación en clústeres de k-medias:

"Hasta ahora, la memoria ha sido vista como un lugar donde simplemente almacenamos información. Pero en este trabajo, mostramos de manera concluyente cómo podemos explotar la física de estos dispositivos de memoria para realizar también una primitiva computacional de alto nivel. El resultado del cálculo también se almacena en los dispositivos de memoria, y en este sentido, el concepto está vagamente inspirado en cómo calcula el cerebro ", dijo el Dr. Abu Sebastian, científico exploratorio de memoria y tecnologías cognitivas, IBM Research y autor principal del artículo.

Una ilustración esquemática del algoritmo informático en memoria. Crédito:IBM Research