Cada sistema informático, biológico o sintético, desde las células hasta los cerebros y las computadoras portátiles, tiene un costo. No se trata del precio, que es fácil de discernir, sino del coste energético relacionado con el trabajo necesario para ejecutar un programa y el calor disipado en el proceso.

Los investigadores del Instituto Santa Fe y de otros lugares han pasado décadas desarrollando una teoría termodinámica de la computación, pero trabajos anteriores sobre el costo de la energía se han centrado en cálculos simbólicos básicos (como el borrado de un solo bit) que no son fácilmente transferibles a métodos menos predecibles. escenarios informáticos del mundo real.

En un artículo publicado en Physical Review X , un cuarteto de físicos e informáticos amplía la teoría moderna de la termodinámica de la computación. Combinando enfoques de la física estadística y la informática, los investigadores introducen ecuaciones matemáticas que revelan el coste energético mínimo y máximo previsto de los procesos computacionales que dependen de la aleatoriedad, que es una herramienta poderosa en las computadoras modernas.

En particular, el marco ofrece información sobre cómo calcular los límites de costos de energía en procesos computacionales con un final impredecible. Por ejemplo:a un simulador de lanzamiento de monedas se le puede indicar que deje de lanzar una moneda una vez que alcance 10 caras. En biología, una célula puede dejar de producir una proteína una vez que provoca una determinada reacción en otra célula. Los "tiempos de parada" de estos procesos, o el tiempo necesario para alcanzar el objetivo por primera vez, pueden variar de un ensayo a otro. El nuevo marco ofrece una forma sencilla de calcular los límites inferiores del coste energético de esas situaciones.

La investigación fue realizada por el profesor del SFI David Wolpert, Gonzalo Manzano (Instituto de Física Interdisciplinaria y Sistemas Complejos, España), Édgar Roldán (Instituto de Física Teórica, Italia) y la becaria graduada del SFI Gülce Kardes (CU Boulder). El estudio descubre una forma de reducir los costes energéticos de los procesos computacionales arbitrarios. Por ejemplo:un algoritmo que busca el nombre o apellido de una persona en una base de datos podría dejar de ejecutarse si encuentra cualquiera de los dos, pero no sabemos cuál encontró.

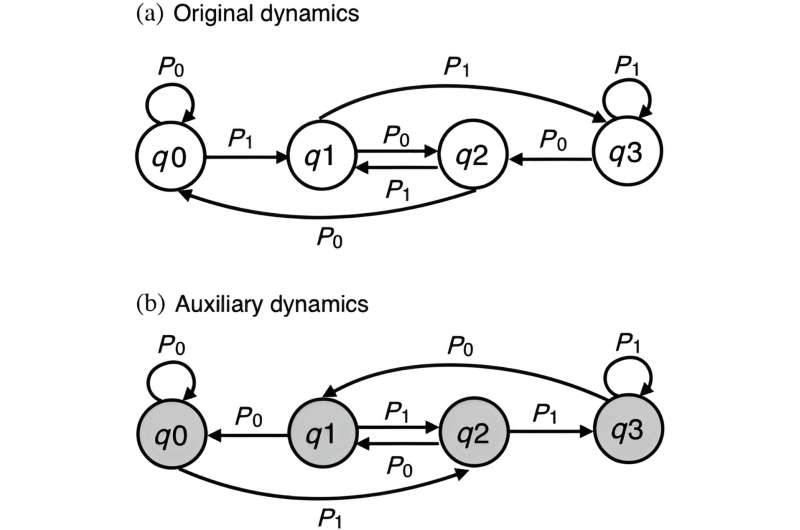

"Muchas máquinas computacionales, vistas como sistemas dinámicos, tienen la propiedad de que, si saltas de un estado a otro, no puedes volver al estado original en un solo paso", dice Kardes.

Wolpert comenzó a investigar formas de aplicar ideas de la física estadística del desequilibrio a la teoría de la computación hace aproximadamente una década. Las computadoras, dice, son un sistema fuera de equilibrio, y la termodinámica estocástica ofrece a los físicos una manera de estudiar los sistemas en desequilibrio. "Si juntabas esos dos, parecía que saldrían todo tipo de fuegos artificiales, con un espíritu tipo SFI", dice.

En estudios recientes que sentaron las bases para este nuevo artículo, Wolpert y sus colegas introdujeron la idea de un "costo de desajuste", o una medida de cuánto excede el costo de un cálculo el límite de Landauer. Propuesto en 1961 por el físico Rolf Landauer, este límite define la cantidad mínima de calor necesaria para cambiar la información en una computadora. Conocer el costo de la discordancia, dice Wolpert, podría informar estrategias para reducir el costo energético general de un sistema.

Al otro lado del Atlántico, los coautores Manzano y Roldán han estado desarrollando una herramienta a partir de las matemáticas de las finanzas (la teoría de la martingala) para abordar el comportamiento termodinámico de pequeños sistemas fluctuantes en los momentos de parada. Roldán et. "Martingalas para físicos" de al. ha ayudado a allanar el camino hacia aplicaciones exitosas de este enfoque de martingala en termodinámica.

Wolpert, Kardes, Roldán y Manzano extienden estas herramientas desde la termodinámica estocástica al cálculo de un coste de desajuste a problemas computacionales comunes en su PRX papel.

En conjunto, su investigación apunta a una nueva vía para encontrar la energía más baja necesaria para la computación en cualquier sistema, sin importar cómo se implemente. "Está exponiendo un nuevo y enorme conjunto de problemas", afirma Wolpert.

También puede tener una aplicación muy práctica, al señalar nuevas formas de hacer que la informática sea más eficiente desde el punto de vista energético. La Fundación Nacional de Ciencias estima que las computadoras utilizan entre el 5% y el 9% de la energía generada globalmente, pero con las tasas de crecimiento actuales, esa cifra podría alcanzar el 20% para 2030.

Pero trabajos anteriores de investigadores del SFI sugieren que las computadoras modernas son tremendamente ineficientes:los sistemas biológicos, por el contrario, son aproximadamente 100.000 veces más eficientes energéticamente que las computadoras construidas por humanos. Wolpert dice que una de las principales motivaciones para una teoría termodinámica general de la computación es encontrar nuevas formas de reducir el consumo de energía de las máquinas del mundo real.

Por ejemplo, una mejor comprensión de cómo los algoritmos y los dispositivos utilizan la energía para realizar determinadas tareas podría apuntar a arquitecturas de chips informáticos más eficientes. En este momento, afirma Wolpert, no existe una forma clara de fabricar chips físicos que puedan realizar tareas computacionales utilizando menos energía.

"Este tipo de técnicas podrían proporcionar una linterna en la oscuridad", afirma.

Más información: Gonzalo Manzano et al, Termodinámica de cálculos con irreversibilidad absoluta, transiciones unidireccionales y tiempos de cálculo estocástico, Physical Review X (2024). DOI:10.1103/PhysRevX.14.021026

Información de la revista: Revisión física X

Proporcionado por Instituto Santa Fe