Los filamentos propuestos de materia oscura que rodean a Júpiter podrían ser parte del misterioso 95 por ciento de la masa-energía del universo. Crédito:NASA / JPL-Caltech

La mayor parte del universo es oscuro con materia oscura y energía oscura que comprenden más del 95 por ciento de su masa-energía. Sin embargo, sabemos poco sobre la materia oscura y la energía. Para encontrar respuestas los científicos llevan a cabo enormes experimentos de física de alta energía. El análisis de los resultados exige una informática de alto rendimiento, a veces equilibrada con las tendencias industriales.

Después de cuatro años de ejecutar la informática para el experimento CMS del Gran Colisionador de Hadrones en el CERN cerca de Ginebra, Suiza - parte del trabajo que reveló el bosón de Higgs - Oliver Gutsche, un científico del Laboratorio Nacional Acelerador Fermi del Departamento de Energía (DOE), se volvió hacia la búsqueda de materia oscura. "Se había predicho el bosón de Higgs, y sabíamos aproximadamente dónde buscar, ", dice." Con materia oscura, no sabemos lo que estamos buscando ".

Para aprender sobre la materia oscura, Gutsche necesita más datos. Una vez que esa información esté disponible, los físicos deben extraerlo. Están explorando herramientas computacionales para el trabajo, incluido el software de código abierto Apache Spark.

En la búsqueda de materia oscura Los físicos estudian los resultados de la colisión de partículas. "Es trivial paralelizarlo, "dividir el trabajo en pedazos para obtener respuestas más rápido, Explica Gutsche. "Dos PC pueden procesar una colisión cada una, "lo que significa que los investigadores pueden emplear una cuadrícula de computadora para analizar datos.

Gran parte del trabajo en física de altas energías, aunque, depende del software que desarrollan los científicos. "Si nuestros estudiantes de posgrado y posdoctorado solo conocen nuestras herramientas patentadas, entonces tendrán problemas si se dedican a la industria, "cuando dicho software no esté disponible, Notas de Gutsche. "Así que comencé a buscar en Spark".

Spark es una herramienta de reducción de datos creada para archivos de texto no estructurados. Eso crea un desafío:acceder a los datos de física de alta energía, que están en un formato orientado a objetos. Los investigadores de ciencias de la computación del Fermilab, Saba Sehrish y Jim Kowalkowski, están abordando la tarea.

Spark ofreció una promesa desde el principio, con algunas características particularmente interesantes, Dice Sehrish. "Uno estaba en memoria, procesamiento distribuido a gran escala "a través de interfaces de alto nivel, lo que lo hace fácil de usar. "No quiere que los científicos se preocupen por cómo distribuir datos y escribir código paralelo, "ella dice. Spark se encarga de eso.

Otra característica atractiva:Spark es una plataforma de investigación respaldada en el Centro Nacional de Computación Científica de Investigación Energética (NERSC), una instalación para usuarios de la Oficina de Ciencias del DOE en el Laboratorio Nacional Lawrence Berkeley del DOE. "Esto nos brinda un equipo de soporte que puede ajustarlo, ", Dice Kowalkowski. Los informáticos como Sehrish y Kowalkowski pueden agregar capacidades, pero hacer que el código subyacente funcione de la manera más eficiente posible requiere especialistas de Spark, algunos de los cuales trabajan en NERSC.

Kowalkowski resume las características deseables de Spark como "escalado automatizado, paralelismo automatizado y un modelo de programación razonable ".

En breve, Él y Sehrish quieren construir un sistema que permita a los investigadores ejecutar un análisis que funcione extremadamente bien en máquinas a gran escala sin complicaciones y a través de una interfaz de usuario sencilla.

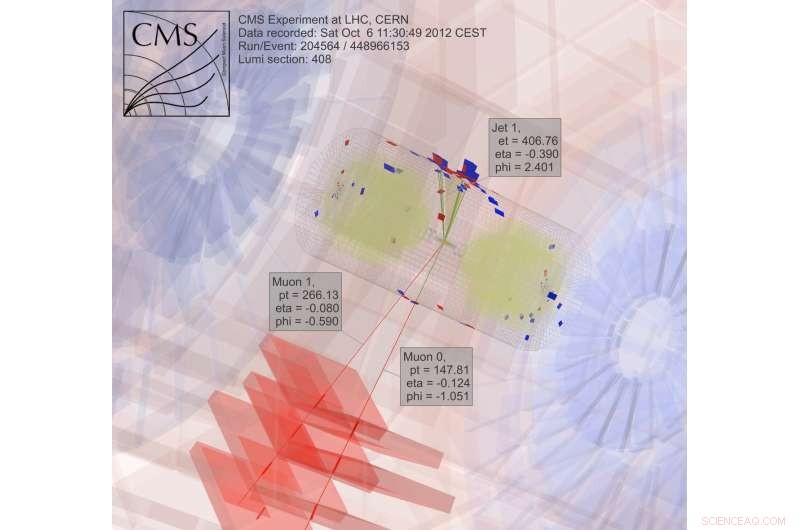

Para buscar materia oscura, los científicos recopilan y analizan los resultados de la colisión de partículas, un proceso extremadamente intenso computacionalmente. Crédito:CMS CERN

Simplemente siendo fácil de usar, aunque, no es suficiente cuando se trata de datos de la física de altas energías. Spark parece satisfacer los objetivos de rendimiento y facilidad de uso hasta cierto punto. Los investigadores todavía están investigando algunos aspectos de su rendimiento para aplicaciones de física de alta energía, pero los informáticos no pueden tenerlo todo. "Hay un compromiso, "Dice Sehrish." Cuando buscas más rendimiento, no es fácil de usar ".

Los científicos de Fermilab seleccionaron Spark como una opción inicial para explorar la ciencia de big data, y la materia oscura es solo la primera aplicación que se está probando. "Necesitamos varios casos de uso real para comprender la viabilidad de usar Spark para una tarea de análisis, "Dice Sehrish. Con científicos como Gutsche en Fermilab, la materia oscura era un buen punto de partida. Sehrish y Kowalkowski quieren simplificar la vida de los científicos que realizan el análisis. "Trabajamos con científicos para comprender sus datos y trabajar con su análisis, ", Dice Sehrish." Entonces podemos ayudarlos a organizar mejor los conjuntos de datos, organizar mejor las tareas de análisis ".

Como primer paso en ese proceso, Sehrish y Kowalkowski deben obtener datos de experimentos de física de alta energía en Spark. Notas Kowalkowski, "Tienes petabytes de datos en formatos experimentales específicos que tienes que convertir en algo útil para otra plataforma".

Los datos iniciales para la implementación de la materia oscura están formateados para plataformas informáticas de alto rendimiento, pero Spark no maneja esa configuración. Por lo tanto, el software debe leer el formato de datos original y convertirlo en algo que funcione bien con Spark.

Al hacer esto, Sehrish explica, "tienes que considerar cada decisión en cada paso, porque cómo se estructuran los datos, cómo se lee en la memoria y cómo se diseñan e implementan las operaciones para lograr un alto rendimiento, todo está vinculado ".

Cada uno de esos pasos de manejo de datos afecta el rendimiento de Spark. Aunque es demasiado pronto para saber cuánto rendimiento se puede extraer de Spark al analizar datos de materia oscura, Sehrish y Kowalkowski ven que Spark puede proporcionar un código fácil de usar que permite a los investigadores de física de alta energía lanzar un trabajo en cientos de miles de núcleos. "Spark es bueno en ese sentido, "Dice Sehrish." También hemos visto un buen escalado, sin desperdiciar recursos informáticos a medida que aumentamos el tamaño del conjunto de datos y la cantidad de nodos ".

Nadie sabe si este será un enfoque viable hasta que se determine el rendimiento máximo de Spark para estas aplicaciones. "La clave principal, "Kowalkowski dice, Es que aún no estamos convencidos de que esta sea la tecnología para seguir adelante ”.

De hecho, Spark en sí cambia. Su amplio uso de código abierto crea un ciclo de desarrollo rápido y constante. Por lo tanto, Sehrish y Kowalkowski deben mantener su código actualizado con las nuevas capacidades de Spark.

"El ciclo constante de crecimiento con Spark es el costo de trabajar con tecnología de alta gama y algo con muchos intereses de desarrollo, "Dice Sehrish.

Podrían pasar algunos años antes de que Sehrish y Kowalkowski tomen una decisión sobre Spark. Convertir el software creado para la informática de alto rendimiento en buenas herramientas informáticas de alto rendimiento que sean fáciles de usar requiere un ajuste fino y trabajo en equipo entre científicos experimentales y computacionales. O, tu podrias decir, se necesita más que un disparo en la oscuridad.