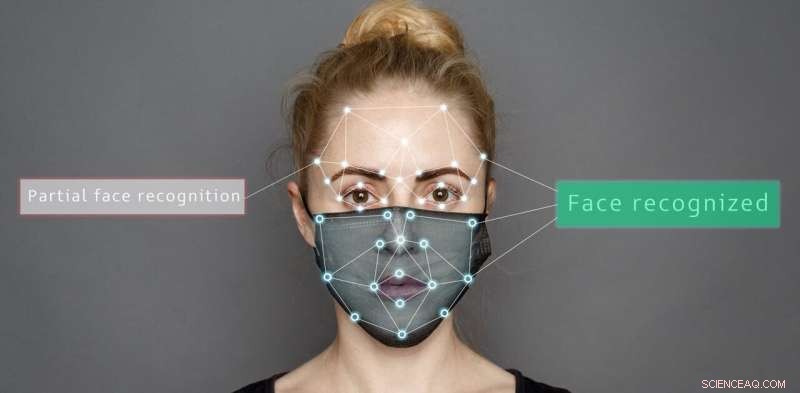

Crédito:Shutterstock/Sergey Tinyakov

Los sistemas artificiales, como los robots de atención domiciliaria o la tecnología de asistencia al conductor, se están volviendo más comunes, y es oportuno investigar si las personas o los algoritmos son mejores para leer las emociones, particularmente dado el desafío adicional que implica cubrirse la cara.

En nuestro estudio reciente, comparamos cómo las máscaras faciales o las gafas de sol afectan nuestra capacidad para determinar diferentes emociones en comparación con la precisión de los sistemas artificiales.

Presentamos imágenes de expresiones faciales emocionales y agregamos dos tipos diferentes de máscaras:la máscara completa utilizada por los trabajadores de primera línea y una máscara introducida recientemente con una ventana transparente para permitir la lectura de labios.

Nuestros hallazgos muestran que tanto los algoritmos como las personas luchan cuando los rostros están parcialmente oscurecidos. Pero es más probable que los sistemas artificiales malinterpreten las emociones de maneras inusuales.

Los sistemas artificiales se desempeñaron significativamente mejor que las personas en el reconocimiento de emociones cuando la cara no estaba cubierta:98,48 % en comparación con 82,72 % para siete tipos diferentes de emoción.

Pero según el tipo de cobertura, la precisión tanto para las personas como para los sistemas artificiales variaba. Por ejemplo, las gafas de sol oscurecieron el miedo de las personas, mientras que las máscaras parciales ayudaron tanto a las personas como a los sistemas artificiales a identificar correctamente la felicidad.

Es importante destacar que las personas clasificaron las expresiones desconocidas principalmente como neutrales, pero los sistemas artificiales fueron menos sistemáticos. A menudo seleccionaron incorrectamente la ira para las imágenes oscurecidas con una máscara completa y la ira, la felicidad, neutral o sorpresa para las expresiones parcialmente enmascaradas.

El estudio usó máscaras completas y parciales y gafas de sol para oscurecer partes de la cara. Proporcionado por el autor

Decodificación de expresiones faciales

Nuestra capacidad de reconocer las emociones utiliza el sistema visual del cerebro para interpretar lo que vemos. Incluso tenemos un área del cerebro especializada en el reconocimiento facial, conocida como área facial fusiforme, que ayuda a interpretar la información revelada por los rostros de las personas.

Junto con el contexto de una situación particular (interacción social, habla y movimiento corporal) y nuestra comprensión de los comportamientos pasados y la simpatía hacia nuestros propios sentimientos, podemos decodificar cómo se sienten las personas.

Se ha propuesto un sistema de unidades de acción facial para decodificar emociones basadas en señales faciales. Incluye unidades como "la mejilla levantada" y "la comisura de los labios", que se consideran parte de una expresión de felicidad.

Por el contrario, los sistemas artificiales analizan los píxeles de las imágenes de un rostro al categorizar las emociones. Pasan valores de intensidad de píxeles a través de una red de filtros que imitan el sistema visual humano.

El hallazgo de que los sistemas artificiales clasifican erróneamente las emociones de rostros parcialmente oscurecidos es importante. Podría dar lugar a comportamientos inesperados de los robots que interactúan con personas que usan mascarillas.

Imagínese si clasifican erróneamente una emoción negativa, como la ira o la tristeza, como una expresión emocional positiva. Los sistemas artificiales tratarían de interactuar con una persona tomando acciones sobre la interpretación equivocada de que son felices. Esto podría tener efectos perjudiciales para la seguridad de estos sistemas artificiales y los seres humanos que interactúan.

¿Puedes leer la emoción de los investigadores en sus rostros cubiertos? Tanto los sistemas artificiales como las personas se ven comprometidos a la hora de categorizar las emociones cuando los rostros están oscurecidos. Proporcionado por el autor

Riesgos de usar algoritmos para leer emociones

Nuestra investigación reitera que los algoritmos son susceptibles a sesgos en su juicio. Por ejemplo, el rendimiento de los sistemas artificiales se ve muy afectado cuando se trata de categorizar la emoción de las imágenes naturales. Incluso el ángulo o la sombra del sol pueden influir en los resultados.

Los algoritmos también pueden tener prejuicios raciales. Como han encontrado estudios anteriores, incluso un pequeño cambio en el color de la imagen, que no tiene nada que ver con las expresiones emocionales, puede provocar una caída en el rendimiento de los algoritmos utilizados en los sistemas artificiales.

Como si eso no fuera suficiente problema, incluso las pequeñas perturbaciones visuales, imperceptibles para el ojo humano, pueden hacer que estos sistemas identifiquen erróneamente una entrada como otra cosa.

Algunos de estos problemas de clasificación errónea se pueden abordar. Por ejemplo, se pueden diseñar algoritmos para considerar características relacionadas con las emociones, como la forma de la boca, en lugar de obtener información del color y la intensidad de los píxeles.

Otra forma de abordar esto es cambiando las características de los datos de entrenamiento:sobremuestrear los datos de entrenamiento para que los algoritmos imiten mejor el comportamiento humano y cometan errores menos extremos cuando clasifican incorrectamente una expresión.

Pero, en general, el rendimiento de estos sistemas disminuye al interpretar imágenes en situaciones del mundo real cuando los rostros están parcialmente cubiertos.

Aunque los robots pueden reclamar una precisión superior a la humana en el reconocimiento de emociones para imágenes estáticas de rostros completamente visibles, en situaciones del mundo real que experimentamos todos los días, su desempeño aún no es como el humano.