Un robot y un ser humano interactuando. Crédito:Tommy Ton, tontommy.com, CC BY-ND

La inteligencia artificial está entrando en nuestras vidas de muchas formas:en nuestros teléfonos inteligentes, en nuestras casas, en nuestros coches. Estos sistemas pueden ayudar a las personas a concertar citas, conducir e incluso diagnosticar enfermedades. Pero a medida que los sistemas de inteligencia artificial continúan desempeñando funciones importantes y colaborativas en la vida de las personas, una pregunta natural es:¿puedo confiar en ellos? ¿Cómo sé que harán lo que espero?

La IA explicable (XAI) es una rama de la investigación de la IA que examina cómo los agentes artificiales pueden volverse más transparentes y confiables para sus usuarios humanos. La confiabilidad es esencial para que los robots y las personas trabajen juntos. XAI busca desarrollar sistemas de inteligencia artificial que los seres humanos consideren confiables, al mismo tiempo que funcionan bien para cumplir con las tareas diseñadas.

En el Center for Vision, Cognición, Aprendiendo, y autonomía en UCLA, nosotros y nuestros colegas estamos interesados en qué factores hacen que las máquinas sean más confiables, y qué tan bien los diferentes algoritmos de aprendizaje permiten la confianza. Nuestro laboratorio utiliza un tipo de representación del conocimiento, un modelo del mundo que utiliza una IA para interpretar su entorno y tomar decisiones, que los humanos pueden comprender más fácilmente. Esto, naturalmente, ayuda en la explicación y la transparencia, mejorando así la confianza de los usuarios humanos.

En nuestra última investigación, experimentamos con diferentes formas en que un robot podría explicar sus acciones a un observador humano. Curiosamente, las formas de explicación que fomentaban la mayor confianza humana no correspondían a los algoritmos de aprendizaje que producían el mejor desempeño de la tarea. Esto sugiere que el rendimiento y la explicación no dependen de forma inherente el uno del otro; la optimización para uno solo puede no conducir al mejor resultado para el otro. Esta divergencia requiere diseños de robots que tengan en cuenta tanto el buen desempeño de las tareas como las explicaciones confiables.

Robots de enseñanza

Al realizar este estudio, nuestro grupo estaba interesado en dos cosas. ¿Cómo aprende mejor un robot a realizar una tarea en particular? Luego, ¿Cómo responde la gente a la explicación del robot de sus acciones?

Le enseñamos a un robot a aprender de las demostraciones humanas cómo abrir un frasco de medicina con un candado de seguridad. Una persona llevaba un guante táctil que registraba las poses y fuerzas de la mano humana al abrir la botella. Esa información ayudó al robot a aprender lo que hacía el humano de dos formas:simbólica y háptica. Simbólico se refiere a representaciones significativas de sus acciones:por ejemplo, la palabra "agarrar". Háptico se refiere a los sentimientos asociados con las posturas y movimientos de su cuerpo:por ejemplo, la sensación de tus dedos cerrándose juntos.

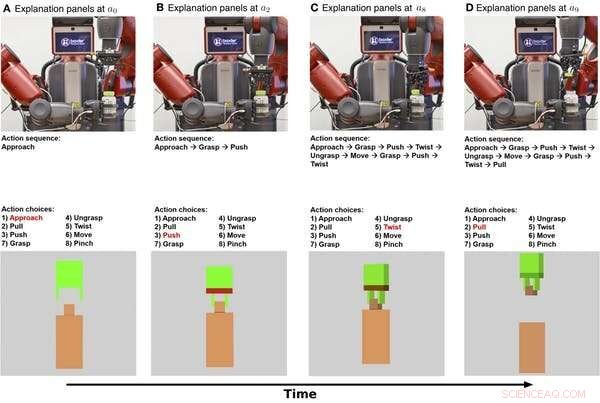

Explicaciones simbólicas y hápticas de un robot abriendo un frasco de medicina mostradas a lo largo del tiempo. La fila superior son imágenes fijas de un video del robot realizando la tarea. La fila del medio muestra una explicación simbólica de la tarea. La fila inferior muestra una explicación háptica. Crédito:Edmonds et al., Sci. Robot. 4, eaay4663 (2019)

Primero, el robot aprendió un modelo simbólico que codifica la secuencia de pasos necesarios para completar la tarea de abrir la botella. Segundo, el robot aprendió un modelo háptico que permite al robot "imaginarse" a sí mismo en el papel del demostrador humano y predecir qué acción tomaría una persona al encontrar poses y fuerzas particulares.

Resulta que el robot pudo lograr su mejor rendimiento al combinar los componentes simbólico y háptico. El robot lo hizo mejor usando el conocimiento de los pasos para realizar la tarea y la detección en tiempo real de su pinza que usando cualquiera de ellos solo.

Ganar la confianza humana

Ahora que el robot sabe qué hacer, ¿Cómo puede explicar su comportamiento a una persona? ¿Y qué tan bien fomenta esa explicación la confianza humana?

Para explicar sus acciones, el robot puede basarse en su proceso de decisión interno así como en su comportamiento. El modelo simbólico proporciona descripciones paso a paso de las acciones del robot, y el modelo háptico proporciona una sensación de lo que la pinza del robot está "sintiendo".

En nuestro experimento, agregamos una explicación adicional para los humanos:un texto escrito que proporciona un resumen después de que el robot ha terminado de intentar abrir el frasco de la medicina. Queríamos ver si las descripciones resumidas serían tan efectivas como la explicación simbólica paso a paso para ganarnos la confianza humana.

Le preguntamos a 150 participantes humanos, dividido en cuatro grupos, para observar cómo el robot intenta abrir el frasco del medicamento. Luego, el robot dio a cada grupo una explicación diferente de la tarea:simbólica, paso a paso, háptico:posiciones y movimientos de los brazos, resumen de texto, o simbólico y háptico juntos. Un grupo de referencia observó solo un video del robot intentando abrir la botella, sin proporcionar explicaciones adicionales.

Descubrimos que proporcionar explicaciones tanto simbólicas como hápticas fomentaba la mayor confianza, con el componente simbólico contribuyendo más. Curiosamente, la explicación en forma de resumen de texto no generó más confianza que simplemente ver al robot realizar la tarea, lo que indica que los humanos prefieren que los robots den explicaciones paso a paso de lo que están haciendo.

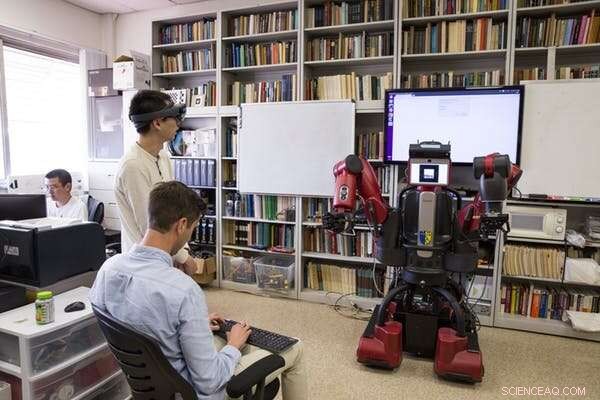

Los investigadores de UCLA prueban un robot después de que ha aprendido a abrir un frasco de medicina observando a manifestantes humanos. Crédito:Escuela de Ingeniería Samueli de UCLA, CC BY-ND

Diseñar tanto para el rendimiento como para la confianza

El resultado más interesante de esta investigación es que lo que hace que los robots funcionen bien no es lo mismo que lo que hace que las personas los vean como dignos de confianza. El robot necesitaba componentes tanto simbólicos como hápticos para hacer el mejor trabajo. Pero fue la explicación simbólica la que hizo que la gente confiara más en el robot.

Esta divergencia destaca objetivos importantes para la investigación futura de IA y robótica:centrarse en perseguir tanto el rendimiento de la tarea como la explicabilidad. Es posible que centrarse únicamente en el desempeño de la tarea no lleve a un robot que se explique bien. Nuestro laboratorio utiliza un modelo híbrido para proporcionar explicaciones fiables y de alto rendimiento.

El rendimiento y la explicación no se complementan naturalmente, por lo que ambos objetivos deben ser una prioridad desde el principio al construir sistemas de IA. Este trabajo representa un paso importante en el estudio sistemático de cómo se desarrollan las relaciones hombre-máquina, pero queda mucho por hacer. Un paso desafiante para la investigación futura será pasar de "Confío en el robot para hacer X" a "Confío en el robot".

Para que los robots se ganen un lugar en la vida diaria de las personas, los humanos necesitan confiar en sus homólogos robóticos. Comprender cómo los robots pueden proporcionar explicaciones que fomenten la confianza humana es un paso importante para permitir que los humanos y los robots trabajen juntos.

Este artículo se vuelve a publicar de The Conversation bajo una licencia Creative Commons. Lea el artículo original.