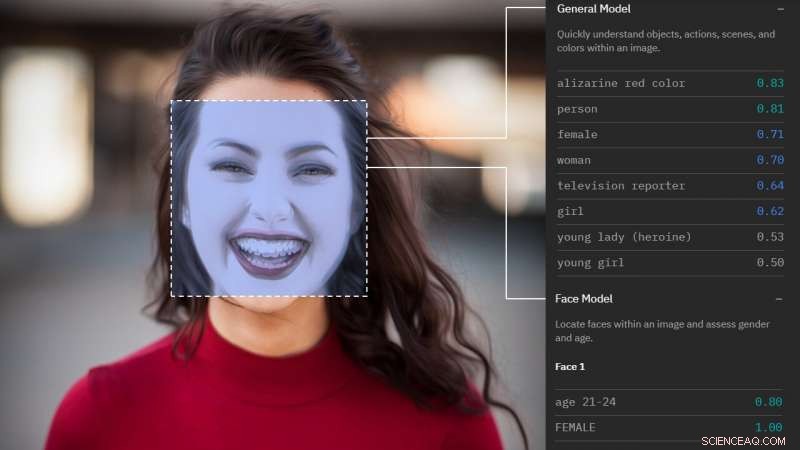

Cómo te ve el análisis facial. Crédito:Morgan Klaus Scheuerman / CU Boulder

Con una breve mirada a un solo rostro, El software de reconocimiento facial emergente ahora puede categorizar el género de muchos hombres y mujeres con una precisión notable.

Pero si ese rostro pertenece a una persona transgénero, tales sistemas se equivocan más de un tercio de las veces, según una nueva investigación de la Universidad de Colorado en Boulder.

"Descubrimos que los servicios de análisis facial se desempeñaban constantemente peor en personas transgénero, y fueron universalmente incapaces de clasificar géneros no binarios, "dijo el autor principal Morgan Klaus Scheuerman, un doctorado estudiante en el departamento de Ciencias de la Información. "Si bien hay muchos tipos diferentes de personas, estos sistemas tienen una visión extremadamente limitada de cómo se ve el género ".

El estudio llega en un momento en que las tecnologías de análisis facial, que utilizan cámaras ocultas para evaluar y caracterizar ciertas características de un individuo, se están volviendo cada vez más frecuentes. integrado en todo, desde aplicaciones de citas para teléfonos inteligentes y quioscos digitales en centros comerciales hasta seguridad aeroportuaria y sistemas de vigilancia policial.

Investigaciones anteriores sugieren que tienden a ser más precisos al evaluar el género de los hombres blancos, pero identifica erróneamente a las mujeres de color hasta un tercio de las veces.

"Sabíamos que había prejuicios inherentes en estos sistemas en torno a la raza y la etnia y sospechamos que también habría problemas en torno al género, "dijo el autor principal Jed Brubaker, profesor asistente de Ciencias de la Información. "Nos propusimos probar esto en el mundo real".

Los investigadores recolectaron 2, 450 imágenes de rostros de Instagram, cada uno de los cuales había sido etiquetado por su propietario con un hashtag que indicaba su identidad de género. Luego, las imágenes se dividieron en siete grupos de 350 imágenes (#mujeres, #hombre, #transmujer, #transman, #agente, #agenderqueer, #nonbinary) y analizado por cuatro de los mayores proveedores de servicios de análisis facial (IBM, Amazonas, Microsoft y Clarifai).

Notablemente, Google no se incluyó porque no ofrece servicios de reconocimiento de género.

De media, los sistemas fueron más precisos con fotos de mujeres cisgénero (nacidas como mujeres y que se identificaron como mujeres), acertar en su género el 98,3% de las veces. Clasificaron a los hombres cisgénero con precisión el 97,6% de las veces.

Pero los hombres trans fueron identificados erróneamente como mujeres hasta el 38% de las veces.

Y aquellos que se identificaron como agender, géneroqueer o no binario, lo que indica que no se identifican ni como hombre ni como mujer, se caracterizaron erróneamente el 100 por ciento de las veces.

"Estos sistemas no conocen ningún otro idioma que no sea masculino o femenino, por lo que para muchas identidades de género no es posible que sean correctas, "dice Brubaker.

El estudio también sugiere que dichos servicios identifican el género basándose en estereotipos obsoletos.

Cuando Scheuerman, que es varón y tiene el pelo largo, envió su propia foto, la mitad lo categorizó como mujer.

Los investigadores no pudieron acceder a los datos de entrenamiento, o entradas de imágenes que se utilizan para "enseñar" al sistema cómo lucen hombres y mujeres, pero investigaciones anteriores sugieren que evalúan aspectos como la posición de los ojos, plenitud de labios, la longitud del cabello e incluso la ropa.

"Estos sistemas corren el riesgo de reforzar los estereotipos de cómo debes lucir si quieres que te reconozcan como hombre o como mujer. Y eso impacta a todos, "dijo Scheuerman.

Cuando el investigador Morgan Klaus Scheuerman, quien es un hombre, envió su foto a varios servicios de análisis facial, la mitad entendió mal su género. Crédito:Morgan Klaus Scheuerman / CU Boulder

Se prevé que el mercado de servicios de reconocimiento facial se duplique para 2024, a medida que los desarrolladores de tecnología trabajan para mejorar la interacción entre humanos y robots y orientar más cuidadosamente los anuncios a los compradores. Ya, Brubaker señala, las personas se involucran con la tecnología de reconocimiento facial todos los días para obtener acceso a sus teléfonos inteligentes o iniciar sesión en sus computadoras.

Si tiene una tendencia a confundir ciertos, ya vulnerable, poblaciones que podrían tener graves consecuencias.

Por ejemplo, una aplicación de emparejamiento podría concertar una cita con alguien del sexo incorrecto, conduciendo a una situación potencialmente peligrosa. O una discrepancia entre el género que ve un programa de reconocimiento facial y la documentación que lleva una persona podría generar problemas para pasar por la seguridad del aeropuerto. dice Scheuerman.

Lo que más le preocupa es que tales sistemas reafirmen nociones en las que las personas transgénero no encajan.

"La gente piensa en la visión por computadora como algo futurista, pero hay muchas personas que podrían quedar fuera de este supuesto futuro, " él dijo.

Los autores dicen que les gustaría que las empresas de tecnología se alejaran por completo de la clasificación de género y se apegaran a etiquetas más específicas como "cabello largo" o "maquillaje" al evaluar las imágenes.

"Cuando caminas por la calle, puedes mirar a alguien y suponer que sabes cuál es su género, pero esa es una idea realmente curiosa de los 90 y ya no es como es el mundo, ", dijo Brubaker." A medida que nuestra visión y nuestra comprensión cultural de lo que es el género ha evolucionado. Los algoritmos que impulsan nuestro futuro tecnológico no lo han hecho. Eso es profundamente problemático ".

La investigación se presentará en noviembre en la Conferencia ACM sobre trabajo cooperativo asistido por computadora en Austin, Texas.