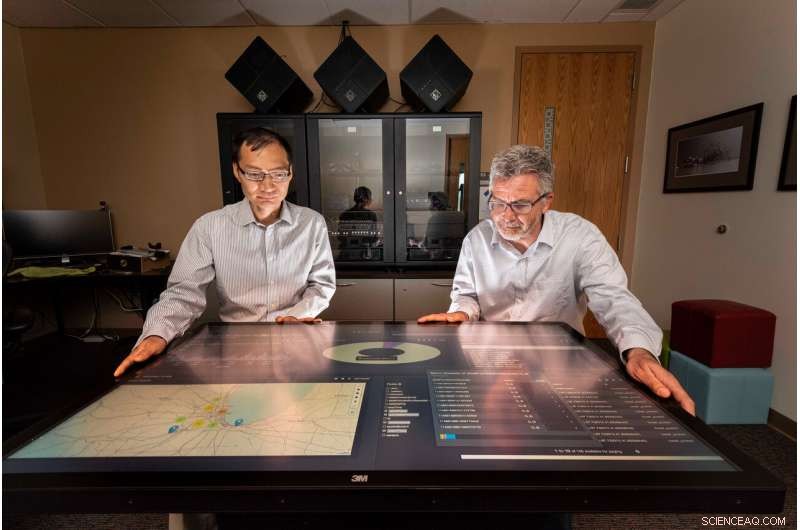

Los científicos informáticos de Sandia National Laboratories Tian Ma, izquierda, y Rudy García, dirigió un proyecto para entregar información procesable a partir de datos en tiempo real casi en tiempo real. Crédito:Randy Montoya

Medios de comunicación social, cámaras, sensores y más generan enormes cantidades de datos que pueden abrumar a los analistas que lo revisan todo en busca de información significativa, información procesable para proporcionar a los responsables de la toma de decisiones, como líderes políticos y comandantes de campo, la respuesta a las amenazas a la seguridad.

Los investigadores de Sandia National Laboratories están trabajando para reducir esa carga mediante el desarrollo de la ciencia para recopilar conocimientos a partir de datos casi en tiempo real.

"La cantidad de datos producidos por los sensores y las redes sociales está en auge:todos los días se generan alrededor de 2,5 quintillones (o 2,5 mil millones) de bytes de datos, "dijo Tian Ma, un científico informático de Sandia y codirector del proyecto. "Aproximadamente el 90% de todos los datos se han generado en los últimos dos años; hay más datos de los que tenemos personas para analizar. Las comunidades de inteligencia están básicamente abrumadas, y el problema es que termina con una gran cantidad de datos almacenados en discos que podrían pasarse por alto ".

Los investigadores de Sandia trabajaron con estudiantes de la Universidad de Illinois Urbana-Champaign, un socio de Academic Alliance, para desarrollar algoritmos analíticos y de toma de decisiones para la transmisión de fuentes de datos e integrarlos en un marco de procesamiento de datos distribuidos casi en tiempo real utilizando herramientas de big data y recursos informáticos en Sandia. El marco toma datos dispares de múltiples fuentes y genera información utilizable sobre la que se puede actuar casi en tiempo real.

Para probar el marco, los investigadores y los estudiantes utilizaron datos de tráfico de Chicago, como imágenes, sensores integrados, tweets y transmisión de texto para medir con éxito la congestión del tráfico y sugerir rutas de conducción más rápidas a su alrededor para un viajero de Chicago. El equipo de investigación seleccionó el ejemplo del tráfico de Chicago porque los datos ingresados tienen características similares a los datos que se observan normalmente con fines de seguridad nacional. dijo Rudy García, un científico informático de Sandia y codirector del proyecto.

Ahogándose en datos

"Creamos datos sin siquiera pensar en ello, "dijo Laura Patrizi, un científico informático de Sandia y miembro del equipo de investigación, durante una charla en el Simposio GEOINT de la Fundación de Inteligencia Geoespacial de los Estados Unidos de 2019. "Cuando caminamos con el teléfono en el bolsillo o tuiteamos sobre el tráfico horrible, nuestro teléfono rastrea nuestra ubicación y puede adjuntar una geolocalización a nuestro tweet ".

Para aprovechar esta avalancha de datos, Los analistas suelen utilizar herramientas de macrodatos y algoritmos de aprendizaje automático para encontrar y resaltar información importante. pero el proceso se ejecuta en datos registrados, Dijo mamá.

"Queríamos ver qué se puede analizar con datos en tiempo real de varias fuentes de datos, no lo que se puede aprender de la minería de datos históricos, "Ma dijo." La inteligencia procesable es el siguiente nivel de análisis de datos donde el análisis se pone en uso para la toma de decisiones casi en tiempo real. El éxito de esta investigación tendrá un fuerte impacto en muchas aplicaciones de seguridad nacional críticas en el tiempo ".

Construyendo un marco de procesamiento de datos

El equipo apiló tecnologías distribuidas en una serie de canalizaciones de procesamiento de datos que ingieren, curar e indexar los datos. Los científicos que discutieron los datos especificaron cómo las tuberías deberían adquirir y limpiar los datos.

"Cada tipo de datos que ingerimos tiene su propio formato y esquema de datos, García dijo. Para que los datos sean útiles, primero tiene que ser curado para que se pueda descubrir fácilmente para un evento ".

Plataforma de datos de Hortonworks, corriendo en las computadoras de Sandia, se utilizó como infraestructura de software para el procesamiento de datos y las canalizaciones analíticas. Dentro de Hortonworks, el equipo desarrolló e integró topologías de Apache Storm para cada canal de datos. Luego, los datos seleccionados se almacenaron en Apache Solr, un motor de búsqueda empresarial y una base de datos. Se utilizaron PyTorch y Lucidwork's Banana para la detección de objetos de vehículos y la visualización de datos.

Encontrar los datos correctos

"Obtener grandes cantidades de datos es difícil, pero es aún más difícil encontrar la información que realmente busca, García dijo. Por ejemplo, durante el proyecto veíamos tweets que decían algo como "El control del tráfico aéreo nos ha mantenido en tierra durante la última hora en Midway". El tráfico está en el tweet, pero no es relevante para el tráfico de la autopista ".

Para determinar el nivel de congestión del tráfico en una autopista de Chicago, idealmente, la herramienta podría usar una variedad de tipos de datos, incluida una cámara de tráfico que muestra el flujo en ambas direcciones, tweets geolocalizados sobre accidentes, sensores de carretera que miden la velocidad media, Imágenes satelitales de las áreas y señales de tráfico que estiman los tiempos de viaje actuales entre hitos, dijo Forest Danford, un científico informático de Sandia y miembro del equipo de investigación.

"Sin embargo, también obtenemos muchos datos incorrectos, como la imagen de una cámara web que es difícil de leer, y es raro que terminemos con muchos tipos de datos diferentes que estén muy bien ubicados en el tiempo y el espacio, ", Dijo Danford." Necesitábamos un mecanismo para aprender sobre los más de 90 millones de eventos (relacionados con el tráfico de Chicago) que hemos observado para poder tomar decisiones basadas en información incompleta o imperfecta ".

El equipo agregó un clasificador de congestión de tráfico mediante la capacitación de sistemas informáticos fusionados modelados en el cerebro humano en características extraídas de imágenes etiquetadas y tweets. y otros eventos que correspondían a los datos en el tiempo y el espacio. El clasificador capacitado pudo generar predicciones sobre la congestión del tráfico en función de los datos operativos en cualquier momento y ubicación determinados, Dijo Danford.

Los profesores Minh Do y Ramavarapu Sreenivas y sus estudiantes en UIUC trabajaron en el reconocimiento de objetos e imágenes en tiempo real con imágenes de cámaras web y desarrollaron procesos sólidos de planificación de rutas basados en las diversas fuentes de datos.

"El desarrollo de una ciencia convincente para la inteligencia procesable requiere que nos enfrentemos a la dinámica basada en la información, ", Dijo Sreenivas." El santo grial aquí es resolver el problema de especificación. Necesitamos saber lo que queremos antes de construir algo que nos proporcione lo que queremos. Esto es mucho más difícil de lo que parece y este proyecto es el primer paso para comprender exactamente lo que nos gustaría tener ".

Avanzando el equipo de Sandia está transfiriendo la arquitectura, análisis y lecciones aprendidas en Chicago a otros proyectos gubernamentales y continuará investigando herramientas analíticas, realizar mejoras en el modelo de reconocimiento de objetos de los laboratorios y trabajar para generar inteligencia procesable.

"Estamos tratando de hacer que los datos sean detectables, accesible y utilizable, García dijo. "Y si podemos hacer eso a través de estas arquitecturas de big data, entonces creo que estamos ayudando ".