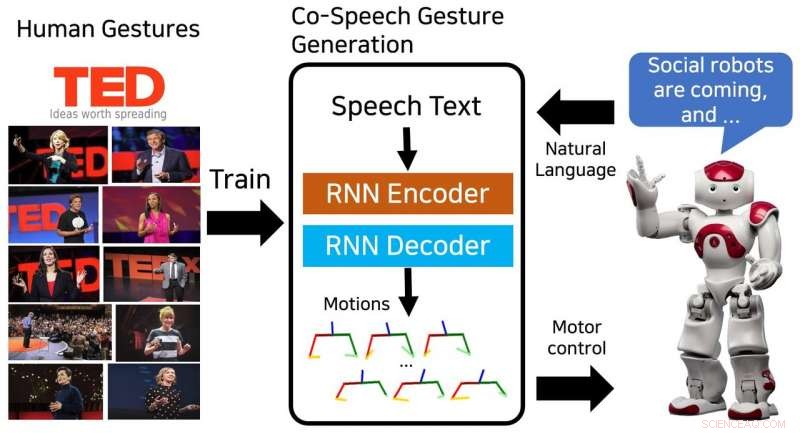

El modelo propuesto genera una secuencia de poses de la parte superior del cuerpo y se entrena en gestos humanos de las charlas TED. Crédito:Yoon et al.

Investigadores del Instituto de Investigación en Electrónica y Telecomunicaciones (ETRI) de Corea del Sur han desarrollado recientemente un modelo de red neuronal que puede generar secuencias de gestos de habla conjunta. Su modelo, capacitado en 52 horas de charlas TED, produjo con éxito gestos similares a los humanos que coincidían con el contenido del habla.

"Los dispositivos inteligentes con los que interactuamos han evolucionado desde computadoras personales hasta teléfonos móviles y parlantes inteligentes, "Youngwoo Yoon, uno de los investigadores que realizó el estudio, dijo a TechXplore. "Creemos que los robots sociales podrían ser la próxima plataforma de interacción. El movimiento físico es una de las diferencias clave entre los robots sociales y otros dispositivos inteligentes, abriendo nuevas posibilidades para emular comportamientos similares a los de los humanos o los animales, que puede aumentar la intimidad ".

Los gestos de cohabla podrían mejorar en gran medida la calidad de las interacciones entre humanos y robots sociales. La mayoría de los robots existentes producen gestos utilizando métodos de asociación de gestos de voz basados en reglas. Sin embargo, estas técnicas requieren esfuerzos considerables, ya que se basan en la experiencia y el conocimiento humanos.

"Queríamos generar comportamientos sociales naturales y similares a los humanos, especialmente los gestos con las manos al hablar, ", Dijo Yoon." Observar a los demás es una forma muy natural de aprender un nuevo comportamiento, así que propusimos un modelo de generación de gestos basado en el aprendizaje que se entrenó en un conjunto de datos de charlas TED ".

El modelo ideado por Yoon y sus colegas se entrenó en un conjunto de datos que contiene 52 horas de imágenes de video de las charlas TED. Después de entrenar, el modelo podría generar secuencias de gestos similares a los humanos y poses de la parte superior del cuerpo para que coincida con el texto escrito del habla.

"Diseñar los comportamientos sociales de los robots es difícil y requiere mucho tiempo porque tenemos que considerar los contextos, naturalidad, la estética del movimiento, el espacio de control de los robots, y una serie de otros factores, "Yoon explicó." Estudios recientes de aprendizaje de un extremo a otro han arrojado luz sobre el potencial de las inteligencias artificiales para generar comportamientos tan complejos. Después de ver aplicaciones exitosas en conducción autónoma y generación de movimientos faciales, decidimos aplicar el aprendizaje de un extremo a otro a la generación de gestos de habla conjunta ".

El modelo de red neuronal desarrollado por Yoon y sus colegas generó con éxito varios tipos de gestos, incluyendo icónico, metafórico deíctico y batir gestos. Es más, fue capaz de generar secuencias continuas de gestos para textos de voz de cualquier longitud.

Los investigadores encontraron que su método superó a los métodos de referencia en la creación de gestos que se asemejan a los de los humanos. En una evaluación subjetiva, 46 personas reclutadas en Amazon Mechanical Turk sintieron que los gestos que generaba eran similares a los humanos y coincidían estrechamente con el contenido del discurso.

"Descubrimos que los robots pueden aprender habilidades sociales, "Dijo Yoon." Para la generación de gestos de co-habla, el modelo entrenado en el conjunto de datos a gran escala es lo suficientemente general, para que el robot pueda realizar gestos similares a los humanos para cualquier discurso. Creemos que este enfoque se puede aplicar a otras habilidades sociales, así como a personajes de videojuegos y mundos de realidad virtual ".

El estudio realizado por Yoon y sus colegas destacó el potencial del aprendizaje de extremo a extremo para la generación de gestos de habla conjunta. En el futuro, podría usarse para mejorar las interacciones humano-robot y también podría inspirar investigaciones similares, ya que el conjunto de datos de conversaciones de TED que utilizaron está disponible públicamente. Los investigadores ahora planean llevar su estudio un paso adelante, generando gestos personalizados para diferentes robots.

"Los robots pueden tener su propia personalidad, como personas, ", Dijo Yoon." Un método de generación de gestos personalizados podría garantizar que diferentes robots se expresen con diferentes estilos de gestos, según su persona ".

© 2018 Science X Network