Ejemplo de imagen de rostro real a partir de un conjunto de datos proporcionado por el documento "Progressive Growing of GANs for Improved Quality, Estabilidad, y variación ”. Crédito:Karras et al.

Investigadores de la Universidad de Shenzhen han ideado recientemente un método para detectar imágenes generadas por redes neuronales profundas. Su estudio, prepublicado en arXiv, identificó un conjunto de características para capturar estadísticas de imágenes en color que pueden detectar imágenes generadas utilizando herramientas de inteligencia artificial actuales.

"Nuestra investigación se inspiró en el rápido desarrollo de modelos generativos de imágenes y la difusión de imágenes falsas generadas, "Bin Li, uno de los investigadores que realizó el estudio, dicho Tech Xplore . "Con el surgimiento de modelos avanzados de generación de imágenes, como las redes generativas adversarias (GAN) y los codificadores automáticos variacionales, las imágenes generadas por redes profundas se vuelven cada vez más fotorrealistas, y ya no es fácil identificarlos con ojos humanos, lo que conlleva graves riesgos de seguridad ".

Recientemente, Varios investigadores y plataformas de medios globales han expresado su preocupación por los riesgos que plantean las redes neuronales artificiales entrenadas para generar imágenes. Por ejemplo, Los algoritmos de aprendizaje profundo, como las redes generativas de confrontación (GAN) y los codificadores automáticos variacionales, podrían usarse para generar imágenes y videos realistas para noticias falsas o podrían facilitar los fraudes en línea y la falsificación de información personal en las redes sociales.

Los algoritmos GAN están entrenados para generar imágenes cada vez más realistas a través de un proceso de prueba y error en el que un algoritmo genera imágenes y otro, el discriminador, da retroalimentación para hacer estas imágenes más realistas. Hipotéticamente este discriminador también podría entrenarse para detectar imágenes falsas a partir de imágenes reales. Sin embargo, Estos algoritmos utilizan principalmente imágenes RGB como entrada y no tienen en cuenta las disparidades en los componentes de color. por lo tanto, su desempeño probablemente sería insatisfactorio.

Ejemplo de imagen facial generada a partir de un conjunto de datos proporcionado por el documento "Progressive Growing of GANs for Improved Quality, Estabilidad, y variación ”. Crédito:Karras et al.

En su estudio, Li y sus colegas analizaron las diferencias entre las imágenes generadas por GAN y las imágenes reales, proponiendo un conjunto de características que efectivamente podrían ayudar a clasificarlos. El método resultante funciona analizando las diferencias en los componentes de color entre las imágenes reales y las generadas.

"Nuestra idea básica es que los canales de generación de imágenes reales y las imágenes generadas son bastante diferentes, por lo que las dos clases de imágenes deberían tener algunas propiedades diferentes, "Haodong Li, explicó uno de los investigadores. "De hecho, provienen de diferentes oleoductos. Por ejemplo, Las imágenes reales son generadas por dispositivos de imágenes como cámaras y escáneres para capturar una escena real. mientras que las imágenes generadas se crean de una manera totalmente diferente con convolución, conexión, y activación de redes neuronales. Las diferencias pueden resultar en diferentes propiedades estadísticas. En este estudio, consideramos principalmente las propiedades estadísticas de los componentes del color ".

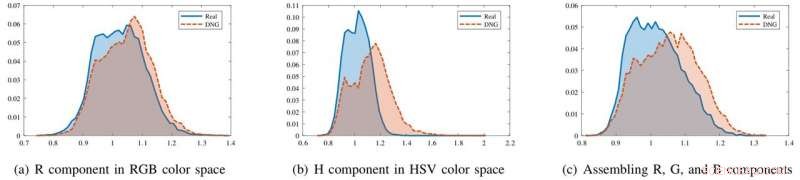

Los investigadores encontraron que aunque las imágenes generadas y las imágenes reales se parecen en el espacio de color RGB, tienen propiedades estadísticas marcadamente diferentes en los componentes de crominancia de HSV y YCbCr. También observaron diferencias al ensamblar la R, GRAMO, y componentes de color B juntos.

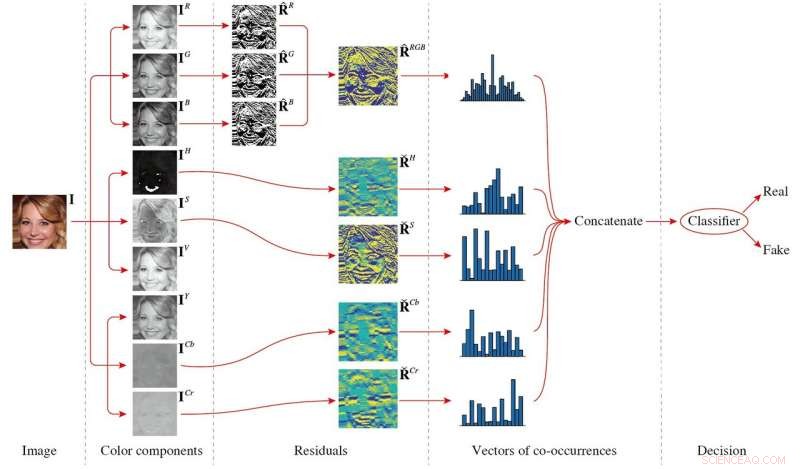

El conjunto de funciones que propusieron, que consiste en matrices de co-ocurrencia extraídas de la imagen de filtrado de paso alto residuales de varios componentes de color, explota estas diferencias, capturando disparidades de color entre imágenes reales y generadas. Este conjunto de funciones es de baja dimensión y puede funcionar bien incluso cuando se entrena en un pequeño conjunto de datos de imágenes.

Los histogramas de estadísticas de imagen para imágenes reales (azul) e imágenes generadas en red profunda (DNG) (rojo) en diferentes componentes de color. En el componente R, los dos histogramas se superponen en gran medida. Sin embargo, en el componente H o ensamblando R, GRAMO, Componentes B juntos, los histogramas son más separables. Crédito:Li et al.

Li y sus colegas probaron el rendimiento de su método en tres conjuntos de datos de imágenes:Atributos CelebFaces, CelebA de alta calidad, y caras etiquetadas en la naturaleza. Sus hallazgos fueron muy prometedores, con el conjunto de características funcionando bien en los tres conjuntos de datos.

"El hallazgo más significativo de nuestro estudio es que las imágenes generadas por redes profundas pueden detectarse fácilmente extrayendo características de ciertos componentes de color, aunque las imágenes generadas pueden ser visualmente indistinguibles con los ojos humanos, "Haodong Li dijo." Cuando las muestras de imágenes generadas o los modelos generativos están disponibles, las características propuestas equipadas con un clasificador binario pueden diferenciar efectivamente entre imágenes generadas e imágenes reales. Cuando se desconocen los modelos generativos, las características propuestas junto con un clasificador de una clase también pueden lograr un rendimiento satisfactorio ".

El estudio podría tener varias implicaciones prácticas. Primero, el método podría ayudar a identificar imágenes falsas en línea.

El marco general del método propuesto. La imagen de entrada se descompone primero en diferentes componentes de color, y luego se calcula el residuo de cada componente de color. Para calcular las co-ocurrencias, El r, GRAMO, y los componentes B están ensamblados, mientras que la H, S, Cb, y los componentes de Cr se procesan de forma independiente. Finalmente, todos los vectores de co-ocurrencia se concatenan y se alimentan a un clasificador para obtener el resultado de la decisión. Crédito:Li et al.

Their findings also imply that several inherent color properties of real images have not yet been effectively replicated by existing generative models. En el futuro, this knowledge could be used to build new models that generate even more realistic images.

Finalmente, their study proves that different generation pipelines used to produce real images and generated images are reflected in the properties of the images produced. Color components comprise merely one of the ways in which these two types of images differ, so further studies could focus on other properties.

"En el futuro, we plan to improve the image generation performance by applying the findings of this research to image generative models, " Jiwu Huang, one of the researchers said. "Por ejemplo, including the disparity metrics of color components for real and generated images into the objective function of a GAN model could produce more realistic images. We will also try to leverage other inherent information from the real image generation pipeline, such as sensor pattern noises or properties of color filter array, to develop more effective and robust methods for identifying generated images."

© 2018 Tech Xplore