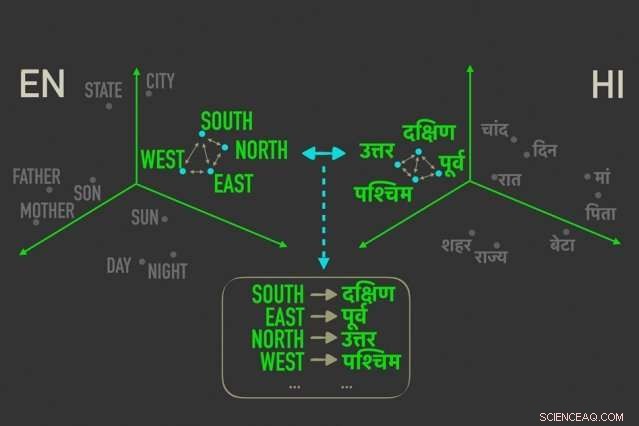

El nuevo modelo mide las distancias entre palabras con significados similares en "inserciones de palabras, ”Y luego alinea las palabras en ambas incrustaciones que están más estrechamente correlacionadas por distancias relativas, lo que significa que es más probable que sean traducciones directas entre sí. Crédito:Instituto de Tecnología de Massachusetts

Los investigadores del MIT han desarrollado un novedoso modelo de traducción de idiomas "sin supervisión", lo que significa que se ejecuta sin la necesidad de anotaciones humanas y orientación, que podría conducir a una traducción más rápida, Traducciones por computadora más eficientes de muchos más idiomas.

Sistemas de traducción de Google, Facebook, y Amazon requieren modelos de capacitación para buscar patrones en millones de documentos, como documentos legales y políticos, o artículos de noticias, que han sido traducidos a varios idiomas por humanos. Dadas nuevas palabras en un idioma, luego pueden encontrar las palabras y frases que coincidan en el otro idioma.

Pero estos datos de traducción requieren mucho tiempo y son difíciles de recopilar, y simplemente puede que no exista para muchos de los 7, 000 idiomas que se hablan en todo el mundo. Recientemente, Los investigadores han estado desarrollando modelos "monolingües" que hacen traducciones entre textos en dos idiomas, pero sin información de traducción directa entre los dos.

En un artículo presentado esta semana en la Conferencia sobre métodos empíricos en el procesamiento del lenguaje natural, Los investigadores del Laboratorio de Ciencias de la Computación e Inteligencia Artificial del MIT (CSAIL) describen un modelo que se ejecuta de manera más rápida y eficiente que estos modelos monolingües.

El modelo aprovecha una métrica en estadísticas, llamada distancia de Gromov-Wasserstein, que esencialmente mide distancias entre puntos en un espacio computacional y las compara con puntos distanciados de manera similar en otro espacio. Aplican esa técnica a las "inserciones de palabras" de dos idiomas, que son palabras representadas como vectores, básicamente, matrices de números, con palabras de significados similares agrupadas más juntas. Al hacerlo, el modelo alinea rápidamente las palabras, o vectores, en ambas incrustaciones que están más estrechamente correlacionadas por distancias relativas, lo que significa que probablemente sean traducciones directas.

En experimentos, El modelo de los investigadores funcionó con la misma precisión que los modelos monolingües de última generación, ya veces con mayor precisión, pero mucho más rápido y utilizando solo una fracción del poder de cálculo.

"El modelo ve las palabras en los dos idiomas como conjuntos de vectores, y mapea [esos vectores] de un conjunto a otro esencialmente preservando las relaciones, "dice el coautor del artículo, Tommi Jaakkola, un investigador de CSAIL y el profesor Thomas Siebel en el Departamento de Ingeniería Eléctrica y Ciencias de la Computación y el Instituto de Datos, Sistemas y Sociedad. "El enfoque podría ayudar a traducir idiomas o dialectos de bajos recursos, siempre que tengan suficiente contenido monolingüe ".

El modelo representa un paso hacia uno de los principales objetivos de la traducción automática, que es una alineación de palabras totalmente sin supervisión, dice el primer autor David Alvarez-Melis, un doctorado en CSAIL estudiante:"Si no tienes datos que coincidan con dos idiomas ... puedes mapear dos idiomas y, utilizando estas medidas de distancia, alinearlos ".

Las relaciones importan más

La alineación de incrustaciones de palabras para la traducción automática sin supervisión no es un concepto nuevo. Un trabajo reciente entrena las redes neuronales para hacer coincidir los vectores directamente en incrustaciones de palabras, o matrices, de dos idiomas juntos. Pero estos métodos requieren muchos ajustes durante el entrenamiento para obtener las alineaciones exactamente correctas, lo cual es ineficiente y requiere mucho tiempo.

Medir y emparejar vectores basados en distancias relacionales, por otra parte, es un método mucho más eficiente que no requiere muchos ajustes. No importa dónde caigan los vectores de palabras en una matriz dada, la relación entre las palabras, es decir, sus distancias, seguirá siendo el mismo. Por ejemplo, el vector de "padre" puede caer en áreas completamente diferentes en dos matrices. Pero los vectores de "padre" y "madre" probablemente siempre estarán muy juntos.

"Esas distancias son invariantes, "Dice Álvarez-Melis." Al mirar a la distancia, y no las posiciones absolutas de los vectores, luego puede omitir la alineación e ir directamente a hacer coincidir las correspondencias entre los vectores ".

Ahí es donde Gromov-Wasserstein resulta útil. La técnica se ha utilizado en informática para, decir, ayudando a alinear los píxeles de la imagen en el diseño gráfico. Pero la métrica parecía "hecha a medida" para la alineación de palabras, Álvarez-Melis dice:"Si hay puntos, o palabras, que están muy juntos en un espacio, Gromov-Wasserstein intentará automáticamente encontrar el grupo de puntos correspondiente en el otro espacio ".

Para entrenamiento y pruebas, los investigadores utilizaron un conjunto de datos de incrustaciones de palabras disponibles públicamente, llamado FASTTEXT, con 110 pares de idiomas. En estas incrustaciones, y otros, las palabras que aparecen cada vez con más frecuencia en contextos similares tienen vectores que coinciden estrechamente. "Madre" y "padre" suelen estar juntos, pero ambos más lejos de, decir, "casa."

Proporcionar una "traducción suave"

El modelo observa vectores que están estrechamente relacionados pero diferentes de los demás, y asigna una probabilidad de que correspondan vectores con distancias similares en la otra incrustación. Es como una "traducción suave, "Alvarez-Melis dice, "porque en lugar de devolver la traducción de una sola palabra, te dice 'este vector, o palabra, tiene una fuerte correspondencia con esta palabra, o palabras, en el otro idioma '".

Un ejemplo sería en los meses del año, que aparecen muy juntos en muchos idiomas. El modelo verá un grupo de 12 vectores que están agrupados en una incrustación y un grupo notablemente similar en la otra incrustación. "El modelo no sabe que son meses, "Dice Álvarez-Melis." Simplemente sabe que hay un grupo de 12 puntos que se alinea con un grupo de 12 puntos en el otro idioma, pero son diferentes al resto de las palabras, por lo que probablemente vayan bien juntos. Al encontrar estas correspondencias para cada palabra, luego alinea todo el espacio simultáneamente ".

Los investigadores esperan que el trabajo sirva como una "verificación de viabilidad, "Jaakkola dice, aplicar el método de Gromov-Wasserstein a los sistemas de traducción automática para que se ejecuten más rápido, más eficientemente, y acceda a muchos más idiomas.

Adicionalmente, una posible ventaja del modelo es que produce automáticamente un valor que se puede interpretar como cuantificador, en una escala numérica, la similitud entre idiomas. Esto puede ser útil para estudios de lingüística, dicen los investigadores. El modelo calcula qué tan distantes están todos los vectores entre sí en dos incrustaciones, que depende de la estructura de la oración y otros factores. Si los vectores están muy cerca, anotarán más cerca de 0, y cuanto más separados están, cuanto mayor sea la puntuación. Idiomas romances similares como el francés y el italiano, por ejemplo, puntuación cercana a 1, mientras que el chino clásico puntúa entre 6 y 9 con otros idiomas importantes.

"Esto te da un buen un número simple de lo similares que son los idiomas ... y se puede utilizar para obtener información sobre las relaciones entre los idiomas, "Dice Álvarez-Melis.

Esta historia se vuelve a publicar por cortesía de MIT News (web.mit.edu/newsoffice/), un sitio popular que cubre noticias sobre la investigación del MIT, innovación y docencia.