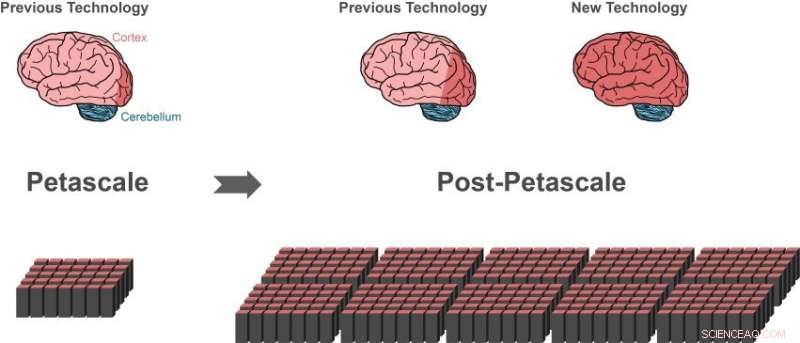

La tecnología de simulación anterior puede representar aproximadamente el 1 por ciento de las células nerviosas (neuronas) en un cerebro humano (área roja oscura del cerebro a la izquierda) usando una supercomputadora de petaescala (abajo a la izquierda). Solo un pequeño progreso (área roja oscura del cerebro central) sería posible en la próxima generación de supercomputadoras que superará el rendimiento de las supercomputadoras de alta gama de hoy en día entre 10 y 100 veces. Las partes más grandes del cerebro humano se pueden representar con la nueva tecnología, usando la misma cantidad de memoria de computadora (abajo a la derecha) .i el 10 por ciento del cerebro tiene aproximadamente el tamaño de toda la corteza (área roja oscura del cerebro a la derecha), que es esencial para un procesamiento superior. Una gran parte de las otras neuronas se encuentran en el cerebelo (azul). Crédito:Forschungszentrum Jülich

Un grupo internacional de investigadores ha dado un paso decisivo hacia la creación de la tecnología para lograr simulaciones de redes a escala cerebral en futuras supercomputadoras de la clase exaescala. El gran avance publicado en Fronteras en neuroinformática , permite representar partes más grandes del cerebro humano, utilizando la misma cantidad de memoria de computadora. Simultaneamente, el nuevo algoritmo acelera significativamente las simulaciones cerebrales en supercomputadoras existentes.

El cerebro humano es un órgano de increíble complejidad, compuesto por 100 mil millones de células nerviosas interconectadas. Sin embargo, incluso con la ayuda de las supercomputadoras más potentes disponibles, Actualmente es imposible simular el intercambio de señales neuronales en redes de este tamaño.

"Desde 2014, nuestro software puede simular alrededor del uno por ciento de las neuronas del cerebro humano con todas sus conexiones, "dice Markus Diesmann, Director del Instituto de Neurociencia y Medicina de Jülich (INM-6). Para lograr esta impresionante hazaña, el software requiere toda la memoria principal de las supercomputadoras de petaescala, como la computadora K en Kobe y JUQUEEN en Jülich.

Diesmann lleva más de 20 años trabajando en el software de simulación NEST, un software gratuito código de simulación de código abierto de uso generalizado por la comunidad neurocientífica y un simulador central del Proyecto Europeo del Cerebro Humano, en el que lidera proyectos en las áreas de Neurociencia Teórica y en la Plataforma de Computación y Analítica de Alto Rendimiento.

Con NEST, el comportamiento de cada neurona en la red está representado por un puñado de ecuaciones matemáticas. Futuros ordenadores a exaescala, como la computadora post-K planeada en Kobe y JUWELS en Jülich, superará el rendimiento de las supercomputadoras de gama alta de hoy en día de 10 a 100 veces. Por primera vez, los investigadores dispondrán de la potencia informática disponible para simular redes neuronales a la escala del cerebro humano.

Aparentemente un callejón sin salida

Si bien la tecnología de simulación actual permitió a los investigadores comenzar a estudiar grandes redes neuronales, también representó un callejón sin salida en el camino hacia la tecnología de exaescala. Las supercomputadoras se componen de aproximadamente 100, 000 pequeñas computadoras, llamados nodos, cada uno equipado con varios procesadores que realizan los cálculos reales.

"Antes de que se pueda realizar una simulación de red neuronal, las neuronas y sus conexiones deben crearse virtualmente, lo que significa que deben instanciarse en la memoria de los nodos. Durante la simulación, una neurona no sabe en cuál de los nodos tiene neuronas objetivo, por lo tanto, sus impulsos eléctricos cortos deben enviarse a todos los nodos. Luego, cada nodo verifica cuál de todos estos pulsos eléctricos es relevante para las neuronas virtuales que existen en este nodo, "explica Susanne Kunkel del KTH Royal Institute of Technology en Estocolmo.

El algoritmo actual para la creación de redes es eficiente porque todos los nodos construyen su parte particular de la red al mismo tiempo. Sin embargo, enviar todos los pulsos eléctricos a todos los nodos no es adecuado para simulaciones en sistemas de exaescala.

"Verificar la relevancia de cada pulso eléctrico de manera eficiente requiere un bit de información por procesador para cada neurona en toda la red. Para una red de mil millones de neuronas, una gran parte de la memoria en cada nodo es consumida por este único Bit de información por neurona, "añade Markus Diesmann.

Este es el principal problema al simular redes aún más grandes:la cantidad de memoria de computadora requerida por procesador para los Bits adicionales por neurona aumenta con el tamaño de la red neuronal. A la escala del cerebro humano, esto requeriría que la memoria disponible para cada procesador fuera 100 veces más grande que en las supercomputadoras actuales. Esta, sin embargo, Es poco probable que sea el caso en la próxima generación de supercomputadoras. El número de procesadores por nodo de cómputo aumentará, pero la memoria por procesador y el número de nodos de cómputo permanecerán igual.

Avance mediante un nuevo algoritmo

El avance publicado en Fronteras en neuroinformática es una nueva forma de construir la red neuronal en la supercomputadora. Debido a los algoritmos, la memoria requerida en cada nodo ya no aumenta con el tamaño de la red. Al comienzo de la simulación, la nueva tecnología permite que los nodos intercambien información sobre quién necesita enviar datos de actividad neuronal a quién. Una vez que este conocimiento esté disponible, el intercambio de datos de actividad neuronal entre nodos se puede organizar de modo que un nodo solo reciba la información que necesita. Ya no es necesario un bit adicional para cada neurona de la red.

Un efecto secundario beneficioso

Mientras prueban sus nuevas ideas, los científicos hicieron una idea clave adicional, Susanne Kunkel informa:"Al analizar los nuevos algoritmos, nos dimos cuenta de que nuestra nueva tecnología no solo permitiría simulaciones en sistemas de exaescala, pero también haría que las simulaciones fueran más rápidas en las supercomputadoras actualmente disponibles ".

De hecho, como el consumo de memoria ahora está bajo control, la velocidad de las simulaciones se convierte en el foco principal de futuros desarrollos tecnológicos. Por ejemplo, Una gran simulación de 0,52 mil millones de neuronas conectadas por 5,8 billones de sinapsis que se ejecutan en la supercomputadora JUQUEEN en Jülich requería previamente 28,5 minutos para calcular un segundo de tiempo biológico. Con la simulación mejorada de estructuras de datos, el tiempo se reduce a 5,2 minutos.

"Con la nueva tecnología podemos aprovechar el mayor paralelismo de los microprocesadores modernos mucho mejor que antes, que será aún más importante en las computadoras de exaescala, "comenta Jakob Jordan, autor principal del estudio, de Forschungszentrum Jülich.

"La combinación de hardware de exaescala y software apropiado trae investigaciones de aspectos fundamentales de la función cerebral, como la plasticidad y el aprendizaje que se desarrolla a lo largo de minutos de tiempo biológico a nuestro alcance, "añade Markus Diesmann.

Con una de las próximas versiones del software de simulación NEST, los investigadores pondrán su logro a disposición de la comunidad de forma gratuita como fuente abierta.

"Hemos estado usando NEST para simular la compleja dinámica de los circuitos de los ganglios basales en la salud y la enfermedad de Parkinson en la computadora K. Estamos emocionados de escuchar las noticias sobre la nueva generación de NEST, lo que nos permitirá ejecutar simulaciones a escala de todo el cerebro en la computadora post-K para aclarar los mecanismos neuronales del control motor y las funciones mentales, "dice Kenji Doya del Instituto de Ciencia y Tecnología de Okinawa (OIST).

"El estudio es un maravilloso ejemplo de la colaboración internacional en el esfuerzo por construir computadoras de exaescala. Es importante que tengamos aplicaciones listas que puedan usar estas preciosas máquinas desde el primer día que estén disponibles". ", concluye Mitsuhisa Sato del Instituto Avanzado de Ciencias de la Computación RIKEN en Kobe.