Crédito:Universidad de Texas en Austin

La rápida progresión de la tecnología ha llevado a un gran aumento en el uso de energía para procesar los enormes tesoros de datos generados por los dispositivos. Pero los investigadores de la Escuela de Ingeniería Cockrell de la Universidad de Texas en Austin han encontrado una manera de hacer que la nueva generación de computadoras inteligentes sea más eficiente desde el punto de vista energético.

Tradicionalmente, Los chips de silicio han formado los componentes básicos de la infraestructura que alimenta las computadoras. Pero esta investigación utiliza componentes magnéticos en lugar de silicio y descubre nueva información sobre cómo la física de los componentes magnéticos puede reducir los costos de energía y los requisitos de los algoritmos de entrenamiento:redes neuronales que pueden pensar como humanos y hacer cosas como reconocer imágenes y patrones.

"Ahora, los métodos para entrenar sus redes neuronales consumen mucha energía, "dijo Jean Anne Incorvia, profesor asistente en el Departamento de Ingeniería Eléctrica e Informática de la Escuela Cockrell. "Lo que nuestro trabajo puede hacer es ayudar a reducir el esfuerzo de capacitación y los costos de energía".

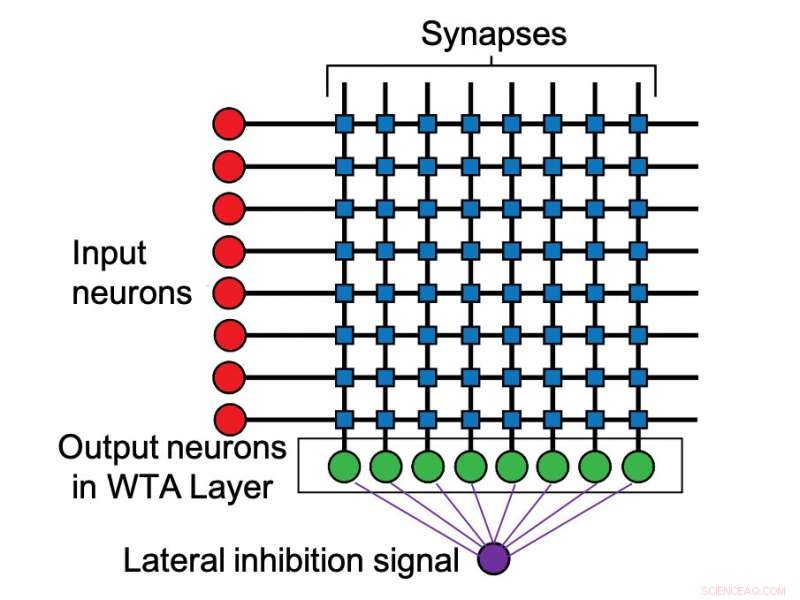

Los hallazgos de los investigadores se publicaron esta semana en IOP Nanotecnología . Incorvia dirigió el estudio con el primer autor y estudiante de posgrado de segundo año Can Cui. Incorvia y Cui descubrieron que los nanocables magnéticos espaciados, actuando como neuronas artificiales, de cierta manera, aumenta naturalmente la capacidad de las neuronas artificiales para competir entre sí, con los más activados ganando. Al lograr este efecto, conocido como "inhibición lateral, "tradicionalmente requiere circuitos adicionales dentro de las computadoras, lo que aumenta los costos y requiere más energía y espacio.

Incorvia dijo que su método proporciona una reducción de energía de 20 a 30 veces la cantidad utilizada por un algoritmo de retropropagación estándar cuando se realizan las mismas tareas de aprendizaje.

De la misma manera que los cerebros humanos contienen neuronas, Las computadoras de la nueva era tienen versiones artificiales de estas células nerviosas integrales. La inhibición lateral se produce cuando las neuronas que disparan más rápido pueden evitar que las neuronas más lentas se disparen. En informática, esto reduce el uso de energía en el procesamiento de datos.

Incorvia explica que la forma en que operan las computadoras está cambiando fundamentalmente. Una tendencia importante es el concepto de computación neuromórfica, que es esencialmente diseñar computadoras para pensar como cerebros humanos. En lugar de procesar las tareas de una en una, Estos dispositivos más inteligentes están diseñados para analizar grandes cantidades de datos simultáneamente. Estas innovaciones han impulsado la revolución en el aprendizaje automático y la inteligencia artificial que ha dominado el panorama tecnológico en los últimos años.

Esta investigación se centró en las interacciones entre dos neuronas magnéticas y los resultados iniciales sobre las interacciones de múltiples neuronas. El siguiente paso consiste en aplicar los hallazgos a conjuntos más grandes de múltiples neuronas, así como en la verificación experimental de sus hallazgos.