(De izquierda a derecha) Kevin Yager, Masafumi Fukuto, y Ruipeng Li prepararon la línea de luz de dispersión de materiales complejos (CMS) en NSLS-II para una medición utilizando el nuevo algoritmo de toma de decisiones, que fue desarrollado por Marcus Noack (no en la foto). Crédito:Laboratorio Nacional Brookhaven

Un equipo de científicos del Laboratorio Nacional Brookhaven del Departamento de Energía de EE. UU. Y el Laboratorio Nacional Lawrence Berkeley diseñaron, creado, y probó con éxito un nuevo algoritmo para tomar decisiones de medición científica más inteligentes. El algoritmo una forma de inteligencia artificial (IA), puede tomar decisiones autónomas para definir y realizar el siguiente paso de un experimento. El equipo describió las capacidades y la flexibilidad de su nueva herramienta de medición en un artículo publicado el 14 de agosto de 2019 en Informes científicos .

Desde Galileo y Newton hasta el reciente descubrimiento de ondas gravitacionales, La realización de experimentos científicos para comprender el mundo que nos rodea ha sido la fuerza impulsora de nuestro avance tecnológico durante cientos de años. Mejorar la forma en que los investigadores realizan sus experimentos puede tener un impacto tremendo en la rapidez con que esos experimentos producen resultados aplicables para nuevas tecnologías.

Durante las últimas décadas, Los investigadores han acelerado sus experimentos mediante la automatización y una variedad cada vez mayor de herramientas de medición rápida. Sin embargo, Algunos de los desafíos científicos más interesantes e importantes, como la creación de materiales de batería mejorados para el almacenamiento de energía o nuevos materiales cuánticos para nuevos tipos de computadoras, aún requieren experimentos muy exigentes y que requieren mucho tiempo.

Al crear un nuevo algoritmo de toma de decisiones como parte de una configuración experimental totalmente automatizada, el equipo interdisciplinario de dos de las instalaciones para usuarios de la Oficina de Ciencias del DOE de Brookhaven, el Centro de Nanomateriales Funcionales (CFN) y la Fuente de Luz Nacional Sincrotrón II (NSLS-II), y el Centro de Matemáticas Avanzadas para Aplicaciones de Investigación Energética (CAMERA) de Berkeley Lab la posibilidad de estudiar estos desafíos de una manera más eficiente.

El desafío de la complejidad

El objetivo de muchos experimentos es adquirir conocimientos sobre el material que se estudia, y los científicos tienen una forma bien probada de hacer esto:toman una muestra del material y miden cómo reacciona a los cambios en su entorno.

Un enfoque estándar para los científicos en instalaciones de usuarios como NSLS-II y CFN es escanear manualmente las mediciones de un experimento dado para determinar la siguiente área donde podrían querer ejecutar un experimento. Pero el acceso a las herramientas de caracterización de materiales de alta gama de estas instalaciones es limitado, por lo que el tiempo de medición es precioso. Un equipo de investigación puede tener solo unos días para medir sus materiales, por lo que deben aprovechar al máximo cada medición.

"La clave para lograr un número mínimo de mediciones y la máxima calidad del modelo resultante es ir donde las incertidumbres son grandes, "dijo Marcus Noack, becario postdoctoral en CAMERA y autor principal del estudio. "La realización de mediciones allí reducirá de manera más eficaz la incertidumbre general del modelo".

Como Kevin Yager, un coautor y científico de CFN, señaló, "El objetivo final no es solo obtener datos más rápido, sino también mejorar la calidad de los datos que recopilamos. Creo que los experimentadores pasan de la microgestión de su experimento a la gestión a un nivel superior. En lugar de tener que decidir dónde medir a continuación en la muestra, en cambio, los científicos pueden pensar en el panorama general, que es, en última instancia, lo que nosotros, como científicos, estamos tratando de hacer ".

"Este nuevo enfoque es un ejemplo aplicado de inteligencia artificial, "dijo el coautor Masafumi Fukuto, científico de NSLS-II. "El algoritmo de toma de decisiones está reemplazando la intuición del experimentador humano y puede escanear los datos y tomar decisiones inteligentes sobre cómo debe proceder el experimento".

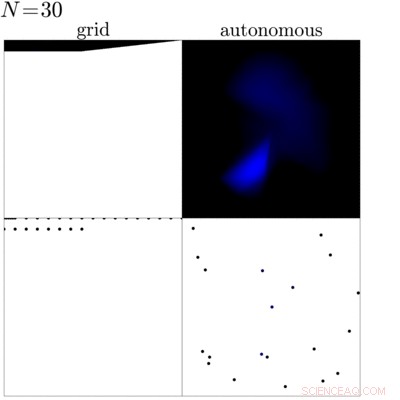

Esta animación muestra una comparación entre una medición de cuadrícula tradicional (izquierda) de una muestra con una medición dirigida por el algoritmo de toma de decisiones recientemente desarrollado (derecha). Esta comparación muestra que el algoritmo puede identificar los bordes y la parte interna de la muestra y enfoca la medición en estas regiones para obtener más conocimiento sobre la muestra. Crédito:Laboratorio Nacional Brookhaven

¿Más información por menos?

En la práctica, antes de comenzar un experimento, los científicos definen un conjunto de objetivos que quieren obtener de la medición. Con estos objetivos establecidos, el algoritmo mira los datos medidos previamente mientras el experimento está en curso para determinar la siguiente medición. En su búsqueda de la mejor medición siguiente, el algoritmo crea un modelo sustituto de los datos, que es una suposición fundamentada sobre cómo se comportará el material en los próximos pasos posibles, y calcula la incertidumbre (básicamente, la confianza que tiene en su conjetura) para cada posible paso siguiente. Basado en esto, luego selecciona la opción más incierta para medir a continuación. El truco aquí es elegir el paso más incierto para medir a continuación, el algoritmo maximiza la cantidad de conocimiento que obtiene al realizar esa medición. El algoritmo no solo maximiza la ganancia de información durante la medición, también define cuándo finalizar el experimento calculando el momento en el que cualquier medición adicional no resultaría en un mayor conocimiento.

"La idea básica es, dado un montón de experimentos, ¿Cómo se puede elegir automáticamente el siguiente mejor? ", dijo James Sethian. director de CAMERA y coautor del estudio. "Marcus ha construido un mundo que construye un modelo sustituto aproximado sobre la base de sus experimentos anteriores y sugiere el mejor o más apropiado experimento para probar a continuación".

Como llegamos aqui

Para hacer realidad los experimentos autónomos, el equipo tuvo que abordar tres piezas importantes:la automatización de la recopilación de datos, análisis en tiempo real, y, por supuesto, el algoritmo de toma de decisiones.

"Esta es una parte emocionante de esta colaboración, ", dijo Fukuto." Todos proporcionamos una pieza esencial para ello:el equipo de CAMERA trabajó en el algoritmo de toma de decisiones, Kevin de CFN desarrolló el análisis de datos en tiempo real, y nosotros en NSLS-II proporcionamos la automatización para las mediciones ".

El equipo implementó por primera vez su algoritmo de toma de decisiones en la línea de luz de Dispersión de Materiales Complejos (CMS) en NSLS-II, que el CFN y NSLS-II operan en asociación. Este instrumento ofrece rayos X ultrabrillantes para estudiar la nanoestructura de varios materiales. Como científico principal de la línea de luz de este instrumento, Fukuto ya había diseñado la línea de luz con la automatización en mente. La línea de luz ofrece un robot de intercambio de muestras, movimiento automático de la muestra en varias direcciones, y muchas otras herramientas útiles para garantizar mediciones rápidas. Junto con el análisis de datos en tiempo real de Yager, la línea de luz fue, por diseño, el ajuste perfecto para el primer experimento "inteligente".

El primer experimento "inteligente"

El primer experimento completamente autónomo que realizó el equipo fue mapear el perímetro de una gota donde las nanopartículas se segregan usando una técnica llamada dispersión de rayos X de ángulo pequeño en la línea de luz CMS. Durante la dispersión de rayos X de ángulo pequeño, los científicos hacen brillar rayos X brillantes en la muestra y, dependiendo de la estructura atómica a nanoescala de la muestra, los rayos X rebotan en diferentes direcciones. Luego, los científicos usan un detector grande para capturar los rayos X dispersos y calcular las propiedades de la muestra en el lugar iluminado. En este primer experimento, los científicos compararon el enfoque estándar de medir la muestra con las medidas tomadas cuando el nuevo algoritmo de toma de decisiones estaba tomando las decisiones. El algoritmo pudo identificar el área de la gota y se centró en sus bordes y partes internas en lugar del fondo.

"Después de nuestro propio éxito inicial, queríamos aplicar más el algoritmo, así que nos comunicamos con algunos usuarios y propusimos probar nuestro nuevo algoritmo en sus problemas científicos, "dijo Yager." Dijeron que sí, y desde entonces hemos medido varias muestras. Uno de los más interesantes fue el estudio de una muestra que se fabricó para contener un espectro de diferentes tipos de materiales. Entonces, en lugar de hacer y medir una gran cantidad de muestras y tal vez perder una combinación interesante, el usuario hizo una sola muestra que incluía todas las combinaciones posibles. Nuestro algoritmo pudo explorar esta enorme diversidad de combinaciones de manera eficiente, " él dijo.

¿Que sigue?

Después de los primeros experimentos exitosos, los científicos planean mejorar aún más el algoritmo y, por lo tanto, su valor para la comunidad científica. Una de sus ideas es hacer que el algoritmo sea "consciente de la física", aprovechando todo lo que ya se sabe sobre el material en estudio, para que el método sea aún más eficaz. Otro desarrollo en progreso es utilizar el algoritmo durante la síntesis y el procesamiento de nuevos materiales, por ejemplo, para comprender y optimizar los procesos relevantes para la fabricación avanzada, ya que estos materiales se incorporan en dispositivos del mundo real. El equipo también está pensando en un panorama más amplio y quiere transferir el método autónomo a otras configuraciones experimentales.

"Creo que los usuarios ven las líneas de luz de NSLS-II o los microscopios de CFN como poderosas herramientas de caracterización. Estamos tratando de convertir estas capacidades en una poderosa instalación de descubrimiento de materiales, "Dijo Fukuto.