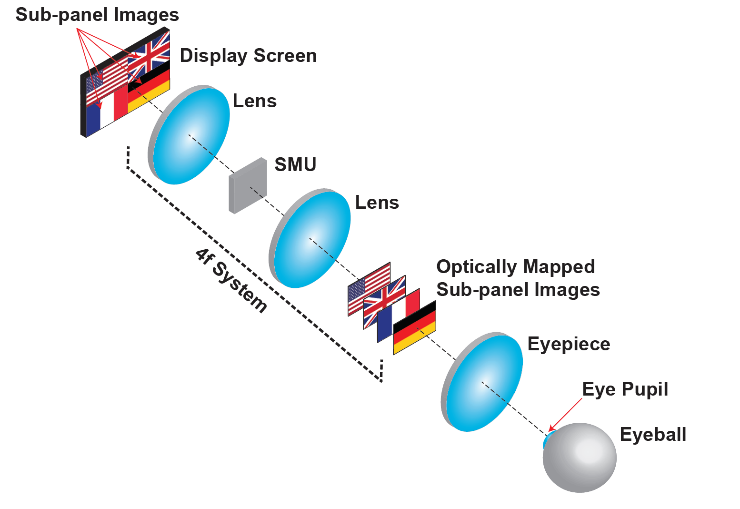

La nueva pantalla crea una imagen en 3-D utilizando mapeo óptico. Una pantalla OLED se divide en cuatro subpaneles, cada uno de los cuales crea una imagen en 2-D. La unidad de multiplexación espacial (SMU) desplazó cada una de estas imágenes a diferentes profundidades mientras alineaba los centros de todas las imágenes con el eje de visualización. A través del ocular cada imagen parece tener una profundidad diferente. Crédito:Liang Gao, de la Universidad de Illinois en Urbana-Champaign

Existe una gran emoción en torno a los auriculares de realidad virtual (VR) que muestran un mundo simulado por computadora y gafas de realidad aumentada (AR) que superponen elementos generados por computadora con el mundo real. Aunque los dispositivos AR y VR están comenzando a llegar al mercado, siguen siendo principalmente una novedad porque la fatiga ocular los hace incómodos de usar durante períodos prolongados. Un nuevo tipo de pantalla 3D podría resolver este problema de larga data mejorando en gran medida la comodidad de visualización de estos dispositivos portátiles.

"Queremos reemplazar los módulos de pantalla óptica AR y VR que se utilizan actualmente con nuestra pantalla 3D para eliminar los problemas de fatiga ocular, "dijo Liang Gao, de la Universidad de Illinois en Urbana-Champaign. "Nuestro método podría conducir a una nueva generación de pantallas 3D que se pueden integrar en cualquier tipo de gafas de realidad aumentada o gafas de realidad virtual".

Gao y Wei Cui informan sobre su nueva pantalla 3D de mapeo óptico en la revista The Optical Society (OSA) Letras de óptica . Mide solo 1 x 2 pulgadas, El nuevo módulo de visualización aumenta la comodidad de visualización al producir señales de profundidad que se perciben de la misma manera que vemos la profundidad en el mundo real.

Superar la fatiga ocular

Los cascos de realidad virtual y las gafas de realidad aumentada actuales presentan dos imágenes en 2D de una manera que indica al cerebro del espectador que combine las imágenes en la impresión de una escena en 3D. Este tipo de visualización estereoscópica provoca lo que se conoce como un conflicto de acomodación-vergencia, lo que con el tiempo dificulta al espectador fusionar las imágenes y provoca malestar y fatiga ocular.

La nueva pantalla presenta imágenes reales en 3D utilizando un enfoque llamado mapeo óptico. Esto se hace dividiendo una pantalla digital en subpaneles, cada uno de los cuales crea una imagen en 2D. Las imágenes del subpanel se desplazan a diferentes profundidades mientras que los centros de todas las imágenes se alinean entre sí. Esto hace que parezca que cada imagen tiene una profundidad diferente cuando un usuario mira a través del ocular. Los investigadores también crearon un algoritmo que combina las imágenes, para que las profundidades parezcan continuas, creando una imagen 3D unificada.

El componente clave del nuevo sistema es una unidad de multiplexación espacial que desplaza axialmente las imágenes del subpanel a las profundidades designadas mientras desplaza lateralmente los centros de las imágenes del subpanel al eje de visualización. En la configuración actual, la unidad de multiplexación espacial está compuesta por moduladores de luz espacial que modifican la luz según un algoritmo específico desarrollado por los investigadores.

Aunque el enfoque funcionaría con cualquier tecnología de visualización moderna, los investigadores utilizaron una pantalla de diodos emisores de luz orgánicos (OLED), una de las tecnologías de visualización más nuevas que se utilizará en televisores comerciales y dispositivos móviles. La resolución extremadamente alta disponible en la pantalla OLED aseguró que cada subpanel contuviera suficientes píxeles para crear una imagen clara.

"La gente ha probado métodos similares al nuestro para crear múltiples profundidades de plano, pero en lugar de crear varias imágenes de profundidad simultáneamente, cambiaron las imágenes muy rápido, "dijo Gao." Sin embargo, este enfoque viene con una compensación en el rango dinámico, o nivel de contraste, porque la duración de cada imagen que se muestra es muy corta ".

Creando señales de profundidad

Los investigadores probaron el dispositivo usándolo para mostrar una escena compleja de autos estacionados y colocando una cámara frente al ocular para registrar lo que vería el ojo humano. Demostraron que la cámara podía enfocar coches que parecían muy lejanos mientras que el primer plano permanecía desenfocado. Similar, la cámara podría enfocarse en los autos más cercanos mientras el fondo se veía borroso. Esta prueba confirmó que la nueva pantalla produce señales focales que crean una percepción de profundidad muy similar a la forma en que los humanos perciben la profundidad en una escena. Esta demostración se realizó en blanco y negro, pero los investigadores dicen que la técnica también podría usarse para producir imágenes en color, aunque con una resolución lateral reducida.

Los investigadores ahora están trabajando para reducir aún más el tamaño del sistema, peso y consumo de energía. "En el futuro, queremos reemplazar los moduladores de luz espacial con otro componente óptico, como una rejilla de holografía de volumen, "dijo Gao." Además de ser más pequeño, estas rejillas no consumen energía activamente, lo que haría que nuestro dispositivo fuera aún más compacto y aumentaría su idoneidad para auriculares de realidad virtual o gafas de realidad aumentada ".

Aunque los investigadores no tienen actualmente ningún socio comercial, están en conversaciones con empresas para ver si la nueva pantalla podría integrarse en futuros productos de AR y VR.