Una interfaz auditiva cerebro-computadora puede decir a qué hablante está prestando atención un oyente con una precisión de hasta el 80%, dependiendo del tiempo de análisis. Crédito:Souto et al. © 2016 IOP Publishing

(Phys.org) —Los investigadores están trabajando en las primeras etapas de una interfaz cerebro-computadora (BCI) que puede decir a quién estás escuchando en una habitación llena de ruido y otras personas hablando. En el futuro, la tecnología podría incorporarse a los audífonos como pequeños formadores de haz que apuntan en la dirección de interés para sintonizar ciertas conversaciones, sonidos o voces a las que un individuo está prestando atención, mientras se desconecta el ruido de fondo no deseado.

Los investigadores, Carlos da Silva Souto y coautores del Departamento de Física Médica y el Clúster de Excelencia Hearing4all de la Universidad de Oldenburg, han publicado un artículo sobre una prueba de concepto auditiva BCI en una edición reciente de Física e Ingeniería Biomédica Express .

Hasta aquí, la mayor parte de la investigación de BCI se ha centrado principalmente en los estímulos visuales, que actualmente supera a los sistemas que utilizan estímulos auditivos, posiblemente debido a la mayor superficie cortical del sistema visual en comparación con la corteza auditiva. Sin embargo, para personas con discapacidad visual o completamente paralizadas, El ICC basado en la audición podría ofrecer una alternativa potencial.

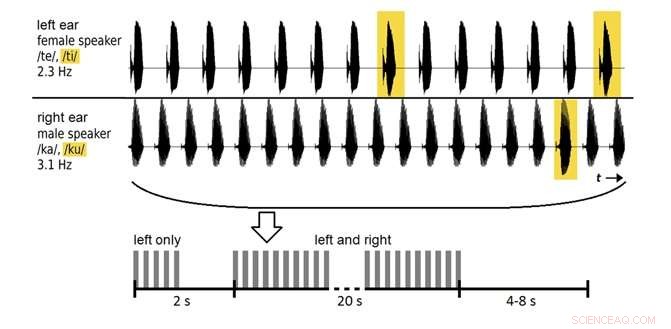

En el nuevo estudio, 12 voluntarios escucharon dos voces grabadas (una masculina, una mujer) hablando sílabas repetidas, y se les pidió que prestaran atención a solo una de las voces. En las primeras sesiones, Se utilizaron datos de electroencefalograma (EEG) sobre la actividad eléctrica del cerebro para entrenar a los participantes. En sesiones posteriores, Se probó el sistema para determinar la precisión con la que clasificaba los datos del EEG para determinar a qué voz estaba prestando atención el voluntario.

En primer lugar, el sistema clasificó los datos con aproximadamente un 60% de precisión, por encima del nivel de probabilidad, pero no lo suficientemente bueno para un uso práctico. Al aumentar el tiempo de análisis de 20 segundos a 2 minutos, los investigadores pudieron mejorar la precisión hasta casi el 80%. Aunque esta ventana de análisis es demasiado larga para situaciones de la vida real, y la precisión se puede mejorar aún más, los resultados se encuentran entre los primeros en mostrar que es posible clasificar los datos de EEG evocados a partir de sílabas habladas.

En el futuro, los investigadores planean optimizar los métodos de clasificación para mejorar aún más el rendimiento del sistema.

© 2017 Phys.org