Crédito:Márquez, Suarez-Vargas y Shastri.

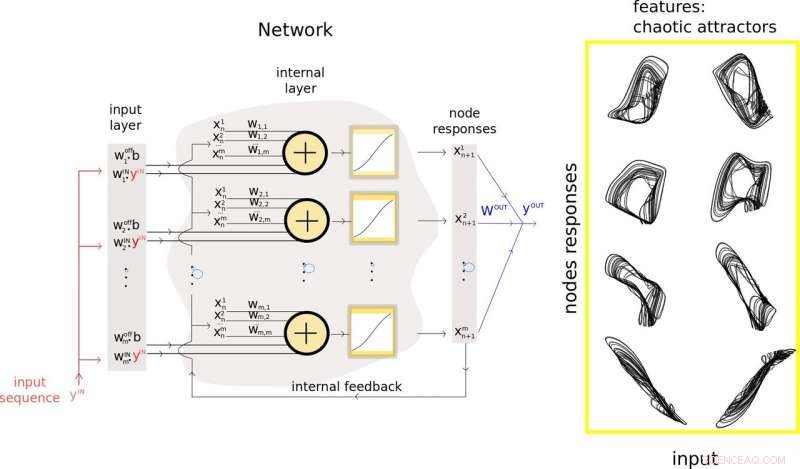

Un equipo de investigadores de la Queen's University, en Canadá, Recientemente propusieron un nuevo método para reducir el tamaño de las redes neuronales recurrentes aleatorias (rRNN), una clase de redes neuronales artificiales que se usa a menudo para hacer predicciones a partir de datos. Su enfoque presentado en un artículo publicado previamente en arXiv, permite a los desarrolladores minimizar la cantidad de neuronas en la capa oculta de un rRNN, mejorando consecuentemente su desempeño de predicción.

"Nuestro laboratorio se centra en el diseño de hardware para aplicaciones de inteligencia artificial, "Bicky Márquez, uno de los investigadores que realizó el estudio, dijo a TechXplore. "En este estudio, buscábamos estrategias para comprender los principios operativos de las redes neuronales, y al mismo tiempo, tratando de reducir la cantidad de neuronas en las redes que pretendíamos construir sin afectar negativamente su rendimiento a la hora de resolver una tarea. La principal tarea que queríamos abordar era la predicción, ya que esto siempre ha sido de gran interés para la comunidad científica y la sociedad en general ".

El desarrollo de herramientas de aprendizaje automático que pueden predecir patrones futuros a partir de datos se ha convertido en el foco clave de numerosos grupos de investigación en todo el mundo. Esto está lejos de ser sorprendente, ya que la predicción de eventos futuros podría tener aplicaciones importantes en una variedad de campos, por ejemplo, pronosticar el clima, predecir movimientos de stock, o cartografiar la evolución de algunas patologías humanas.

El estudio realizado por Márquez y sus colegas es de carácter interdisciplinario, a medida que fusiona teorías relacionadas con sistemas dinámicos no lineales, análisis de series temporales, y aprendizaje automático. Los objetivos principales de los investigadores eran ampliar el conjunto de herramientas previamente disponible para el análisis de redes neuronales, minimizar el número de neuronas en la capa oculta de rRNN, y eliminar parcialmente la propiedad de caja negra de estas redes.

Lograr esto, introdujeron una nueva metodología que fusiona la teoría de la predicción y el aprendizaje automático en un solo marco. Su técnica se puede utilizar para extraer y utilizar características relevantes de los datos de entrada de una rNN y guiar el proceso de reducción de sus capas ocultas. en última instancia, mejorando su rendimiento de predicción.

Los investigadores utilizaron los conocimientos recopilados en su estudio para desarrollar un nuevo modelo de red neuronal artificial llamado procesador inspirado en Takens. Este modelo, compuesto por neuronas reales y virtuales, logró un rendimiento de vanguardia en problemas desafiantes como alta calidad, predicción a largo plazo de señales caóticas.

"La principal ventaja de nuestro modelo es que aborda los problemas creados por la enorme cantidad de neuronas que componen las típicas redes neuronales artificiales, Márquez explicó. “El exceso de neuronas en estos modelos se traduce comúnmente en problemas computacionalmente costosos cuando se considera la optimización de tales redes para resolver una tarea. La inclusión del concepto de neuronas virtuales en nuestro diseño es un paso muy conveniente para la reducción de la cantidad de neuronas físicas ".

En su estudio, Márquez y sus colegas también usaron su procesador híbrido para estabilizar un modelo neuronal arrítmico de excitabilidad neuronal llamado Fitz-Hugh-Nagumo. Su metodología les permitió reducir el tamaño de la red neuronal estabilizadora en un factor de 15 en comparación con otras redes neuronales estándar.

"Nuestro enfoque nos permitió descubrir algunas características relevantes que se están creando dentro del espacio de las redes, y cuáles son los agentes fundamentales de las predicciones exitosas, ", Dijo Márquez." Si podemos identificar y eliminar el ruido alrededor de esas características importantes, podríamos utilizarlos para mejorar el rendimiento de nuestras redes ".

La metodología ideada por Márquez y sus colegas es una adición importante a las herramientas previamente disponibles para el desarrollo y análisis de rRNN. En el futuro, su enfoque podría informar el diseño de redes neuronales más efectivas para la predicción, reduciendo el número de nodos y conexiones que contienen. Su técnica también podría hacer que los rRNN sean más transparentes, permitiendo a los usuarios acceder a información clave sobre cómo un sistema ha llegado a una conclusión determinada.

"Estamos enfocados en hardware neuromórfico, "Dijo Márquez." Por lo tanto, Nuestros próximos pasos estarán relacionados con la implementación física de tales redes recurrentes aleatorias. Nuestro objetivo final es diseñar computadoras inspiradas en el cerebro que puedan resolver problemas de inteligencia artificial de manera muy eficiente:ultrarrápida y con bajo consumo de energía ".

© 2019 Science X Network