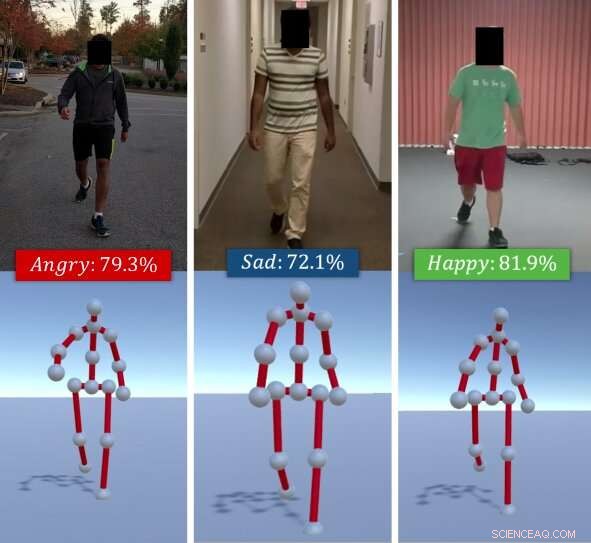

El algoritmo identifica las emociones percibidas de las personas en función de sus estilos de caminar. Dado un video RGB de un individuo caminando (arriba), El método de los investigadores extrae su forma de caminar como una serie de poses en 3D (abajo). Luego utiliza una combinación de características profundas aprendidas a través de un LSTM y características afectivas calculadas usando señales de postura y movimiento y las clasifica en emociones básicas (por ejemplo, contento, triste, etc.), utilizando un clasificador de bosque aleatorio. Crédito:Randhavane et al.

Un equipo de investigadores de la Universidad de Carolina del Norte en Chapel Hill y la Universidad de Maryland en College Park ha desarrollado recientemente un nuevo modelo de aprendizaje profundo que puede identificar las emociones de las personas en función de sus estilos de caminar. Su enfoque descrito en un artículo publicado previamente en arXiv, funciona extrayendo el paso de un individuo de un video RGB de él / ella caminando, luego analizándola y clasificándola como una de cuatro emociones:feliz, triste, enojado o neutral.

"Las emociones juegan un papel importante en nuestras vidas, definiendo nuestras experiencias, y dar forma a cómo vemos el mundo e interactuamos con otros humanos, "Tanmay Randhavane, uno de los investigadores principales y estudiante de posgrado de la UNC, dijo a TechXplore. "Percibir las emociones de otras personas nos ayuda a comprender su comportamiento y decidir nuestras acciones hacia ellos. Por ejemplo, las personas se comunican de manera muy diferente con alguien que perciben enojado y hostil que con alguien que perciben tranquilo y contento ".

La mayoría de las herramientas de identificación y reconocimiento de emociones existentes funcionan analizando expresiones faciales o grabaciones de voz. Sin embargo, estudios anteriores sugieren que el lenguaje corporal (p. ej., postura, movimientos etc.) también puede decir mucho sobre cómo se siente alguien. Inspirado por estas observaciones, los investigadores se propusieron desarrollar una herramienta que pueda identificar automáticamente la emoción percibida de las personas en función de su estilo de caminar.

"La principal ventaja de nuestro enfoque de reconocimiento de emociones percibidas es que combina dos técnicas diferentes, ", Dijo Randhavane." Además de utilizar el aprendizaje profundo, nuestro enfoque también aprovecha los hallazgos de los estudios psicológicos. Una combinación de ambas técnicas nos da una ventaja sobre los otros métodos ".

El enfoque primero extrae el modo de andar de una persona de un video RGB de ellos caminando, representándolo como una serie de poses 3-D. Después, Los investigadores utilizaron una red neuronal recurrente de memoria a largo plazo a corto plazo (LSTM) y un clasificador de bosque aleatorio (RF) para analizar estas poses e identificar la emoción más prominente que sentía la persona en el video. eligiendo entre la felicidad, tristeza, enojo o neutral.

El LSTM se entrena inicialmente en una serie de características profundas, pero estos se combinan más tarde con características afectivas calculadas a partir de los pasos utilizando señales de postura y movimiento. Todas estas características se clasifican en última instancia mediante el clasificador de RF.

Randhavane y sus colegas llevaron a cabo una serie de pruebas preliminares en un conjunto de datos que contenía videos de personas caminando y encontraron que su modelo podía identificar las emociones percibidas de las personas con un 80 por ciento de precisión. Además, su enfoque condujo a una mejora de aproximadamente el 14 por ciento sobre otros métodos de reconocimiento de emociones percibidas que se centran en el estilo de caminar de las personas.

"Aunque no hacemos ninguna afirmación sobre las emociones reales que experimenta una persona, nuestro enfoque puede proporcionar una estimación de la emoción percibida de ese estilo de caminar, "Aniket Bera, un profesor de investigación en el departamento de Ciencias de la Computación, supervisar la investigación, dijo a TechXplore. "Hay muchas aplicaciones para esta investigación, que van desde una mejor percepción humana de los robots y los vehículos autónomos hasta una mejor vigilancia y la creación de experiencias más atractivas en la realidad aumentada y virtual ".

Junto con Tanmay Randhavane y Aniket Bera, el equipo de investigación detrás de este estudio incluye a Dinesh Manocha y Uttaran Bhattacharya en la Universidad de Maryland en College Park, así como Kurt Gray y Kyra Kapsaskis del departamento de psicología de la Universidad de Carolina del Norte en Chapel Hill.

Para entrenar su modelo de aprendizaje profundo, los investigadores también han compilado un nuevo conjunto de datos llamado Emotion Walk (EWalk), que contiene videos de personas que caminan en ambientes interiores y exteriores etiquetados con emociones percibidas. En el futuro, Este conjunto de datos podría ser utilizado por otros equipos para desarrollar y entrenar nuevas herramientas de reconocimiento de emociones diseñadas para analizar el movimiento. postura, y / o marcha.

"Nuestra investigación se encuentra en una etapa muy primitiva, ", Dijo Bera." Queremos explorar diferentes aspectos del lenguaje corporal y observar más señales como las expresiones faciales, habla, patrones vocales, etc., y utilice un enfoque multimodal para combinar todas estas señales con los pasos. En la actualidad, asumimos que el movimiento de caminar es natural y no involucra ningún accesorio (por ejemplo, maleta, teléfonos móviles, etc.). Como parte del trabajo futuro, nos gustaría recopilar más datos y entrenar mejor nuestro modelo de aprendizaje profundo. También intentaremos ampliar nuestra metodología para considerar más actividades como correr, gesticulando, etc. "

Según Bera, Las herramientas de reconocimiento de emociones percibidas pronto podrían ayudar a desarrollar robots con navegación más avanzada, planificación, y habilidades de interacción. Además, modelos como el de ellos podrían usarse para detectar comportamientos anómalos o patrones de caminar a partir de videos o imágenes de CCTV, por ejemplo, identificar a las personas que están en riesgo de suicidio y alertar a las autoridades o proveedores de atención médica. Su modelo también podría aplicarse en la industria de VFX y animación, donde podría ayudar a los diseñadores y animadores a crear personajes virtuales que expresen eficazmente emociones particulares.

© 2019 Science X Network