En la página de Facebook de un usuario que se identifica como Nawan Al-Farancsa se muestra una pancarta que dice "El Estado Islámico". La página todavía estaba activa el martes, Mayo 7, 2019, cuando se hizo la captura de pantalla. Facebook dice que tiene sistemas robustos para eliminar contenido de grupos extremistas, pero la denuncia de un denunciante sellada revisada por la AP dice que el contenido prohibido permanece en la web y es fácil de encontrar. (Facebook vía AP)

El video animado comienza con una foto de las banderas negras de la yihad. Segundos más tarde, muestra lo más destacado de un año de publicaciones en las redes sociales:placas de versos antisemitas, habla de represalias y una foto de dos hombres portando más banderas yihadistas mientras queman las barras y estrellas.

No fue producido por extremistas; fue creado por Facebook. En una ingeniosa autopromoción, el gigante de las redes sociales toma un año del contenido de un usuario y genera automáticamente un video de celebración. En este caso, el usuario se llamó a sí mismo "Abdel-Rahim Moussa, el Califato ".

"Gracias por estar aqui, de Facebook, "el video concluye en una burbuja de dibujos animados antes de mostrar el famoso" pulgar hacia arriba "de la compañía.

A Facebook le gusta dar la impresión de que se está adelantando a los extremistas eliminando sus publicaciones. a menudo antes de que los usuarios los vean. Pero la denuncia de un denunciante confidencial a la Comisión de Bolsa y Valores obtenida por The Associated Press alega que la empresa de medios sociales ha exagerado su éxito. Peor aún, muestra que la compañía está haciendo uso inadvertidamente de la propaganda de los grupos militantes para generar automáticamente videos y páginas que los extremistas podrían utilizar para establecer contactos.

Según la denuncia, durante un período de cinco meses el año pasado, Los investigadores monitorearon las páginas de los usuarios que se afiliaron a grupos que el Departamento de Estado de EE. UU. ha designado como organizaciones terroristas. En ese período, Se eliminó el 38% de las publicaciones con símbolos prominentes de grupos extremistas. En su propia reseña, AP descubrió que, a partir de este mes, gran parte del contenido prohibido citado en el estudio:un video de ejecución, imágenes de cabezas cortadas, la propaganda en honor a los militantes martirizados se deslizó a través de la web algorítmica y siguió siendo fácil de encontrar en Facebook.

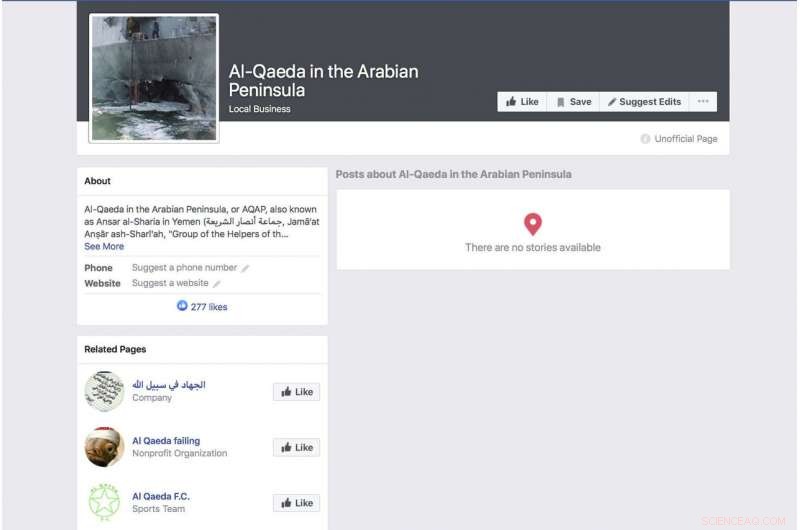

Una página de Facebook generada automáticamente para un grupo que se identifica como el grupo terrorista "Al-Qaeda en la Península Arábiga" muestra una foto del buque de guerra USS Cole de la Armada estadounidense bombardeado. La página todavía estaba activa el martes, Mayo 7, 2019, cuando se hizo la captura de pantalla. Facebook dice que tiene sistemas robustos para eliminar contenido de grupos extremistas, pero la denuncia de un denunciante sellada revisada por la AP dice que el contenido prohibido permanece en la web y es fácil de encontrar. (Facebook vía AP)

La queja está aterrizando mientras Facebook intenta adelantarse a una creciente variedad de críticas sobre sus prácticas de privacidad y su capacidad para mantener el discurso de odio. asesinatos y suicidios transmitidos en vivo fuera de su servicio. Frente a las críticas, El director ejecutivo, Mark Zuckerberg, ha hablado de su orgullo por la capacidad de la empresa para eliminar las publicaciones violentas automáticamente a través de la inteligencia artificial. Durante una llamada de ingresos el mes pasado, por ejemplo, repitió una formulación cuidadosamente redactada que Facebook ha estado empleando.

"En áreas como el terrorismo, para contenido relacionado con al-Qaida e ISIS, ahora, el 99 por ciento del contenido que eliminamos en la categoría que nuestros sistemas marcan de manera proactiva antes de que alguien lo vea, ", dijo. Luego agregó:" Así es como se ve realmente bien ".

Zuckerberg no ofreció una estimación de la cantidad total de material prohibido que se está eliminando.

La investigación detrás de la queja de la SEC tiene como objetivo resaltar fallas evidentes en el enfoque de la empresa. El año pasado, Los investigadores comenzaron a monitorear a los usuarios que se identificaban explícitamente como miembros de grupos extremistas. No fue difícil de documentar. Algunas de estas personas incluso enumeran a los grupos extremistas como sus empleadores. Un perfil anunciado por la bandera negra de un grupo afiliado a al-Qaida incluía a su empleador, quizás en broma, como Facebook. El perfil que incluía el video generado automáticamente con la bandera encendida también tenía un video del líder de al-Qaida Ayman al-Zawahiri instando a los grupos yihadistas a no luchar entre ellos.

Si bien el estudio está lejos de ser exhaustivo, en parte porque Facebook rara vez pone muchos de sus datos a disposición del público, los investigadores involucrados en el proyecto dicen que la facilidad para identificar estos perfiles mediante una búsqueda básica de palabras clave y el hecho de que se hayan eliminado tan pocos de ellos sugieren que las afirmaciones de Facebook de que sus sistemas captan la mayor parte del contenido extremista no son precisas.

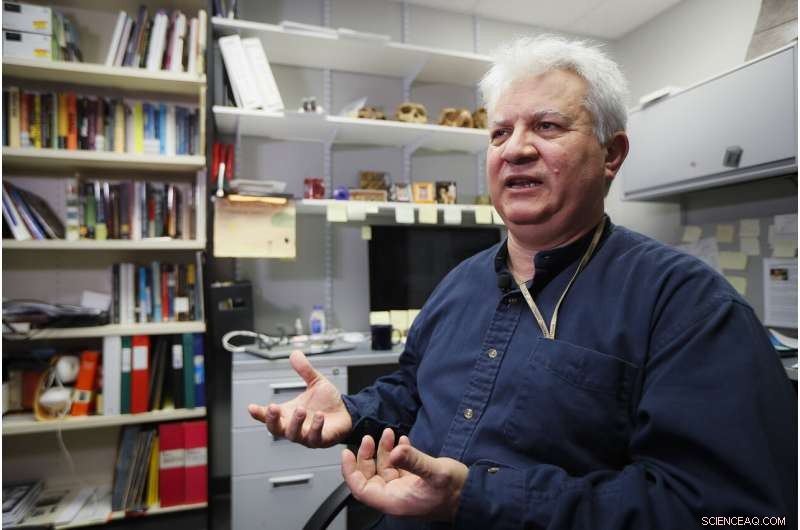

Amr Al Azm, profesor de Historia y Antropología de Oriente Medio en la Universidad Estatal de Shawnee, habla en su oficina el 25 de abril, 2019, en Portsmouth, Ohio. Facebook da la impresión de que está deteniendo la gran mayoría de las publicaciones extremistas antes de que los usuarios las vean. Pero la denuncia de un denunciante confidencial a la Comisión de Bolsa y Valores obtenida por The Associated Press alega que la empresa de medios sociales ha exagerado su éxito. "Quiero decir, eso es solo estirar la imaginación más allá de la incredulidad, " dice, Al Azm uno de los investigadores implicados en el proyecto. "Si un pequeño grupo de investigadores puede encontrar cientos de páginas de contenido mediante búsquedas simples, ¿Por qué no puede hacerlo una empresa gigante con todos sus recursos? "(AP Photo / John Minchillo)

"Quiero decir, eso es solo estirar la imaginación más allá de la incredulidad, "dice Amr Al Azm, uno de los investigadores involucrados en el proyecto. "Si un pequeño grupo de investigadores puede encontrar cientos de páginas de contenido mediante búsquedas simples, ¿Por qué no puede hacerlo una empresa gigante con todos sus recursos? "

Al Azm, profesor de historia y antropología en la Universidad Estatal de Shawnee en Ohio, También ha dirigido un grupo en Siria que documenta el saqueo y el contrabando de antigüedades.

Facebook admite que sus sistemas no son perfectos, pero dice que está haciendo mejoras.

"Después de realizar grandes inversiones, estamos detectando y eliminando contenido de terrorismo con una tasa de éxito mucho mayor que hace dos años, ", dijo la compañía en un comunicado." No pretendemos encontrar todo y nos mantenemos alerta en nuestros esfuerzos contra los grupos terroristas en todo el mundo ".

Reaccionando a los informes de AP, Representante Bennie Thompson, D-señorita., el presidente del Comité de Seguridad Nacional de la Cámara de Representantes expresó su frustración de que Facebook haya avanzado tan poco en el bloqueo de contenido a pesar de las garantías que recibió de la compañía.

Una página de Facebook para el usuario Ramadan Kareem, que cuando se traduce al inglés indica que el usuario trabaja en "Estado Islámico en Sham e Irak". La página todavía estaba activa el martes, Mayo 7, 2019, cuando se hizo la captura de pantalla. Facebook dice que tiene sistemas robustos para eliminar contenido de grupos extremistas, pero la denuncia de un denunciante sellada revisada por la AP dice que el contenido prohibido permanece en la web y es fácil de encontrar. (Facebook vía AP)

"Este es otro ejemplo profundamente preocupante de la incapacidad de Facebook para administrar sus propias plataformas, y hasta qué punto necesita limpiar su actuación". ", dijo." Facebook no solo debe deshacerse de sus plataformas de contenido terrorista y extremista, pero también debe poder evitar que se amplifique ".

Pero como una clara indicación de la facilidad con la que los usuarios pueden evadir Facebook, una página de un usuario llamado "Nawan al-Farancsa" tiene un encabezado cuyas letras blancas sobre un fondo negro dicen en inglés "El Estado Islámico". La pancarta está salpicada con una foto de una nube en forma de hongo explosiva que se eleva desde una ciudad.

El perfil debería haber llamado la atención de Facebook, así como de las agencias de contrainteligencia. Fue creado en junio de 2018, enumera al usuario como procedente de Chechenia, una vez un punto de acceso militante. Dice que vivió en Heidelberg, Alemania, y estudió en una universidad en Indonesia. Algunos de los amigos del usuario también publicaron contenido militante.

La página, todavía en los últimos días, aparentemente escapó de los sistemas de Facebook, debido a una evasión de moderación obvia y de larga duración que Facebook debería ser experto en reconocer:las letras no eran texto que se pudiera buscar, sino que estaban incrustadas en un bloque gráfico. Pero la compañía dice que su tecnología escanea audio, vídeo y texto, incluso cuando están incrustados, para imágenes que reflejan violencia, armas o logotipos de grupos prohibidos.

El gigante de las redes sociales ha soportado dos años difíciles a partir de 2016, cuando se enfocó el uso de las redes sociales por parte de Rusia para inmiscuirse en las elecciones presidenciales de Estados Unidos. Zuckerberg inicialmente restó importancia al papel que desempeñó Facebook en la operación de influencia de la inteligencia rusa. pero la empresa se disculpó más tarde.

Una página de Facebook para un usuario que se traduce al inglés como "Luces de amargura" que enumera al usuario como médico del Estado Islámico. La página todavía estaba activa el martes, Mayo 7, 2019, cuando se hizo la captura de pantalla. Facebook dice que tiene sistemas robustos para eliminar contenido de grupos extremistas, pero la denuncia de un denunciante revisada por la AP dice que el contenido prohibido permanece en la web y es fácil de encontrar. (Facebook vía AP)

Facebook dice que ahora emplea a 30, 000 personas que trabajan en sus prácticas de seguridad y protección, revisar material potencialmente dañino y cualquier otra cosa que no pertenezca al sitio. Todavía, la compañía está depositando mucha fe en la inteligencia artificial y la capacidad de sus sistemas para eventualmente eliminar las cosas malas sin la ayuda de los humanos. La nueva investigación sugiere que el objetivo está muy lejos y algunos críticos alegan que la empresa no está haciendo un esfuerzo sincero.

Cuando no se quita el material, se trata de la misma manera que cualquier otra publicación de los 2.400 millones de usuarios de Facebook:se celebra en videos animados, enlazados y categorizados y recomendados por algoritmos.

Pero no son solo los algoritmos los culpables. Los investigadores encontraron que algunos extremistas están usando "Frame Studio" de Facebook para publicar propaganda militante. La herramienta permite a las personas decorar sus fotos de perfil dentro de marcos gráficos, para apoyar causas o celebrar cumpleaños, por ejemplo. Facebook dice que esas imágenes enmarcadas deben ser aprobadas por la empresa antes de que se publiquen.

Hany Farid, un experto en análisis forense digital de la Universidad de California, Berkeley, quien asesora al Proyecto Contra el Extremismo, un grupo con sede en Nueva York y Londres centrado en combatir los mensajes extremistas, dice que el sistema de inteligencia artificial de Facebook está fallando. Dice que la empresa no está motivada para abordar el problema porque sería costoso.

"Toda la infraestructura tiene fallas fundamentales, ", dijo." Y hay muy poco apetito para arreglarlo porque lo que Facebook y las otras compañías de redes sociales saben es que una vez que comienzan a ser responsables del material en sus plataformas, se abre una lata de gusanos ".

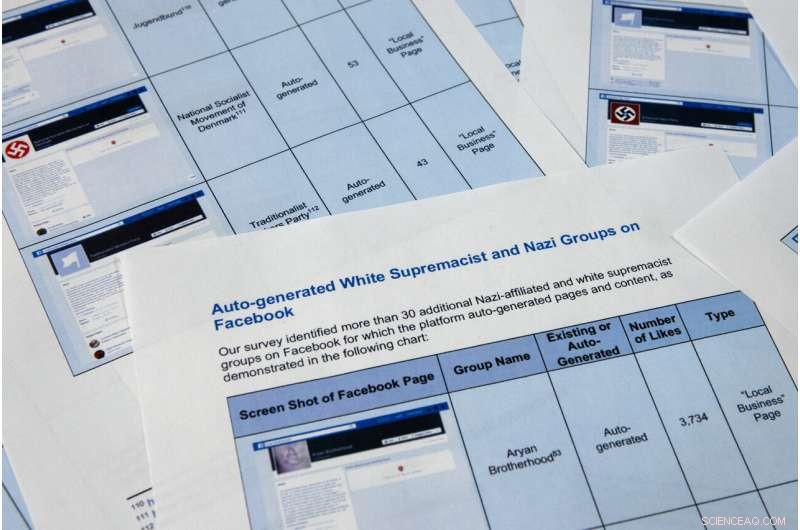

Las páginas del informe confidencial de un denunciante obtenido por The Associated Press se fotografiaron el martes, Mayo 7, 2019, en Washington. A Facebook le gusta dar la impresión de que está deteniendo la gran mayoría de las publicaciones extremistas antes de que los usuarios las vean. pero la denuncia del denunciante confidencial ante la Comisión de Bolsa y Valores alega que la empresa de medios sociales ha exagerado su éxito. Peor aún, muestra que la compañía está haciendo uso de la propaganda de grupos militantes para generar automáticamente videos y páginas que los extremistas podrían utilizar para establecer contactos. (Foto AP / Jon Elswick)

Las páginas del informe confidencial de un denunciante obtenido por The Associated Press se fotografiaron el martes, Mayo 7, 2019, en Washington. A Facebook le gusta dar la impresión de que está deteniendo la gran mayoría de las publicaciones extremistas antes de que los usuarios las vean. pero la denuncia del denunciante confidencial ante la Comisión de Bolsa y Valores alega que la empresa de medios sociales ha exagerado su éxito. Peor aún, muestra que la compañía está haciendo uso de la propaganda de grupos militantes para generar automáticamente videos y páginas que los extremistas podrían utilizar para establecer contactos. Los investigadores en la denuncia de la SEC identificaron más de 30 páginas generadas automáticamente para grupos de supremacistas blancos, cuyo contenido Facebook prohíbe. (Foto AP / Jon Elswick)

En este 11 de abril 2018, foto de archivo, El director ejecutivo de Facebook, Mark Zuckerberg, testifica ante una audiencia de Energía y Comercio de la Cámara de Representantes en Capitol Hill en Washington. Facebook da la impresión de que está deteniendo la gran mayoría de las publicaciones extremistas antes de que los usuarios las vean. Pero la denuncia de un denunciante confidencial a la Comisión de Bolsa y Valores obtenida por The Associated Press alega que la empresa de medios sociales ha exagerado su éxito. (Foto AP / Andrew Harnik, Expediente)

Otra función de generación automática de Facebook que salió mal elimina la información de empleo de las páginas del usuario para crear páginas comerciales. Se supone que la función produce páginas destinadas a ayudar a las empresas a establecer contactos, pero en muchos casos sirven como un espacio de aterrizaje de marca para grupos extremistas. La función permite a los usuarios de Facebook dar me gusta a páginas de organizaciones extremistas, incluyendo al-Qaida, el grupo Estado Islámico y al-Shabab, con sede en Somalia, proporcionando efectivamente una lista de simpatizantes para los reclutadores.

At the top of an auto-generated page for al-Qaida in the Arabian Peninsula, the AP found a photo of the damaged hull of the USS Cole, which was bombed by al-Qaida in a 2000 attack off the coast of Yemen that killed 17 U.S. Navy sailors. It's the defining image in AQAP's own propaganda. The page includes the Wikipedia entry for the group and had been liked by 277 people when last viewed this week.

As part of the investigation for the complaint, Al Azm's researchers in Syria looked closely at the profiles of 63 accounts that liked the auto-generated page for Hay'at Tahrir al-Sham, a group that merged from militant groups in Syria, including the al-Qaida affiliated al-Nusra Front. The researchers were able to confirm that 31 of the profiles matched real people in Syria. Some of them turned out to be the same individuals Al Azm's team was monitoring in a separate project to document the financing of militant groups through antiquities smuggling.

Facebook also faces a challenge with U.S. hate groups. En marzo, the company announced that it was expanding its prohibited content to also include white nationalist and white separatist content— previously it only took action with white supremacist content. It says that it has banned more than 200 white supremacist groups. But it's still easy to find symbols of supremacy and racial hatred.

The researchers in the SEC complaint identified over 30 auto-generated pages for white supremacist groups, whose content Facebook prohibits. They include "The American Nazi Party" and the "New Aryan Empire." A page created for the "Aryan Brotherhood Headquarters" marks the office on a map and asks whether users recommend it. One endorser posted a question:"How can a brother get in the house."

A Facebook page for an auto generated Facebook page for a local business, translated into English from Arabic, calling itself 'Islamic State in Sham and Iraq. The page was still live as of Tuesday, Mayo 7, 2019, when the screen grab was made. Facebook says it has robust systems in place to remove content from extremist groups, but a sealed whistleblower's complaint reviewed by the AP says banned content remains on the web and easy to find. (Facebook vía AP)

Even supremacists flagged by law enforcement are slipping through the net. Following a sweep of arrests beginning in October, federal prosecutors in Arkansas indicted dozens of members of a drug trafficking ring linked to the New Aryan Empire. A legal document from February paints a brutal picture of the group, alleging murder, kidnapping and intimidation of witnesses that in one instance involved using a searing-hot knife to scar someone's face. It also alleges the group used Facebook to discuss New Aryan Empire business.

But many of the individuals named in the indictment have Facebook pages that were still up in recent days. They leave no doubt of the users' white supremacist affiliation, posting images of Hitler, swastikas and a numerical symbol of the New Aryan Empire slogan, "To The Dirt"—the members' pledge to remain loyal to the end. One of the group's indicted leaders, Jeffrey Knox, listed his job as "stomp down Honky." Facebook then auto-generated a "stomp down Honky" business page.

Social media companies have broad protection in U.S. law from liability stemming from the content that users post on their sites. But Facebook's role in generating videos and pages from extremist content raises questions about exposure. Legal analysts contacted by the AP differed on whether the discovery could open the company up to lawsuits.

At a minimum, the research behind the SEC complaint illustrates the company's limited approach to combatting online extremism. The U.S. State Department lists dozens of groups as "designated foreign terrorist organizations" but Facebook in its public statements says it focuses its efforts on two, the Islamic State group and al-Qaida. But even with those two targets, Facebook's algorithms often miss the names of affiliated groups. Al Azm says Facebook's method seems to be less effective with Arabic script.

Por ejemplo, a search in Arabic for "Al-Qaida in the Arabian Peninsula" turns up not only posts, but an auto-generated business page. One user listed his occupation as "Former Sniper" at "Al-Qaida in the Arabian Peninsula" written in Arabic. Another user evaded Facebook's cull by reversing the order of the countries in the Arabic for ISIS or "Islamic State of Iraq and Syria."

Amr Al Azm, a professor of Middle East History and Anthropology at Shawnee State University, speaks at his office on April 25, 2019, in Portsmouth, Ohio. Facebook gives the impression that it's stopping the vast majority of extremist posts before users ever see them. But a confidential whistleblower's complaint to the Securities and Exchange Commission obtained by The Associated Press alleges the social media company has exaggerated its success. "I mean that's just stretching the imagination to beyond incredulity, " dice, Al Azm one of the researchers involved in the project. "If a small group of researchers can find hundreds of pages of content by simple searches, why can't a giant company with all its resources do it?" (AP Photo/John Minchillo)

John Kostyack, a lawyer with the National Whistleblower Center in Washington who represents the anonymous plaintiff behind the complaint, said the goal is to make Facebook take a more robust approach to counteracting extremist propaganda.

"Right now we're hearing stories of what happened in New Zealand and Sri Lanka—just heartbreaking massacres where the groups that came forward were clearly openly recruiting and networking on Facebook and other social media, " he said. "That's not going to stop unless we develop a public policy to deal with it, unless we create some kind of sense of corporate social responsibility."

Farid, the digital forensics expert, says that Facebook built its infrastructure without thinking through the dangers stemming from content and is now trying to retrofit solutions.

"The policy of this platform has been:'Move fast and break things.' I actually think that for once their motto was actually accurate, " he says. "The strategy was grow, grow, grow, profit, profit, profit and then go back and try to deal with whatever problems there are."

© 2019 The Associated Press. Reservados todos los derechos.