El odio en línea todavía se enfurece, a menudo a plena vista. Crédito:maxicam / Shutterstock.com

Poco después del tiroteo en la sinagoga de Pittsburgh, Noté que la palabra "judíos" era tendencia en Twitter. Como investigador y educador de redes sociales, Me preocupó que la violencia se extendiera en línea, como lo ha hecho en el pasado.

La actividad del presunto tirador de la sinagoga en el sitio de redes sociales de Gab ha llamado la atención sobre el papel de ese sitio como una alternativa llena de odio a las opciones más convencionales como Facebook y Twitter. Esas se encuentran entre las plataformas de redes sociales que han prometido luchar contra el discurso de odio y el abuso en línea en sus sitios.

Sin embargo, mientras exploraba la actividad en línea tras el tiroteo, Rápidamente me quedó claro que los problemas no son solo en sitios como Gab. Bastante, el discurso de odio sigue siendo fácil de encontrar en los principales sitios de redes sociales, incluido Twitter. También identifiqué algunos pasos adicionales que la empresa podría tomar.

Respuestas incompletas a nuevos términos de odio

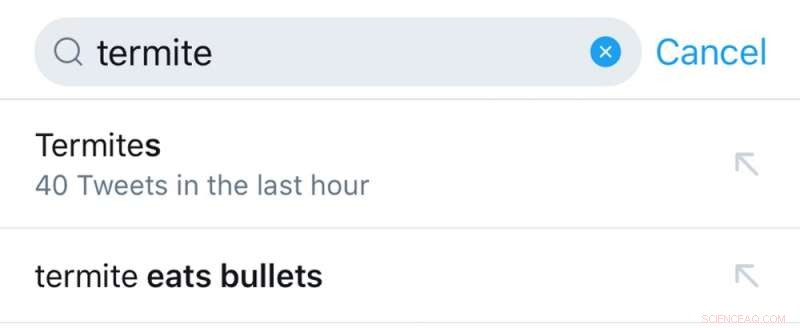

Esperaba que aparecieran nuevas amenazas en línea en torno al tiroteo en Pittsburgh, y había señales de que estaba sucediendo. En un reciente ataque antisemita, El líder de la Nación del Islam, Louis Farrakhan, usó la palabra "termita" para describir al pueblo judío. Busqué este término sabiendo que es probable que los racistas usen el nuevo insulto como palabra clave para evitar ser detectados cuando expresan antisemitismo.

Twitter no había suspendido la cuenta de Farrakhan a raíz de otra de sus declaraciones antisemitas, y la función de búsqueda de Twitter sugirió automáticamente que podría estar buscando la frase "la termita come balas". Eso convierte el cuadro de búsqueda de Twitter en una valla publicitaria de incitación al odio.

La empresa tenia, sin embargo, aparentemente ajustó algunos de sus algoritmos internos, porque no aparecieron tweets con usos antisemitas de la palabra "termita" en mis resultados de búsqueda.

Crédito:Jennifer Grygiel, CC BY-ND

Publicaciones desapercibidas durante años

Mientras continuaba mis búsquedas de discursos de odio y llamamientos a la violencia contra el pueblo judío, Encontré evidencia aún más inquietante de deficiencias en el sistema de moderación de contenido de Twitter. A raíz de las elecciones estadounidenses de 2016 y el descubrimiento de que Twitter se estaba utilizando para influir en las elecciones, la compañía dijo que estaba invirtiendo en aprendizaje automático para "detectar y mitigar el efecto en los usuarios de la falsificación, coordinado, y actividad automatizada de la cuenta ". Según lo que encontré, estos sistemas no han identificado ni siquiera muy simple, amenazas violentas claras y directas y discursos de odio que han estado en su sitio durante años.

Cuando informé de un tweet publicado en 2014 que abogaba por matar judíos "por diversión, "Twitter lo eliminó el mismo día, pero su aviso automático estándar de Twitter no dio ninguna explicación de por qué se había dejado intacto durante más de cuatro años.

Odio los juegos del sistema

Cuando revisé tweets de odio que no habían sido captados después de todos esos años, Noté que muchos no contenían texto:el tweet era solo una imagen. Sin texto, los tweets son más difíciles para los usuarios, y los propios algoritmos de identificación del odio de Twitter, encontrar. Pero los usuarios que buscan específicamente discursos de incitación al odio en Twitter pueden desplazarse por la actividad de las cuentas que encuentren. ver mensajes aún más llenos de odio.

Twitter parece ser consciente de este problema:a los usuarios que informan de un tweet se les pide que revisen algunos otros tweets de la misma cuenta y los envíen al mismo tiempo. Esto termina sometiendo más contenido a revisión, pero aún deja espacio para que algunos pasen desapercibidos.

Ayuda para gigantes tecnológicos en apuros

Cuando encontré tweets que pensé que violaban las políticas de Twitter, Les informé. La mayoría de ellos se eliminaron rápidamente, incluso dentro de una hora. Pero algunas publicaciones obviamente ofensivas tardaron varios días en publicarse. Todavía hay algunos tweets basados en texto que no se han eliminado, a pesar de violar claramente las políticas de Twitter. Eso demuestra que el proceso de revisión de contenido de la empresa no es coherente.

Un ejemplo de un tweet de odio al que se le permitió permanecer en Twitter durante más de cuatro años. Crédito:Jennifer Grygiel, CC BY-ND

Puede parecer que Twitter está mejorando en la eliminación de contenido dañino y que está eliminando una gran cantidad de contenido y memes y suspendiendo cuentas. pero gran parte de esa actividad no está relacionada con la incitación al odio. Bastante, gran parte de la atención de Twitter se ha centrado en lo que la empresa llama "manipulación coordinada, "como bots y redes de perfiles falsos administrados por unidades de propaganda del gobierno.

En mi opinión, la empresa podría dar un paso importante para solicitar la ayuda de miembros del público, así como investigadores y expertos como mis colegas y yo, para identificar contenido que incite al odio. Es común que las empresas de tecnología, incluida Twitter, ofrezcan pagos a las personas que informan sobre vulnerabilidades de seguridad en su software. Sin embargo, todo lo que la empresa hace para los usuarios que informan de contenido problemático es enviar un mensaje generado automáticamente diciendo "gracias". La disparidad en la forma en que Twitter trata los problemas de código y los informes de contenido transmite un mensaje de que la empresa prioriza su tecnología sobre su comunidad.

En lugar de, Twitter podría pagar a las personas por denunciar contenido que infrinja las pautas de la comunidad. ofreciendo recompensas económicas por eliminar las vulnerabilidades sociales de su sistema, como si esos usuarios lo ayudaran a identificar problemas de software o hardware. Un ejecutivo de Facebook expresó su preocupación de que esta posible solución podría ser contraproducente y generar más odio en línea. pero creo que el programa de recompensas podría estructurarse y diseñarse de manera que se evite ese problema.

Mucho más por hacer

Hay más problemas con Twitter que van más allá de lo que se publica directamente en su propio sitio. Las personas que publican discursos de odio a menudo aprovechan una característica clave de Twitter:la capacidad de los tweets para incluir enlaces a otros contenidos de Internet. Esa función es fundamental para la forma en que la gente usa Twitter, compartir contenido de interés mutuo de toda la web. Pero también es un método para distribuir discursos de odio.

Por ejemplo, un tweet puede parecer totalmente inocente, diciendo "Esto es gracioso" y proporcionando un enlace. Pero el enlace, al contenido que no se publica en los servidores de Twitter, muestra un mensaje lleno de odio.

Además, El sistema de moderación de contenido de Twitter solo permite a los usuarios reportar tweets amenazantes y de odio, pero no cuentas cuyos perfiles contienen mensajes similares. Algunas de estas cuentas, incluidas las que tienen fotos de perfil de Adolf Hitler, y nombres y nombres de usuarios de Twitter que abogan por la quema de judíos; ni siquiera publiquen tweets o sigan a otros usuarios de Twitter. A veces, simplemente existen para encontrarlas cuando las personas buscan palabras en sus perfiles, convirtiendo nuevamente el cuadro de búsqueda de Twitter en un sistema de entrega. Estas cuentas también pueden, aunque es imposible saberlo, usarse para comunicarse con otras personas en Twitter a través de mensajes directos, utilizando la plataforma como un canal de comunicación encubierto.

Sin tweets u otra actividad pública, Es imposible que los usuarios denuncien estas cuentas a través del sistema de informes de contenido estándar. Pero son igualmente ofensivos y dañinos, y deben ser evaluados y moderados al igual que el resto del contenido del sitio. A medida que las personas que buscan difundir el odio se vuelven cada vez más sofisticadas, Las pautas de la comunidad de Twitter, pero lo que es más importante, sus esfuerzos de cumplimiento, deben ponerse al día, y mantente al día.

Si los sitios de redes sociales quieren evitar convertirse, o permanecer, en vectores de guerras de información y plagas de ideas y memes de odio, necesitan intensificar de forma mucho más activa y, por lo menos, Haga que sus miles de empleados de moderación de contenido a tiempo completo busquen como lo hacía un profesor durante el transcurso de un fin de semana.

Este artículo se ha vuelto a publicar de The Conversation con una licencia de Creative Commons. Lea el artículo original.