Como robots, Los automóviles autónomos y otras máquinas inteligentes incorporan la IA a la vida cotidiana, una nueva forma de diseñar algoritmos puede ayudar a los desarrolladores de aprendizaje automático a crear salvaguardas contra resultados indeseables como prejuicios raciales y de género. Crédito:Deboki Chakravarti

La inteligencia artificial se ha convertido en la corriente principal comercial gracias a la creciente destreza de los algoritmos de aprendizaje automático que permiten a las computadoras entrenarse para hacer cosas como conducir automóviles, controlar robots o automatizar la toma de decisiones.

Pero a medida que la IA comienza a manejar tareas sensibles, como ayudar a elegir qué prisioneros obtienen la fianza, los responsables de la formulación de políticas insisten en que los científicos informáticos ofrezcan garantías de que los sistemas automatizados se han diseñado para minimizar, si no lo evita por completo, resultados no deseados como riesgo excesivo o prejuicios raciales y de género.

Un equipo dirigido por investigadores de Stanford y la Universidad de Massachusetts Amherst publicó un artículo el 22 de noviembre en Ciencias sugiriendo cómo proporcionar tales garantías. El documento describe una nueva técnica que traduce un objetivo difuso, como evitar el sesgo de género, en los criterios matemáticos precisos que permitirían a un algoritmo de aprendizaje automático entrenar una aplicación de inteligencia artificial para evitar ese comportamiento.

"Queremos promover una IA que respete los valores de sus usuarios humanos y justifique la confianza que depositamos en los sistemas autónomos, "dijo Emma Brunskill, profesor asistente de informática en Stanford y autor principal del artículo.

Evitando la mala conducta

El trabajo se basa en la noción de que si los resultados o comportamientos "inseguros" o "injustos" pueden definirse matemáticamente, entonces debería ser posible crear algoritmos que puedan aprender de los datos sobre cómo evitar estos resultados no deseados con gran confianza. Los investigadores también querían desarrollar un conjunto de técnicas que facilitaran a los usuarios especificar qué tipo de comportamiento no deseado quieren restringir y permitir que los diseñadores de aprendizaje automático predigan con confianza que un sistema entrenado con datos pasados puede ser confiable cuando se aplica en circunstancias del mundo real.

"Mostramos cómo los diseñadores de algoritmos de aprendizaje automático pueden facilitar que las personas que desean incorporar IA en sus productos y servicios describan resultados o comportamientos no deseados que el sistema de IA evitará con alta probabilidad, "dijo Philip Thomas, profesor asistente de informática en la Universidad de Massachusetts Amherst y primer autor del artículo.

Equidad y seguridad

Los investigadores probaron su enfoque tratando de mejorar la imparcialidad de los algoritmos que predicen los GPA de los estudiantes universitarios en función de los resultados de los exámenes. una práctica común que puede resultar en prejuicios de género. Usando un conjunto de datos experimental, le dieron a su algoritmo instrucciones matemáticas para evitar desarrollar un método predictivo que sobrestimó o subestimó sistemáticamente los GPA para un género. Con estas instrucciones, el algoritmo identificó una mejor manera de predecir los GPA de los estudiantes con un sesgo de género mucho menos sistemático que los métodos existentes. Los métodos anteriores tenían problemas a este respecto, ya sea porque no tenían un filtro de equidad incorporado o porque los algoritmos desarrollados para lograr la equidad tenían un alcance demasiado limitado.

El grupo desarrolló otro algoritmo y lo utilizó para equilibrar la seguridad y el rendimiento en una bomba de insulina automatizada. Estas bombas deben decidir qué tan grande o pequeña es la dosis de insulina que se debe administrar al paciente a la hora de las comidas. Idealmente, la bomba administra suficiente insulina para mantener estables los niveles de azúcar en sangre. Muy poca insulina permite que los niveles de azúcar en sangre aumenten, dando lugar a molestias a corto plazo como náuseas, y riesgo elevado de complicaciones a largo plazo, incluida la enfermedad cardiovascular. Demasiado y el azúcar en la sangre cae, un resultado potencialmente mortal.

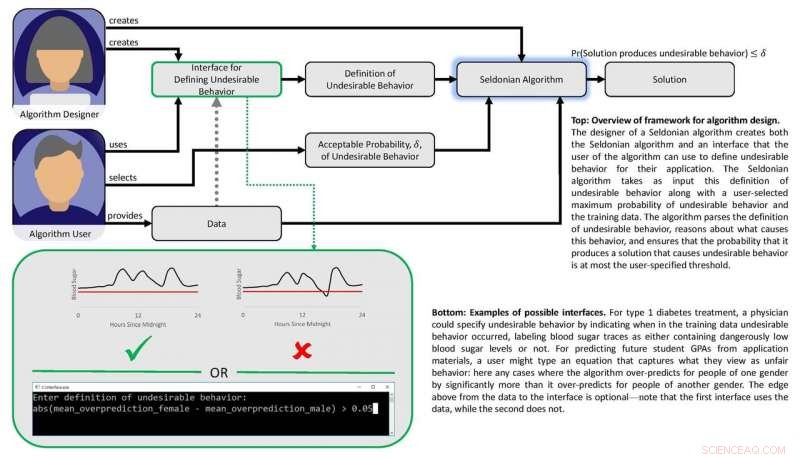

Diagrama que representa el marco del papel. Crédito:Philip Thomas

El aprendizaje automático puede ayudar a identificar patrones sutiles en las respuestas de azúcar en sangre de un individuo a las dosis, pero los métodos existentes no facilitan a los médicos la especificación de resultados que los algoritmos de dosificación automáticos deben evitar, como caídas de azúcar en la sangre. Usando un simulador de glucosa en sangre, Brunskill y Thomas mostraron cómo se pueden entrenar las bombas para identificar la dosificación adaptada para esa persona, evitando complicaciones por dosis excesivas o insuficientes. Aunque el grupo no está preparado para probar este algoritmo en personas reales, apunta a un enfoque de IA que eventualmente podría mejorar la calidad de vida de los diabéticos.

En su Ciencias papel, Brunskill y Thomas utilizan el término "algoritmo seldoniano" para definir su enfoque, una referencia a Hari Seldon, un personaje inventado por el autor de ciencia ficción Isaac Asimov, quien una vez proclamó tres leyes de la robótica comenzando con el mandato de que "Un robot no puede dañar a un ser humano o, por inacción, permitir que un ser humano sufra daño ".

Si bien reconoce que el campo aún está lejos de garantizar las tres leyes, Thomas dijo que este marco seldoniano facilitará a los diseñadores de aprendizaje automático la creación de instrucciones para evitar comportamientos en todo tipo de algoritmos. de una manera que les permita evaluar la probabilidad de que los sistemas entrenados funcionen correctamente en el mundo real.

Brunskill dijo que este marco propuesto se basa en los esfuerzos que están haciendo muchos científicos informáticos para lograr un equilibrio entre la creación de algoritmos poderosos y el desarrollo de métodos para garantizar su confiabilidad.

"Pensar en cómo podemos crear algoritmos que mejor respeten valores como la seguridad y la equidad es esencial, ya que la sociedad depende cada vez más de la IA, "Dijo Brunskill.