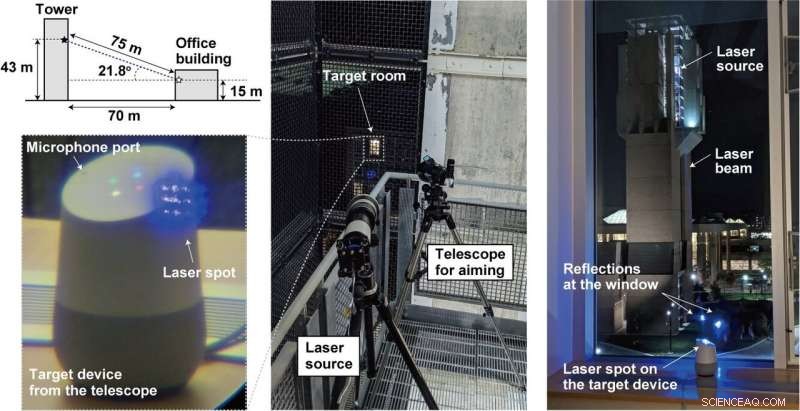

Crédito:lightcommands.com

Láseres brillantes en asistentes de voz como Alexa y Siri, Investigadores de Michigan y Japón lograron un truco donde los láseres tenían el poder de los comandos de la voz humana.

Al hacer brillar el láser a través de la ventana en los micrófonos dentro de dispositivos como tabletas, o teléfonos, un atacante lejano puede enviar de forma remota comandos inaudibles y potencialmente invisibles ejecutados por Alexa, Portal, Asistente de Google o Siri.

Simplemente pon, un atacante puede secuestrar el asistente de voz y enviar comandos.

¿Cómo interpretó el equipo la luz como sonido? Se explota una vulnerabilidad en los micrófonos que utilizan sistemas microelectromecánicos (MEMS). Los componentes MEMS responden involuntariamente a la luz como si fuera sonido, dijo Ars Technica .

¿Qué es lo peor que puede pasar? Mucho. Ars Technica describió que los láseres inyectaban comandos inaudibles en los dispositivos y los hacían subrepticiamente "para abrir puertas, visitar sitios web, y localizar, desbloquear, y arrancar vehículos ".

Los investigadores discutieron su trabajo en su artículo publicado el lunes. "Comandos de luz:ataques de inyección de audio basados en láser en sistemas controlables por voz" es de cinco autores con afiliaciones de la Universidad de Michigan (cuatro) y de la Universidad de Electro-Comunicaciones, Japón (uno).

"En nuestro periódico, " ellos dijeron, "demostramos este efecto, usar con éxito la luz para inyectar comandos maliciosos en varios dispositivos controlados por voz, como altavoces inteligentes, tabletas, y teléfonos a grandes distancias y a través de ventanas de vidrio ".

¿Qué tan fácil fue de llevar a cabo?

Para frustrar la autenticación, bastante fácil.

"Los sistemas controlados por voz a menudo no requieren que los usuarios se autentiquen, " escribió Ars Technica Dan Goodin. El ataque en esos casos podría llevarse a cabo con frecuencia sin necesidad de contraseñas o PIN. Frecuentemente. "Incluso cuando los sistemas requieren autenticación para determinadas acciones, "añadió, "puede ser factible aplicar la fuerza bruta al PIN, ya que muchos dispositivos no limitan la cantidad de conjeturas que puede hacer un usuario ".

También, el ataque no fue costoso de llevar a cabo. Los comandos de luz se pueden montar de forma económica, dijo un presentador de video, utilizando punteros láser regulares. Esto incluso podría hacerse entre dos edificios.

El equipo dijo que intentó atacar a los sistemas de reconocimiento de voz más populares, a saber, Amazon Alexa, Siri de manzana, Portal de Facebook, y Asistente de Google. Realmente, aunque, "cualquier sistema que utilice micrófonos MEMS y actúe sobre estos datos sin confirmación adicional del usuario puede ser vulnerable, "según su propio sitio de comandos de luz.

¿Cuál es el peligro con los comandos de luz?

Alexa, ¿Cuál es el clima? Eso es inofensivo. El atacante puede controlar los interruptores de casa inteligente. Abra puertas de garaje inteligentes. Arranque de vehículos de forma remota. De hecho, puedes ver un video inyectando "OK Google, abre la puerta del garaje "a un Google Home con solo hacer brillar un puntero láser barato.

¿Qué se puede hacer para protegerse contra la vulnerabilidad? El presentador del video dijo que la vulnerabilidad básica no se puede abordar sin un costoso rediseño del micrófono.

"Estamos colaborando con Amazon, Google, Manzana, así como otros proveedores sobre medidas defensivas. "Tienen más información y demostraciones en lightcommands.com.

"Una capa adicional de autenticación puede ser eficaz para mitigar un poco el ataque. Alternativamente, en caso de que el atacante no pueda escuchar la respuesta del dispositivo, Hacer que el dispositivo le haga al usuario una pregunta aleatoria simple antes de la ejecución del comando puede ser una forma efectiva de evitar que el atacante obtenga una ejecución exitosa del comando.

"Los fabricantes también pueden intentar utilizar técnicas de fusión de sensores, como adquirir audio de varios micrófonos. Cuando el atacante usa un solo láser, solo un micrófono recibe una señal mientras que los demás no reciben nada ...

Otro enfoque consiste en reducir la cantidad de luz que llega al diafragma del micrófono mediante una barrera que bloquea físicamente los haces de luz rectos para eliminar la línea de visión del diafragma. o implemente una cubierta no transparente en la parte superior del orificio del micrófono para atenuar la cantidad de luz que llega al micrófono. Sin embargo, observamos que tales barreras físicas solo son efectivas hasta cierto punto, como un atacante siempre puede aumentar la potencia del láser en un intento de compensar la atenuación inducida por la cobertura o para quemar las barreras, creando un nuevo camino de luz ".

Lo anterior apareció en su sitio de comandos de luz, mientras que el documento también discutió los enfoques de mitigación y las limitaciones.

Mientras tanto, Mariella Moon en Engadget recordó a sus lectores que esta no sería la primera vez que los investigadores encontraran vulnerabilidades en los asistentes digitales. "Investigadores de la Universidad Zheijiang de China descubrieron que Siri, Alexa y otros asistentes de voz pueden manipularse con comandos enviados en frecuencias ultrasónicas ".

© 2019 Science X Network