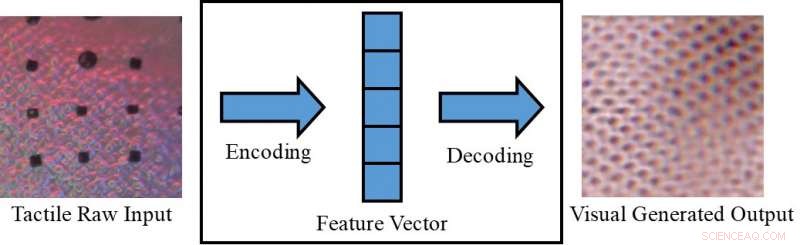

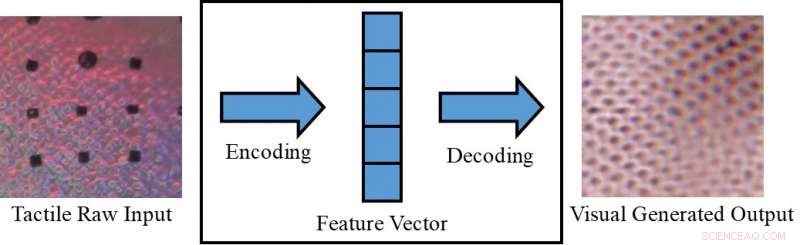

Conversión de una imagen táctil en una imagen visual. Crédito:Lee, Bollegala y Luo.

Percibir un objeto solo visualmente (por ejemplo, en una pantalla) o solo tocándolo, a veces puede limitar lo que podemos inferir al respecto. Seres humanos, sin embargo, tener la capacidad innata de integrar estímulos visuales y táctiles, aprovechando los datos sensoriales disponibles para completar sus tareas diarias.

Investigadores de la Universidad de Liverpool han propuesto recientemente un nuevo marco para generar datos sensoriales transmodales, lo que podría ayudar a replicar información tanto visual como táctil en situaciones en las que uno de los dos no es directamente accesible. Su marco podría, por ejemplo, Permitir que las personas perciban objetos en una pantalla (por ejemplo, prendas de vestir en sitios de comercio electrónico) tanto visual como tácticamente.

"En nuestra experiencia diaria, podemos crear cognitivamente una visualización de un objeto basada en una respuesta táctil, o una respuesta táctil al ver la textura de una superficie, "Dr. Shan Luo, uno de los investigadores que realizó el estudio, dijo a TechXplore. "Este fenómeno perceptivo, llamada sinestesia, en el que la estimulación de un sentido provoca una reacción involuntaria en uno o más de los otros sentidos, puede emplearse para inventar un sentido inaccesible. Por ejemplo, cuando uno agarra un objeto, nuestra visión será obstruida por la mano, pero se generará una respuesta táctil para 'ver' las características correspondientes ".

El fenómeno de percepción descrito por el Dr. Luo generalmente ocurre cuando una fuente de percepción no está disponible (por ejemplo, al tocar objetos dentro de una bolsa sin poder verlos). En tales situaciones, los humanos pueden "tocar para ver" o "ver para sentir, "interpretar características relacionadas con un sentido particular en función de la información recopilada utilizando sus otros sentidos. Si se replica en máquinas, este mecanismo visual-táctil podría tener varias aplicaciones interesantes, particularmente en los campos de la robótica y el comercio electrónico.

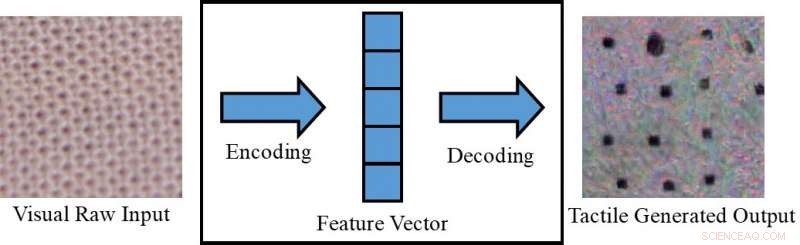

Conversión de una imagen visual a una imagen táctil. Crédito:Lee, Bollegala y Luo.

Si los robots pudieran integrar la percepción visual y táctil, podrían planificar sus estrategias de agarre y manipulación de manera más eficaz en función de las características visuales de los objetos con los que están trabajando (por ejemplo, forma, Talla, etc.). En otras palabras, los robots percibirían las propiedades táctiles generales de los objetos antes de agarrarlos, utilizando información visual recopilada por cámaras. Mientras agarra un objeto fuera del campo de visión de la cámara, por otra parte, utilizarían respuestas táctiles para compensar la falta de información visual disponible.

Si está emparejado con un dispositivo táctil, que aún no se ha desarrollado, el marco propuesto por el Dr. Luo y sus colegas también podría utilizarse en el comercio electrónico, por ejemplo, permitiendo a los clientes sentir la tela de la ropa antes de comprarla. Con esta aplicación en mente, Los investigadores utilizaron redes adversas generativas condicionales para generar imágenes pseudovisuales utilizando datos táctiles y viceversa (es decir, para generar salidas táctiles utilizando datos visuales).

"En los mercados online, los clientes compran viendo imágenes de ropa u otros artículos, "Dijo el Dr. Luo." Sin embargo, no pueden tocar estos elementos para sentir sus materiales. Sentir un artículo es muy importante al comprar, especialmente al comprar artículos delicados, como la ropa interior. Permitir que los usuarios sientan los elementos en casa, utilizando un dispositivo táctil que aún no se ha desarrollado, el esquema de generación de datos sensoriales transmodales propuesto en nuestro documento puede ayudar a los clientes de comercio electrónico a tomar decisiones más informadas ".

El Dr. Luo y sus colegas evaluaron su modelo en el conjunto de datos de VITac, que contiene imágenes macro y lecturas táctiles (capturadas con un sensor GelSight) de 100 tipos diferentes de tela. Descubrieron que podía predecir eficazmente las salidas sensoriales de un sentido (es decir, la visión o el tacto) utilizando datos relevantes para el otro.

Sensor GelSight. Crédito:Lee, Bollegala y Luo.

"Tomamos la percepción de la textura como ejemplo:las imágenes de entrada visual de una textura de tela se utilizan para generar una lectura pseudo táctil de la misma pieza de tela; a la inversa, Se emplean lecturas táctiles de una tela para predecir una imagen visual de la misma tela, "El Dr. Luo explicó." Las texturas de las telas, es decir., los patrones de distribución del hilo, aparecen de manera similar en una imagen visual y una lectura de distribución de presión (es decir, táctil). Sin embargo, este trabajo también puede extenderse para lograr la generación de datos visuales-táctiles transmodales para la percepción de otras propiedades del objeto, considerando las diferencias entre los dos dominios ".

El estudio realizado por el Dr. Luo y sus colegas logró resultados notables en la generación de patrones visuales y táctiles realistas para diferentes tejidos en ausencia de información táctil o visual. respectivamente. Usando su marco, los investigadores 'replicaron' con éxito elementos táctiles de tejidos utilizando datos visuales, y viceversa.

"Hasta donde sabemos, este trabajo es el primer intento de lograr la generación robótica de datos visuales-táctiles transmodales, que también se puede extender a la generación de datos intermodales para otras modalidades, "Dijo el Dr. Luo." Las implicaciones prácticas de nuestro estudio son que podemos hacer uso de otros sentidos para crear un sentido inaccesible ".

En el futuro, el marco propuesto por el Dr. Luo y sus colegas podría usarse para mejorar las estrategias de agarre y manipulación en robots, así como para mejorar las experiencias de compra online. Su método también podría usarse para expandir conjuntos de datos para tareas de clasificación, generando datos sensoriales que de otro modo serían inaccesibles.

Crédito:Lee, Bollegala y Luo.

"En investigaciones futuras, intentaremos aplicar nuestro método a una serie de tareas diferentes, como la clasificación visual y táctil en un entorno del mundo real, con objetos que varían en apariencia (por ejemplo, forma, color, etc.), "Dijo el Dr. Luo. Además, El método de generación de datos visual-táctil propuesto se utilizará para facilitar las tareas robóticas. como agarrar y manipular ".

El documento que describe este estudio reciente, prepublicado en arXiv, se presentará en la Conferencia Internacional de Robótica y Automatización (ICRA) de 2019, que tendrá lugar en Montreal, Canadá, entre el 20 y el 24 de mayo. En la conferencia, El Dr. Luo también llevará a cabo un taller relacionado con el tema de su estudio, llamado "ViTac:Integración de la visión y el tacto para la percepción multimodal y transmodal".

© 2019 Science X Network