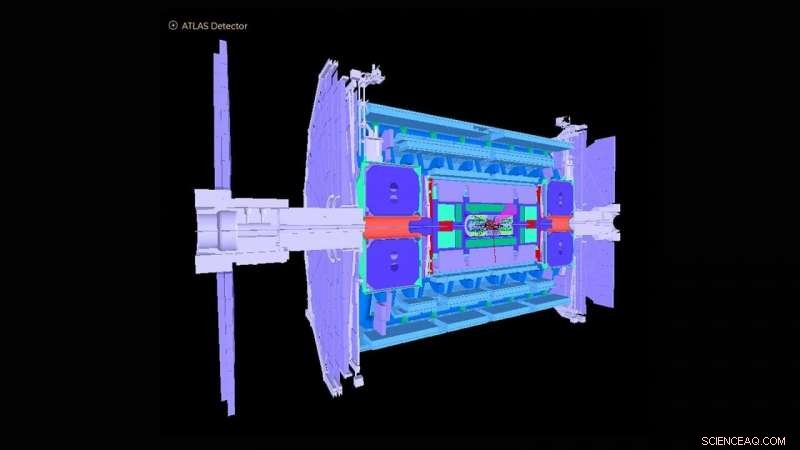

Esquema del detector ATLAS en el Gran Colisionador de Hadrones. Crédito:Colaboración ATLAS

El Gran Colisionador de Hadrones (LHC) cerca de Ginebra, Suiza se hizo famosa en todo el mundo en 2012 con la detección del bosón de Higgs. La observación marcó una confirmación crucial del modelo estándar de física de partículas, que organiza las partículas subatómicas en grupos similares a los elementos de la tabla periódica de la química.

El Laboratorio Nacional Argonne del Departamento de Energía de EE. UU. (DOE) ha realizado muchas contribuciones fundamentales a la construcción y operación del detector experimental ATLAS en el LHC y al análisis de las señales registradas por el detector que descubren la física subyacente de las colisiones de partículas. Argonne ahora está desempeñando un papel principal en la actualización de alta luminosidad del detector ATLAS para las operaciones que están planificadas para comenzar en 2027. Con ese fin, un equipo de físicos y científicos computacionales de Argonne ha ideado un algoritmo basado en el aprendizaje automático que se aproxima a cómo respondería el detector actual a los datos muy aumentados que se esperan con la actualización.

Como la máquina de física más grande jamás construida, el LHC dispara dos haces de protones en direcciones opuestas alrededor de un anillo de 17 millas hasta que se acercan a la velocidad de la luz, los aplasta y analiza los productos de colisión con detectores gigantes como ATLAS. El instrumento ATLAS tiene aproximadamente la altura de un edificio de seis pisos y pesa aproximadamente 7, 000 toneladas. Hoy dia, el LHC continúa estudiando el bosón de Higgs, así como abordar preguntas fundamentales sobre cómo y por qué la materia en el universo es como es.

"La mayoría de las preguntas de investigación en ATLAS implican encontrar una aguja en un pajar gigante, donde los científicos solo están interesados en encontrar un evento que ocurra entre mil millones de otros, "dijo Walter Hopkins, físico asistente en la división de Física de Altas Energías (HEP) de Argonne.

Como parte de la actualización del LHC, Los esfuerzos ahora están progresando para aumentar la luminosidad del LHC (el número de interacciones protón a protón por colisión de los dos haces de protones) en un factor de cinco. Esto producirá aproximadamente 10 veces más datos por año que los que actualmente se adquieren mediante los experimentos del LHC. Aún debe entenderse qué tan bien responden los detectores a este aumento de la tasa de eventos. Esto requiere ejecutar simulaciones por computadora de alto rendimiento de los detectores para evaluar con precisión los procesos conocidos que resultan de las colisiones del LHC. Estas simulaciones a gran escala son costosas y exigen grandes cantidades de tiempo de computación en las mejores y más potentes supercomputadoras del mundo.

El equipo de Argonne ha creado un algoritmo de aprendizaje automático que se ejecutará como una simulación preliminar antes de cualquier simulación a gran escala. Este algoritmo se aproxima, de formas muy rápidas y menos costosas, cómo respondería el detector actual a los datos muy aumentados que se esperan con la actualización. Implica la simulación de las respuestas del detector a un experimento de colisión de partículas y la reconstrucción de objetos a partir de los procesos físicos. Estos objetos reconstruidos incluyen chorros o aerosoles de partículas, así como partículas individuales como electrones y muones.

"El descubrimiento de nueva física en el LHC y en otros lugares exige métodos cada vez más complejos para el análisis de macrodatos, "dijo Doug Benjamin, un científico computacional en HEP. "En estos días, eso generalmente significa el uso de aprendizaje automático y otras técnicas de inteligencia artificial".

Los métodos de análisis utilizados anteriormente para las simulaciones iniciales no han empleado algoritmos de aprendizaje automático y consumen mucho tiempo porque implican la actualización manual de parámetros experimentales cuando cambian las condiciones en el LHC. Algunos también pueden perder correlaciones de datos importantes para un conjunto dado de variables de entrada a un experimento. El algoritmo desarrollado por Argonne aprende, en tiempo real mientras se aplica un procedimiento de formación, las diversas funciones que deben introducirse mediante simulaciones completas detalladas, evitando así la necesidad de elaborar manualmente parámetros experimentales. El método también puede capturar interdependencias complejas de variables que antes no habían sido posibles.

"Con nuestra simulación simplificada, puede aprender los conceptos básicos a un costo y tiempo computacional comparativamente pequeños, entonces podrá proceder de manera mucho más eficiente con simulaciones completas en una fecha posterior, ", dijo Hopkins." Nuestro algoritmo de aprendizaje automático también proporciona a los usuarios un mejor poder de discriminación sobre dónde buscar eventos nuevos o raros en un experimento, "añadió.

El algoritmo del equipo podría resultar invaluable no solo para ATLAS, pero para los múltiples detectores experimentales en el LHC, así como otros experimentos de física de partículas que se están llevando a cabo en todo el mundo.

Este estudio, titulado "Parametrización automatizada de simulación y reconstrucción de detectores mediante aprendizaje automático, "apareció en el Revista de instrumentación .