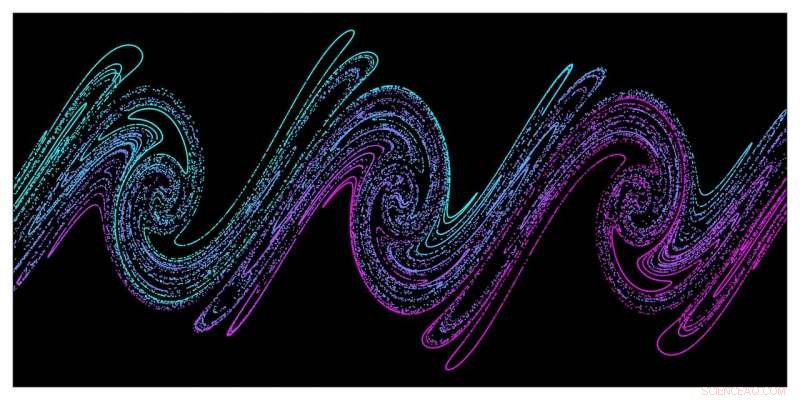

Las simulaciones a gran escala demuestran que el caos es responsable del calentamiento estocástico del plasma denso por la intensa energía del láser. Esta imagen muestra una instantánea del espacio de fase de distribución de electrones (posición / momento) del denso plasma tomado de las simulaciones PIC, ilustrando el llamado mecanismo de "estiramiento y plegado" responsable del surgimiento del caos en los sistemas físicos. Crédito:G. Blaclard, CEA Saclay

Una nueva herramienta de simulación de partículas en celda (PIC) 3-D desarrollada por investigadores del Laboratorio Nacional Lawrence Berkeley y CEA Saclay está permitiendo simulaciones de vanguardia de mecanismos de acoplamiento de láser / plasma que antes estaban fuera del alcance de los códigos PIC estándar utilizados en investigación de plasma. Una comprensión más detallada de estos mecanismos es fundamental para el desarrollo de fuentes de luz y aceleradores de partículas ultracompactos que podrían resolver los desafíos de larga data en la medicina. industria, y ciencia fundamental de manera más eficiente y rentable.

En experimentos con plasma láser, como los del Centro Acelerador Láser Berkeley Lab (BELLA) y el CEA Saclay, una instalación de investigación internacional en Francia que forma parte de la Comisión de Energía Atómica francesa, campos eléctricos muy grandes dentro de los plasmas que aceleran los haces de partículas para altas energías en distancias mucho más cortas en comparación con las tecnologías de aceleradores existentes. El objetivo a largo plazo de estos aceleradores de plasma láser (LPA) es construir algún día colisionadores para la investigación de alta energía, pero ya se están desarrollando muchas derivaciones. Por ejemplo, Los LPA pueden depositar rápidamente grandes cantidades de energía en materiales sólidos, creando plasmas densos y sometiendo esta materia a temperaturas y presiones extremas. También tienen el potencial de impulsar láseres de electrones libres que generan pulsos de luz que duran solo attosegundos. Pulsos tan extremadamente cortos podrían permitir a los investigadores observar las interacciones de moléculas, átomos, e incluso partículas subatómicas en escalas de tiempo extremadamente cortas.

Las simulaciones de supercomputadoras se han vuelto cada vez más críticas para esta investigación, y el Centro Nacional de Computación Científica de Investigación Energética (NERSC) de Berkeley Lab se ha convertido en un recurso importante en este esfuerzo. Al dar a los investigadores acceso a observables físicos como las órbitas de partículas y los campos radiados que son difíciles de obtener en experimentos a escalas de tiempo y longitud extremadamente pequeñas, Las simulaciones PIC han jugado un papel importante en la comprensión, modelado, y guiar experimentos de física de alta intensidad. Pero la falta de códigos PIC que tengan suficiente precisión computacional para modelar la interacción láser-materia a intensidades ultra altas ha obstaculizado el desarrollo de nuevas fuentes de luz y partículas producidas por esta interacción.

Este desafío llevó al equipo de Berkeley Lab / CEA Saclay a desarrollar su nueva herramienta de simulación, denominado Warp + PXR, un esfuerzo iniciado durante la primera ronda del Programa de Aplicaciones Científicas Exascale de NERSC (NESAP). El código combina el ampliamente utilizado código 3-D PIC Warp con la biblioteca de alto rendimiento PICSAR co-desarrollada por Berkeley Lab y CEA Saclay. También aprovecha un nuevo tipo de solucionador pseudoespectral masivamente paralelo desarrollado conjuntamente por Berkeley Lab y CEA Saclay que mejora drásticamente la precisión de las simulaciones en comparación con los solucionadores que se utilizan normalmente en la investigación del plasma.

De hecho, sin esto nuevo, solucionador altamente escalable, "las simulaciones que estamos haciendo ahora no serían posibles, "dijo Jean-Luc Vay, un físico senior en Berkeley Lab que dirige el Programa de Modelado Acelerador en la División de Física Aplicada y Tecnologías Aceleradoras del Laboratorio. "Como demostró nuestro equipo en un estudio anterior, este nuevo solucionador espectral FFT permite una precisión mucho mayor que la que se puede lograr con los solucionadores de dominio de tiempo de diferencia finita (FDTD), así que pudimos alcanzar algunos espacios de parámetros que no habrían sido accesibles con los solucionadores FDTD estándar ". Este nuevo tipo de solucionador espectral también está en el corazón del algoritmo PIC de próxima generación con refinamiento de malla adaptable que Vay y sus colegas están desarrollando en el nuevo código Warp-X como parte del Proyecto de Computación a exaescala del Departamento de Energía de EE. UU.

Simulaciones 2-D y 3-D ambas críticas

Vay también es coautor de un artículo publicado el 21 de marzo en Revisión física X que informa sobre el primer estudio completo de los mecanismos de acoplamiento láser-plasma utilizando Warp + PXR. Ese estudio combinó mediciones experimentales de vanguardia realizadas en la instalación láser UHI100 en CEA Saclay con simulaciones de vanguardia 2-D y 3-D ejecutadas en la supercomputadora Cori en NERSC y los sistemas Mira y Theta en Argonne Leadership. Instalación de Computación en el Laboratorio Nacional de Argonne. Estas simulaciones permitieron al equipo comprender mejor los mecanismos de acoplamiento entre la luz láser ultra intensa y el plasma denso que creó. proporcionando nuevos conocimientos sobre cómo optimizar las fuentes de luz y partículas ultracompactas. Los puntos de referencia con Warp + PXR mostraron que el código es escalable hasta 400, 000 núcleos en Cori y 800, 000 núcleos en Mira y puede acelerar el tiempo de solución hasta en tres órdenes de magnitud en problemas relacionados con experimentos de física de intensidad ultra alta.

"No podemos repetir o reproducir consistentemente lo que sucedió en el experimento con simulaciones 2-D; necesitamos 3-D para esto, "dijo el coautor Henri Vincenti, científico del grupo de física de alta intensidad de CEA Saclay. Vincenti dirigió el trabajo teórico / de simulación para el nuevo estudio y fue becario postdoctoral Marie Curie en Berkeley Lab en el grupo de Vay, donde comenzó a trabajar en el nuevo código y solucionador. "Las simulaciones en 3-D también fueron realmente importantes para poder comparar la precisión aportada por el nuevo código con los experimentos".

Para el experimento descrito en el Revisión física X papel, Los investigadores de CEA Saclay utilizaron un rayo láser de femtosegundos de alta potencia (100TW) en la instalación UHI100 de CEA enfocado en un objetivo de sílice para crear un plasma denso. Además, Se aplicaron dos diagnósticos, una pantalla de centelleo Lanex y un espectrómetro ultravioleta extremo, para estudiar la interacción láser-plasma durante el experimento. Las herramientas de diagnóstico presentaban desafíos adicionales cuando se trataba de estudiar escalas de tiempo y longitud mientras se realizaba el experimento. nuevamente haciendo que las simulaciones sean críticas para los hallazgos de los investigadores.

"A menudo, en este tipo de experimento no se puede acceder a las escalas de tiempo y duración involucradas, especialmente porque en los experimentos tienes un campo láser muy intenso en tu objetivo, por lo que no puede poner ningún diagnóstico cerca del objetivo, "dijo Fabien Quéré, un científico investigador que dirige el programa experimental en CEA y es coautor del artículo PRX. "En este tipo de experimento, observamos las cosas emitidas por el objetivo que está lejos:10, 20 cm, y sucediendo en tiempo real, esencialmente, mientras que la física está en la escala de micrones o submicrones y en la escala de subfemtosegundos en el tiempo. Así que necesitamos las simulaciones para descifrar lo que está sucediendo en el experimento ".

"Las simulaciones de los primeros principios que usamos para esta investigación nos dieron acceso a la dinámica compleja de la interacción del campo láser, con el objetivo sólido al nivel de detalle de las órbitas de partículas individuales, permitiéndonos comprender mejor lo que estaba sucediendo en el experimento, "Añadió Vincenti.

Estas simulaciones de gran tamaño con un solucionador de FFT espectral de ultra alta precisión fueron posibles gracias a un cambio de paradigma introducido en 2013 por Vay y sus colaboradores. En un estudio publicado en el Journal of Computational Physics, ellos observaron que, al resolver las ecuaciones de Maxwell dependientes del tiempo, El método estándar de paralelización de FFT (que es global y requiere comunicaciones entre procesadores en todo el dominio de simulación) podría reemplazarse con una descomposición de dominio con FFT locales y comunicaciones limitadas a procesadores vecinos. Además de permitir un escalado fuerte y débil mucho más favorable en una gran cantidad de nodos de computadora, el nuevo método también es más eficiente energéticamente porque reduce las comunicaciones.

"Con los algoritmos FFT estándar, necesita realizar comunicaciones en toda la máquina, ", Dijo Vay." Pero el nuevo solucionador de FFT espectral permite ahorros en tiempo y energía de la computadora, lo cual es un gran problema para las nuevas arquitecturas de supercomputación que se están introduciendo ".