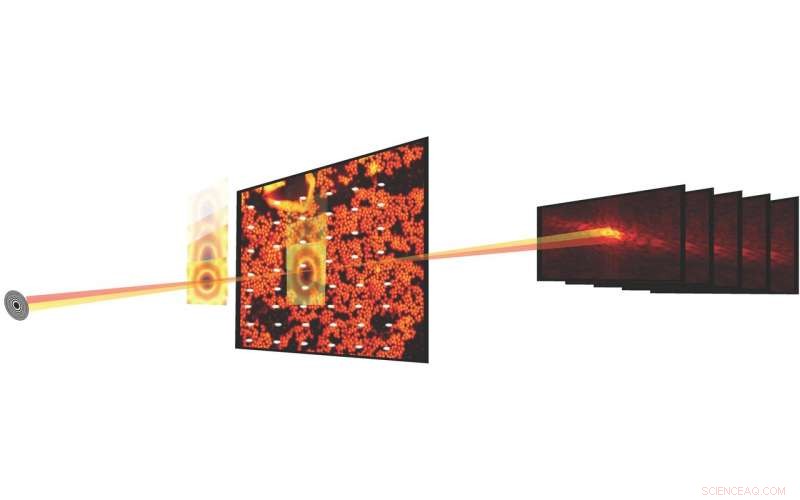

En experimentos científicos, Las imágenes pticográficas combinan la microscopía de barrido con mediciones de difracción para caracterizar la estructura y propiedades de la materia y los materiales. Los avances en detectores y microscopios de rayos X en fuentes de luz han hecho posible ahora medir un conjunto de datos pticográficos en segundos. Crédito:Stefano Marchesini, Laboratorio de Berkeley

Lo que comenzó hace casi una década como una propuesta de Investigación y Desarrollo Dirigida por el Laboratorio de Berkeley Lab (LDRD) es ahora una realidad. y ya está cambiando la forma en que los científicos realizan experimentos en la fuente de luz avanzada (ALS), y finalmente, otras fuentes de luz en todo el complejo del Departamento de Energía (DOE), al permitir la transmisión en tiempo real de datos de imágenes pticográficas en un entorno de producción.

En experimentos científicos, Las imágenes pticográficas combinan la microscopía de barrido con mediciones de difracción para caracterizar la estructura y propiedades de la materia y los materiales. Si bien el método ha existido durante unos 50 años, La amplia utilización se ha visto obstaculizada por el hecho de que el proceso experimental era lento y el procesamiento computacional de los datos para producir una imagen reconstruida era caro. Pero en los últimos años, los avances en detectores y microscopios de rayos X en fuentes de luz como el ALS han hecho posible medir un conjunto de datos pticográficos en segundos.

Reconstruir conjuntos de datos pticográficos, sin embargo, no es un asunto trivial; el proceso implica resolver un problema de recuperación de fase difícil, calibrar elementos ópticos y tratar con valores atípicos experimentales y "ruido". Introduzca SHARP (pticografía adaptable heterogénea escalable en tiempo real), un marco algorítmico y software informático que permite la reconstrucción de millones de fases de datos de imágenes ptychographic por segundo. Desarrollado en Berkeley Lab a través de una colaboración internacional y lanzado en 2016, SHARP ha tenido un impacto demostrable en la productividad para los científicos que trabajan en ALS y otras fuentes de luz en todo el complejo del Departamento de Energía.

Ahora, una agencia intergubernamental financió la colaboración de científicos del Centro de Matemáticas Avanzadas para Aplicaciones de Investigación Energética (CAMERA) financiado por el DOE de Berkeley Lab, el ALS y STROBE, el Centro de Ciencia y Tecnología de la National Science Foundation, ha producido otro avance único en su tipo para la obtención de imágenes pticográficas:una canalización de software / algorítmica que permite la transmisión en tiempo real de datos de imágenes pticográficas durante un experimento de línea de luz, proporcionando rendimiento, compresión y resolución, así como retroalimentación rápida para el usuario mientras el experimento aún se está ejecutando.

Integrado, Modular, Escalable

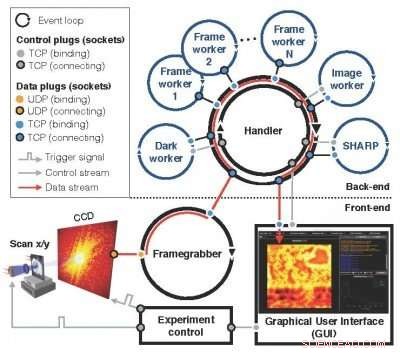

Un sucesor del concepto Nanosurveyor introducido por primera vez en una propuesta LDRD de 2010, el modular, El sistema escalable Nanosurveyor II, ahora en funcionamiento en el ALS, emplea una infraestructura de dos lados que integra la adquisición de datos de imágenes ptychographic, preprocesamiento, Procesos de transmisión y visualización. El componente frontal en la línea de luz comprende el detector, capturador de fotogramas, un preprocesador escalable y una interfaz gráfica de usuario (GUI), mientras que el componente de back-end en el clúster de cómputo contiene SHARP para la reconstrucción de imágenes de alta resolución combinado con canales de comunicación para el flujo de datos, instrucciones y sincronización. En la operación, una vez que el control del experimento ha activado un nuevo escaneo, el capturador de fotogramas recibe continuamente paquetes de datos sin procesar de la cámara, los ensambla a un marco y, en paralelo, preprocesa un conjunto de fotogramas sin procesar en un bloque limpio y reducido para el back-end computacional. Los bloques entrantes se distribuyen entre los trabajadores de SHARP en el back-end de cálculo, y los datos reducidos se envían de vuelta al front-end y se visualizan en una GUI. El nuevo sistema de software de transmisión se está implementando en ALS para uso activo en experimentos en las líneas de luz, como la plataforma de microscopía de rayos X COSMIC que se puso en línea recientemente.

"Lo que hemos logrado es lograr que el flujo de trabajo de datos y cálculos muy complejos sea lo más transparente posible, "dijo David Shapiro, un científico de planta en el Grupo de Sistemas Experimentales en el ALS que ha sido fundamental para facilitar la implementación y prueba del nuevo sistema. "Una vez que el software está funcionando, los operadores de microscopios no tienen idea de que están generando gigabytes de datos y que pasan por esta tubería y luego regresan a ellos ".

Los usuarios de ALS normalmente pueden utilizar las líneas de luz durante unos dos días, durante el cual pueden estudiar alrededor de una docena de muestras, Shapiro notó. Esto significa que solo tienen unas pocas horas por muestra, y necesitan tomar una serie de decisiones sobre los datos dentro de esas horas. La capacidad de transmisión pitcográfica en tiempo real les brinda retroalimentación en tiempo real y les ayuda a tomar decisiones más precisas.

El modular, El sistema escalable Nanosurveyor II, ahora en funcionamiento en el ALS, emplea una infraestructura de dos lados que integra la adquisición de datos de imágenes ptychographic, preprocesamiento, Procesos de transmisión y visualización. Crédito:Laboratorio Nacional Lawrence Berkeley

"El hecho de que SHARP ahora puede tomar datos en tiempo real y procesarlos de inmediato, incluso si el experimento no está completo, lo hace de alto rendimiento y operativo para la ciencia en un entorno de producción, "dijo Stefano Marchesini, un científico de CAMERA y el investigador principal sobre la propuesta original de LDRD.

Entorno listo para producción

La integración de todos los componentes fue uno de los mayores desafíos en la implementación de Nanosurveyor II, al igual que prepararlo para funcionar en un entorno listo para producción frente a un banco de pruebas, según Hari Krishnan, un ingeniero de sistemas informáticos en CAMERA que fue responsable del desarrollo del motor de comunicación del oleoducto. Se necesitó un esfuerzo de varios años para llevar a buen término las capacidades de procesamiento de datos en tiempo real, con contribuciones de matemáticos, científicos de la computación, ingenieros de software, físicos y científicos de líneas de luz. Además de Marchesini y Krishnan, Los científicos de CAMERA, Pablo Enfedaque y Huibin Chang, participaron en el desarrollo de la interfaz SHARP y el motor de comunicación. Además, Filipe Maia y Benedict Daurer de la Universidad de Uppsala, que tiene una colaboración con CAMERA, jugó un papel integral en el desarrollo del software de transmisión. Mientras tanto, El físico Bjoern Enders del Departamento de Física de Berkeley y STROBE se centró en el detector y el preprocesador, y Ph.D en Física de Berkeley. la estudiante Kasra Nowrouzi participó en la implementación de la tubería.

"Era importante separar las responsabilidades y tareas del sistema y luego encontrar una interfaz común para comunicarse, "Enders dijo sobre el esfuerzo del equipo." Esto devolvió parte de la responsabilidad a la línea de luz. Todos trabajamos juntos para separar claramente el algoritmo de transmisión de la parte de preprocesamiento para poder asegurarnos de que la línea de luz realmente funciona ".

Mirando hacia el futuro, La escalabilidad de Nanosurveyor II será fundamental a medida que la próxima generación de fuentes de luz y detectores entre en funcionamiento. Las velocidades de datos de la tubería reflejan las del detector; el detector de corriente funciona a una velocidad de hasta 400 megabytes por segundo y puede generar unos pocos terabytes de datos por día. Los detectores de próxima generación producirán datos de 100 a 1, 000 veces más rápido.

"La solución de transmisión funciona tan rápido como la adquisición de datos en este momento, ", Dijo Enfedaque." Se puede reconstruir la imagen pticográfica a la velocidad a la que se capturan y preprocesan los datos ".

Además, el equipo busca mejorar las capacidades de la canalización mediante la incorporación de algoritmos de aprendizaje automático que puedan automatizar aún más el proceso de análisis de datos.

"El objetivo es hacerlo perfecto, Krishnan dijo. En este momento, lo que ven los usuarios es una imagen burda para tomar decisiones rápidas y una imagen más fina para tomar decisiones más complejas. Con el tiempo, queremos alejarnos por completo de los fotogramas y los datos sin procesar y terminar en este ámbito donde todas las decisiones y todos los puntos son una sola imagen reconstruida. Todas estas otras cosas intermedias desaparecen ".

"La capacidad de transmisión de datos lleva el análisis a la escala de tiempo de la toma de decisiones humanas para los operadores, pero también facilita el futuro, que serían máquinas que toman decisiones y guían las mediciones, "Añadió Shapiro.