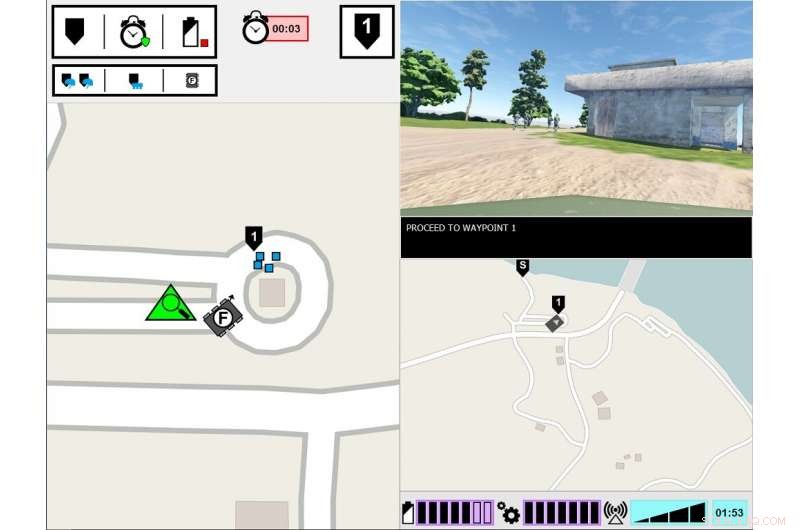

Interfaz experimental ASM. El monitor del lado izquierdo muestra el punto de vista del Soldado principal sobre el entorno de la tarea. El monitor del lado derecho muestra la interfaz de comunicación del ASM. Crédito:Ejército de EE. UU.

¿Qué se necesita para que un humano confíe en un robot? Eso es lo que los investigadores del Ejército están descubriendo en un nuevo estudio sobre cómo los humanos y los robots trabajan juntos.

Investigación sobre la formación de equipos humano-agente, o SOMBRERO, ha examinado cómo la transparencia de los agentes, como los robots, vehículos no tripulados o agentes de software:influye en la confianza humana, desempeño de habilidades, carga de trabajo y percepciones del agente. La transparencia del agente se refiere a su capacidad para transmitir a los humanos su intención, proceso de razonamiento y planes futuros.

Una nueva investigación dirigida por el Ejército encuentra que la confianza humana en los robots disminuye después de que el robot comete un error, incluso cuando es transparente con su proceso de razonamiento. El papel, "Transparencia y confiabilidad del agente en la interacción humano-robot:la influencia en la confianza del usuario y la confiabilidad percibida, "se ha publicado en la edición de agosto de Transacciones IEEE en sistemas hombre-máquina .

Hasta la fecha, La investigación se ha centrado principalmente en HAT con agentes inteligentes perfectamente confiables, lo que significa que los agentes no cometen errores, pero este es uno de los pocos estudios que ha explorado cómo la transparencia del agente interactúa con la confiabilidad del agente. En este último estudio, los humanos fueron testigos de un robot cometiendo un error, y los investigadores se centraron en si los humanos percibían que el robot era menos confiable, incluso cuando al humano se le proporcionó información sobre el proceso de razonamiento del robot.

"Comprender cómo influye el comportamiento del robot en sus compañeros de equipo humanos es fundamental para el desarrollo de equipos efectivos de humanos y robots, así como el diseño de interfaces y métodos de comunicación entre los miembros del equipo, "dijo la Dra. Julia Wright, investigador principal de este proyecto e investigador del Laboratorio de Investigación del Ejército del Comando de Desarrollo de Capacidades de Combate del Ejército de EE. UU. también conocido como ARL. "Esta investigación contribuye a los esfuerzos de operaciones multidominio del Ejército para garantizar la superación en las capacidades habilitadas por inteligencia artificial. Pero también es interdisciplinaria, ya que sus hallazgos informarán el trabajo de los psicólogos, roboticistas, ingenieros y diseñadores de sistemas que están trabajando para facilitar un mejor entendimiento entre humanos y agentes autónomos en el esfuerzo de hacer compañeros de equipo autónomos en lugar de simples herramientas.

Esta investigación fue un esfuerzo conjunto entre ARL y el Instituto de Simulaciones y Capacitación de la Universidad de Florida Central, y es el tercer y último estudio del proyecto Autonomous Squad Member (ASM), patrocinado por la Iniciativa Piloto de Investigación sobre Autonomía de la Oficina del Secretario de Defensa. El ASM es un pequeño robot terrestre que interactúa y se comunica con un escuadrón de infantería.

Estudios anteriores de ASM investigaron cómo se comunicaría un robot con un compañero de equipo humano. Utilizando el modelo de transparencia de agentes basado en la conciencia de la situación como guía, varios métodos de visualización para transmitir los objetivos del agente, intenciones, razonamiento, restricciones, y se exploraron y probaron los resultados proyectados. Se desarrolló un módulo iconográfico de un vistazo basado en estos primeros hallazgos del estudio, y luego se utilizó en estudios posteriores para explorar la eficacia de la transparencia del agente en HAT.

Los investigadores realizaron este estudio en un entorno simulado, en el que los participantes observaron un equipo de soldados humanos-agentes, que incluía la MAPE, atravesando un curso de formación. La tarea de los participantes fue monitorear al equipo y evaluar el robot. El equipo soldado-robot se encontró con varios eventos a lo largo del curso y respondió en consecuencia. Si bien los soldados siempre respondieron correctamente al evento, ocasionalmente el robot malinterpretó la situación, conduciendo a acciones incorrectas. La cantidad de información que compartió el robot varió entre los ensayos. Mientras que el robot siempre explicaba sus acciones, las razones detrás de sus acciones y el resultado esperado de sus acciones, en algunos ensayos, el robot también compartió el razonamiento detrás de sus decisiones, su lógica subyacente. Los participantes vieron varios equipos de robot-soldado, y se compararon sus evaluaciones de los robots.

El estudio encontró que, independientemente de la transparencia del robot al explicar su razonamiento, la confiabilidad del robot fue el factor determinante final para influir en las proyecciones de los participantes sobre la confiabilidad futura del robot, confianza en el robot y percepciones del robot. Es decir, después de que los participantes presenciaron un error, continuaron calificando la confiabilidad del robot más baja, incluso cuando el robot no cometió ningún error posterior. Si bien estas evaluaciones mejoraron lentamente con el tiempo, siempre que el robot no cometiera más errores, la confianza de los participantes en sus propias evaluaciones de la confiabilidad del robot se mantuvo baja durante el resto de las pruebas, en comparación con los participantes que nunca vieron un error. Es más, los participantes que presenciaron un error de robot informaron una menor confianza en el robot, en comparación con aquellos que nunca presenciaron un error de robot.

Se descubrió que el aumento de la transparencia de los agentes mejora la confianza de los participantes en el robot, pero solo cuando el robot estaba recopilando o filtrando información. Esto podría indicar que compartir información detallada puede mitigar algunos de los efectos de una automatización poco confiable para tareas específicas. Dijo Wright. Adicionalmente, los participantes calificaron al robot poco confiable como menos animado, agradable, inteligente, y seguro que el robot confiable.

"Estudios anteriores sugieren que el contexto es importante para determinar la utilidad de la información sobre transparencia, ", Dijo Wright." Necesitamos comprender mejor qué tareas requieren una comprensión más profunda del razonamiento del agente, y cómo discernir lo que implicaría esa profundidad. La investigación futura debería explorar formas de entregar información de transparencia basada en los requisitos de la tarea ".