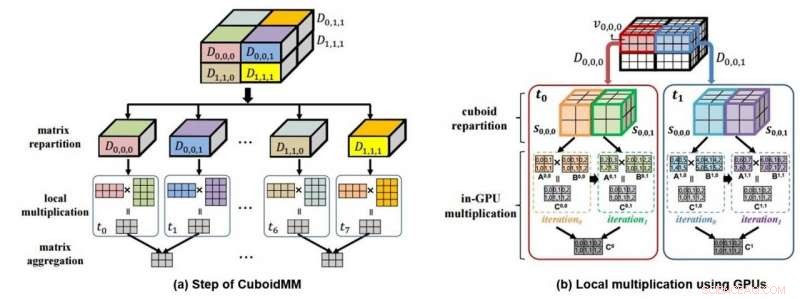

Este es un diagrama mimético (a) de multiplicación de datos 3D a través de CuboidMM y un diagrama mimético (b) de cálculo de procesamiento de datos usando GPU. Crédito:DGIST

DGIST anunció el 4 de julio que el equipo del profesor Min-Soo Kim en el Departamento de Ingeniería de la Información y la Comunicación desarrolló la tecnología DistME (Distributed Matrix Engine) que puede analizar 100 veces más datos 14 veces más rápido que las tecnologías existentes. Se espera que esta nueva tecnología se utilice en el aprendizaje automático que necesita procesamiento de big data o varios campos de la industria para analizar datos a gran escala en el futuro.

Datos de 'matriz', que expresa números en filas y columnas, es la forma de datos más utilizada en diversos campos, como el aprendizaje automático y la tecnología científica. Si bien 'SystemML' y 'ScaLAPACK' se evalúan como las tecnologías más populares para analizar datos matriciales, pero la capacidad de procesamiento de la tecnología existente ha alcanzado recientemente sus límites con el tamaño creciente de los datos. Es especialmente difícil realizar multiplicaciones, que son necesarios para el procesamiento de datos, para el análisis de big data con los métodos existentes porque no pueden realizar análisis y procesamiento elásticos y requieren una gran cantidad de transferencia de datos de red para su procesamiento.

En respuesta, El equipo del profesor Kim desarrolló un método de multiplicación de matrices distribuidas que es diferente del existente. También llamado CuboidMM, este método forma la multiplicación de matrices en un hexaedro 3-D y luego se divide y procesa en múltiples piezas llamadas cuboides. El tamaño óptimo del cuboide se determina de forma flexible en función de las características de las matrices, es decir., el tamaño, la dimensión, y escasez de matriz, para minimizar el costo de comunicación. CuboidMM no solo incluye todos los métodos existentes, sino que también puede realizar la multiplicación de matrices con un costo de comunicación mínimo. Además, El equipo del profesor Kim ideó una tecnología de procesamiento de información combinándola con GPU (Unidad de procesamiento de gráficos) que mejoró drásticamente el rendimiento de la multiplicación de matrices.

La tecnología DistME desarrollada por el equipo del profesor Kim ha aumentado la velocidad de procesamiento al combinar CuboidMM con GPU, que es 6.5 y 14 veces más rápido que ScaLAPACK y SystemML respectivamente y puede analizar datos matriciales 100 veces más grandes que SystemML. Se espera que abra una nueva aplicabilidad del aprendizaje automático en varias áreas que necesitan procesamiento de datos a gran escala, incluidos centros comerciales en línea y redes sociales.

El profesor Kim, del Departamento de Ingeniería de la Información y las Comunicaciones, dijo:'Tecnología de aprendizaje automático, que ha atraído la atención mundial, tiene limitaciones en la velocidad para el análisis de macrodatos en forma de matriz y en el tamaño del procesamiento del análisis. La tecnología de procesamiento de información desarrollada esta vez puede superar tales limitaciones y será útil no solo en el aprendizaje automático, sino también en aplicaciones en rangos más amplios de aplicación de análisis de datos de tecnología científica ".

Esta investigación contó con la participación de Donghyoung Han, un doctorado estudiante del Departamento de Ingeniería de la Información y la Comunicación como primer autor y fue presentado el 3 de julio en ACM SIGMOD 2019, la conferencia académica de mayor renombre en el campo de las bases de datos celebrada en Amsterdam, Países Bajos.