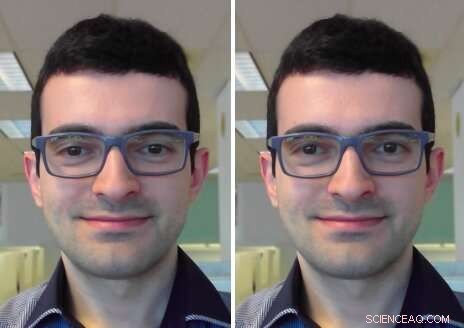

Corrección del contacto visual:en el cuadro de entrada (izquierda) el usuario está mirando la pantalla. En el cuadro de salida (derecha), su mirada se corrige para mirar a la cámara. Crédito:Isikdogan, Gerasimow y Michael.

Al participar en una videollamada o conferencia, a menudo es difícil mantener contacto visual directo con otros participantes, ya que esto requiere mirar a la cámara en lugar de a la pantalla. Aunque la mayoría de las personas utilizan los servicios de videollamadas con regularidad, hasta aquí, no ha habido una solución generalizada a este problema.

Un equipo de investigadores de Intel ha desarrollado recientemente un modelo de corrección del contacto visual que podría ayudar a superar esta molestia al restaurar el contacto visual en los chats de video en vivo, independientemente de dónde se encuentren la cámara y la pantalla del dispositivo. A diferencia de los enfoques propuestos anteriormente, este modelo centra automáticamente la mirada de una persona sin la necesidad de entradas que especifiquen el ángulo de redirección o la geometría de la cámara / pantalla / usuario.

"El principal objetivo de nuestro proyecto es mejorar la calidad de las experiencias de videoconferencia facilitando el contacto visual, "Leo Isikdogan, uno de los investigadores que realizó el estudio, dijo a TechXplore. "Es difícil mantener el contacto visual durante una videollamada porque no es natural mirar a la cámara durante una llamada. La gente mira la imagen de la otra persona en su pantalla, o, a veces, incluso miran su propia imagen de vista previa, pero no a la cámara. Con esta nueva función de corrección del contacto visual, los usuarios podrán tener una conversación cara a cara natural ".

El objetivo clave del estudio realizado por Isikdogan y sus colegas fue crear una experiencia de chat de video natural. Lograr esto, solo querían que su función de corrección de contacto visual funcionara cuando un usuario participaba en la conversación, en lugar de cuando apartan la vista de la pantalla de forma natural (por ejemplo, cuando miran papeles o manipulan objetos en su entorno).

"Corrección del contacto visual y redirección de la mirada en general, no son nuevas ideas de investigación, "Dijo Isikdogan." Muchos investigadores han propuesto modelos para manipular dónde miran las personas en las imágenes. Sin embargo, algunos de estos requieren configuraciones de hardware especiales, otros necesitan información adicional del usuario, como hacia qué dirección y cuánto debe ser la redirección, y otros utilizan procesos computacionalmente costosos que son factibles solo para procesar videos pregrabados ".

El nuevo sistema desarrollado por Isikdogan y sus colegas utiliza una red neuronal convolucional profunda (CNN) para redirigir la mirada de una persona al deformar y ajustar los ojos en sus marcos de entrada. Esencialmente, la CNN procesa una imagen monocular y produce un campo vectorial y un mapa de brillo para corregir la mirada del usuario.

En contraste con los enfoques propuestos anteriormente, su sistema puede ejecutarse en tiempo real, fuera de la caja y sin requerir ninguna entrada de los usuarios o hardware dedicado. Es más, el corrector funciona en una variedad de dispositivos con diferentes tamaños de pantalla y posiciones de cámara.

"Nuestro corrector de contacto visual utiliza un conjunto de mecanismos de control que evitan cambios abruptos y aseguran que el corrector de contacto visual evite hacer cualquier corrección antinatural que de otra manera sería espeluznante, "Dijo Isikdogan." Por ejemplo, la corrección se desactiva suavemente cuando el usuario parpadea o mira a algún lugar lejano ".

Los investigadores entrenaron su modelo de una manera bidireccional en un gran conjunto de datos generados sintéticamente, imágenes fotorrealistas y etiquetadas. Luego evaluaron su efectividad y cómo la percibían los usuarios en una serie de pruebas ciegas.

"Nuestras pruebas a ciegas mostraron que la mayoría de las personas no saben cuándo activamos o desactivamos nuestro algoritmo, no ven artefactos, pero sienten que tienen contacto visual con la persona con la que se están comunicando, "Gilad Michael, otro investigador involucrado en el estudio, dijo a TechXplore.

Curiosamente, Los investigadores observaron que su modelo también había aprendido a predecir la mirada de entrada (es decir, donde pensó que un usuario estaba mirando antes de que se corrigiera su mirada), incluso si nunca fue entrenado para hacer eso. Creen que esta capacidad podría ser un subproducto de la redirección continua del modelo de la mirada del usuario hacia el centro, sin especificar dónde estaba buscando un usuario en primer lugar.

"El modelo simplemente infirió la mirada de entrada para que pueda moverla al centro, "Isikdogan explicó." Por lo tanto, podría decirse que podemos considerar el problema de la corrección del contacto visual como un superconjunto parcial de predicción de la mirada ".

Los hallazgos recopilados por los investigadores también destacan el valor de utilizar datos sintéticos fotorrealistas para entrenar algoritmos. De hecho, su modelo logró resultados notables incluso si durante el entrenamiento se basó casi por completo en imágenes generadas por computadora. Los investigadores están lejos de ser los primeros en experimentar con datos de entrenamiento sintéticos, sin embargo, su estudio es una confirmación más de su potencial para la creación de aplicaciones de alto rendimiento.

"También confirmamos que es una buena práctica tener en cuenta la reversibilidad del mapeo al crear modelos que manipulen sus entradas, "Isikdogan agregó." Por ejemplo, si el modelo mueve algunos píxeles de abajo a la izquierda al centro, deberíamos poder pedirle al modelo que los mueva hacia la parte inferior izquierda y obtenga una imagen que se vea casi idéntica a la imagen original. Este enfoque evita que el modelo modifique las imágenes sin posibilidad de reparación ".

En el futuro, el sistema propuesto por Isikdogan, Michael y su colega Timo Gerasimow podrían ayudar a mejorar las experiencias de videoconferencia, acercándolos aún más a las interacciones en persona. Los investigadores ahora planean finalizar su sistema para que pueda aplicarse a los servicios de videoconferencia existentes.

"Nos esforzamos mucho para asegurarnos de que nuestra solución sea práctica y esté lista para ser utilizada en productos reales, "Dijo Michael." Ahora podríamos intentar mejorar algunos de los resultados secundarios del algoritmo, como la detección de miradas y la calificación de participación para permitir casos de uso adyacentes ".

© 2019 Science X Network