Cuando una computadora pone la cara de Nicolas Cage en la cabeza de Elon Musk, puede que no alinee correctamente la cara y la cabeza. Crédito:Siwei Lyu, CC BY-ND

Los videos de deepfake son difíciles de detectar para los ojos inexpertos porque pueden ser bastante realistas. Ya sea que se utilicen como armas personales de venganza, manipular los mercados financieros o desestabilizar las relaciones internacionales, Los videos que muestran a personas haciendo y diciendo cosas que nunca hicieron o dijeron son una amenaza fundamental para la idea de larga data de que "ver para creer". Ya no.

La mayoría de los deepfakes se hacen mostrando a un algoritmo informático muchas imágenes de una persona, y luego hacer que use lo que vio para generar nuevas imágenes faciales. Al mismo tiempo, su voz se sintetiza, por lo que parece y suena como si la persona hubiera dicho algo nuevo.

Algunos de los trabajos anteriores de mi grupo de investigación nos permitieron detectar videos deepfake que no incluían la cantidad normal de parpadeo de ojos de una persona, pero la última generación de deepfakes se ha adaptado, por lo que nuestra investigación ha seguido avanzando.

Ahora, Nuestra investigación puede identificar la manipulación de un video observando de cerca los píxeles de cuadros específicos. Dando un paso más También desarrollamos una medida activa para proteger a las personas de convertirse en víctimas de deepfakes.

Encontrar defectos

En dos artículos de investigación recientes, describimos formas de detectar deepfakes con fallas que los falsificadores no pueden solucionar fácilmente.

Cuando un algoritmo de síntesis de video deepfake genera nuevas expresiones faciales, las nuevas imágenes no siempre coinciden con la posición exacta de la cabeza de la persona, o las condiciones de iluminación, o la distancia a la cámara. Para hacer que las caras falsas se mezclen con el entorno, tienen que ser geométricamente transformados, rotados, redimensionado o distorsionado de otro modo. Este proceso deja artefactos digitales en la imagen resultante.

Es posible que haya notado algunos artefactos de transformaciones particularmente severas. Estos pueden hacer que una foto parezca obviamente manipulada, como bordes borrosos y piel artificialmente suave. Las transformaciones más sutiles aún dejan evidencia, y hemos enseñado un algoritmo para detectarlo, incluso cuando la gente no puede ver las diferencias.

Estos artefactos pueden cambiar si un video deepfake tiene una persona que no está mirando directamente a la cámara. El video que captura a una persona real muestra su rostro moviéndose en tres dimensiones, pero los algoritmos deepfake aún no pueden fabricar caras en 3-D. En lugar de, generan una imagen bidimensional regular de la cara y luego intentan rotar, cambie el tamaño y distorsione esa imagen para que se ajuste a la dirección en la que la persona debe mirar.

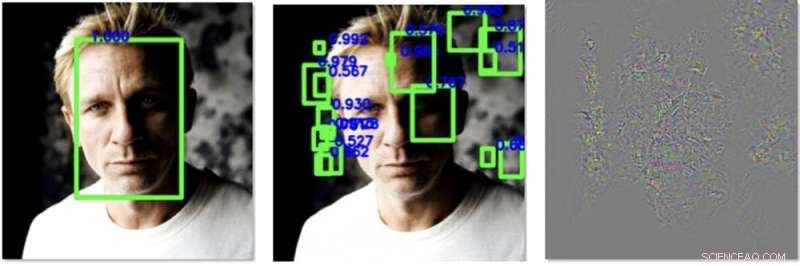

A la izquierda un rostro se detecta fácilmente en una imagen antes de nuestro procesamiento. En el centro, agregamos perturbaciones que hacen que un algoritmo detecte otras caras, pero no el real. A la derecha están los cambios que agregamos a la imagen, mejorado 30 veces para ser visible. Crédito:Siwei Lyu, CC BY-ND

Todavía no lo hacen muy bien lo que brinda una oportunidad para la detección. Diseñamos un algoritmo que calcula hacia dónde apunta la nariz de la persona en una imagen. También mide hacia dónde apunta la cabeza, calculado utilizando el contorno de la cara. En un video real de la cabeza de una persona real, todos deben alinearse de manera bastante predecible. En deepfakes, aunque, a menudo están desalineados.

Defenderse de los deepfakes

La ciencia de la detección de deepfakes es, efectivamente, una carrera de armamentos:los farsantes mejorarán en hacer sus ficciones, por lo que nuestra investigación siempre debe intentar mantenerse al día, e incluso adelantarse un poco.

Si hubiera una forma de influir en los algoritmos que crean deepfakes para que sean peores en su tarea, mejoraría nuestro método para detectar las falsificaciones. Mi grupo ha encontrado recientemente una manera de hacer precisamente eso.

Las bibliotecas de imágenes de rostros se ensamblan mediante algoritmos que procesan miles de fotos y videos en línea y utilizan el aprendizaje automático para detectar y extraer rostros. Una computadora puede mirar una foto de la clase y detectar las caras de todos los estudiantes y del maestro, y agregue solo esas caras a la biblioteca. Cuando la biblioteca resultante tiene muchas imágenes faciales de alta calidad, es más probable que el deepfake resultante tenga éxito en engañar a su audiencia.

Hemos encontrado una manera de agregar ruido especialmente diseñado a fotografías o videos digitales que no son visibles para los ojos humanos pero que pueden engañar a los algoritmos de detección de rostros. Puede ocultar los patrones de píxeles que utilizan los detectores de rostros para localizar un rostro, y crea señuelos que sugieren que hay una cara donde no la hay, como en una pieza del fondo o un cuadrado de la ropa de una persona.

Con menos caras reales y más no caras contaminando los datos de entrenamiento, un algoritmo deepfake será peor para generar una cara falsa. Eso no solo ralentiza el proceso de creación de un deepfake, pero también hace que el deepfake resultante sea más defectuoso y más fácil de detectar.

A medida que desarrollamos este algoritmo, esperamos poder aplicarlo a cualquier imagen que alguien esté cargando en las redes sociales u otro sitio en línea. Durante el proceso de carga, quizás, se les puede preguntar, "¿Quieres proteger los rostros de este video o imagen para que no se utilicen en deepfakes?" Si el usuario elige sí, entonces el algoritmo podría agregar el ruido digital, permitir que las personas en línea vean los rostros, pero ocultándolos de manera efectiva de los algoritmos que podrían intentar hacerse pasar por ellos.

Este artículo se ha vuelto a publicar de The Conversation con una licencia de Creative Commons. Lea el artículo original.