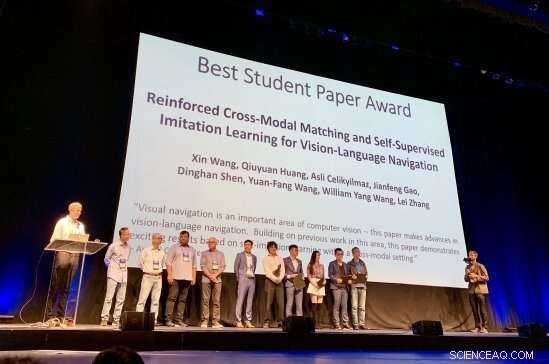

Los investigadores detrás del premio CVPR Best Student Paper Award 2019 son reconocidos por su trabajo Crédito:Matthew Turk

Nueve mil doscientos investigadores de inteligencia artificial. Cinco mil ciento sesenta y cinco trabajos de investigación presentados, de los cuales solo 1, Se aceptaron 300. Uno de los mejores trabajos para estudiantes.

Y el premio fue para:Xin Wang, estudiante de doctorado en ciencias de la computación de la Universidad de California en Santa Bárbara. Su trabajo de estudiante, "Aprendizaje de imitación auto-supervisado y de emparejamiento entre modos reforzado para la navegación visual y del lenguaje, "emergió No. 1 en su categoría en la 31ª Conferencia IEEE / CVF sobre Visión por Computador y Reconocimiento de Patrones (CVPR), una de las conferencias más importantes en el campo de la informática en la actualidad. El evento de premios tuvo lugar en Long Beach, el martes, 18 de junio.

"Xin comenzó a trabajar conmigo en 2017 como estudiante de doctorado en temas relacionados con la investigación del lenguaje y la visión, "dijo William Wang, profesor asistente en el Departamento de Ciencias de la Computación de la Facultad de Ingeniería de UCSB. "Desde marzo de 2018, Hemos estudiado el problema de la navegación entre la visión y el lenguaje:¿Cómo se utilizan las instrucciones verbales para enseñar a los robots a apuntar a destinos? sin acceso a un mapa? "

Un robot que puede navegar basado en la visión y realizar tareas bajo instrucciones en lenguaje común suena a ciencia ficción, pero está más cerca de la realidad de lo que piensas.

"He estado trabajando en la intersección de la visión y el lenguaje durante un tiempo, "Xin Wang dijo, "y creo que uno de los grandes movimientos de la IA es que los robots interactúen con el mundo visual y físico, especialmente a través del lenguaje natural.

"La navegación por lenguaje visual puede permitir muchas aplicaciones prácticas, por ejemplo, robots domésticos, "continuó." Todos, especialmente los discapacitados, puede pedirle al robot que realice ciertas tareas, por ejemplo, "Ve a la cocina y tráeme un vaso de agua". La navegación por lenguaje visual sirve como una tarea básica para comprender tanto las escenas visuales como las instrucciones del lenguaje natural, así como realizar acciones físicas para cumplir trabajos de alto nivel ".

Pero lo que resulta tan natural para las personas, navegar a través de una escena y realizar tareas utilizando señales ambientales en tiempo real y conceptos humanos, requiere una marco elegante en el que los robots pueden aprender a conectar los datos que recogen con el significado de las instrucciones que reciben. Es un proceso iterativo, requiriendo refuerzo, retroalimentación y adaptación. El trabajo de Xin Wang, según su asesor, "presenta varias ideas innovadoras para mejorar la generalización del algoritmo de navegación de visión-lenguaje".

"Este avance en la investigación del lenguaje y la visión permitirá a los robots ayudar mejor a los humanos en muchas rutinas diarias y especiales, incluida la limpieza y el mantenimiento del hogar, búsqueda y recuperación de artículos, control remoto, ayudar a las personas ciegas, alivio de desastres, etcétera, "William Wang dijo." Tiene el potencial de influir en millones de personas y mejorar la calidad de vida de los seres humanos, incluyendo liberar a los humanos de las tediosas tareas domésticas, para que podamos hacer tiempo para actividades creativas ".

La investigación para el CVPR Best Student Paper 2019, que se basa en colaboraciones previas en UCSB sobre aprendizaje reforzado basado en modelos y sin modelos con Ph.D. estudiante Wenhan Xiong, se llevó a cabo en el verano de 2018 durante una pasantía en Microsoft Research (MSR), bajo los mentores Qiuyuan Huang, Asli Celikyilmaz, Jianfeng Gao y Lei Zhang.

Según el comité CVPR Best Paper, "La navegación visual es un área importante de la visión por computadora; este documento hace avances en la navegación del lenguaje de la visión. Sobre la base de trabajos anteriores en esta área, este artículo demuestra resultados interesantes basados en el aprendizaje de la autoimitación dentro de un entorno intermodal ".

"Nos gustaría felicitar a Xin Wang y William Wang por este reconocimiento extremadamente prestigioso por su trabajo en un área que está a la vanguardia de la informática, ", dijo el decano de la Facultad de Ingeniería Rod Alferness." Estamos encantados de que sean parte de la comunidad UCSB ".

"Me siento realmente honrado de recibir este premio, "Dijo Xin Wang." Me gustaría agradecer sinceramente a mis asesores William y Yuan-Fang, ya los colaboradores de MSR por su firme apoyo y valiosa orientación. En cuanto al futuro, Espero que cada vez más investigadores puedan trabajar en esta apasionante y necesaria dirección de investigación, hacia robots más prácticos e interactivos que unan la visión y el lenguaje de los seres humanos. Ciertamente me dedicaré a hacerlo realidad ".